此repo收录了谷歌官方提供的24个预训练好的较小BERT的百度网盘镜像,具体包括官方提供的TensorFlow版和我用Transformers库转换后的pytorch版本模型参数。

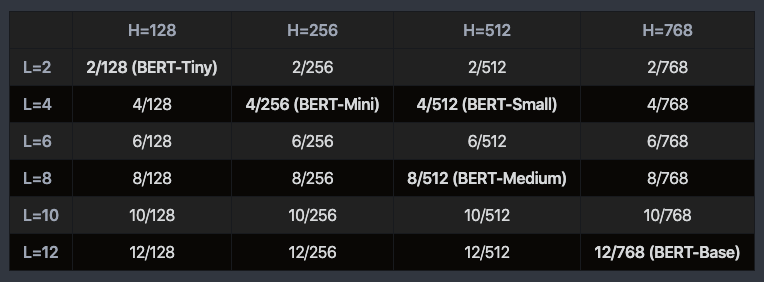

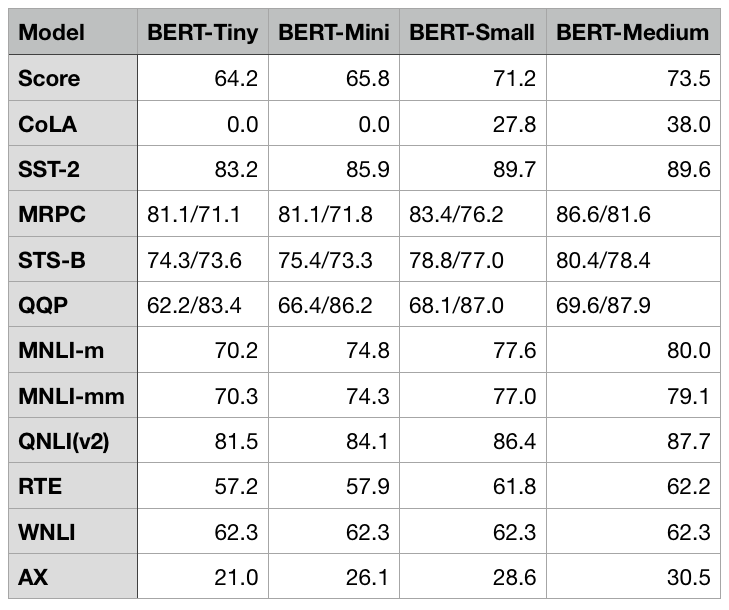

这些小型BERT使用了较小的layers、hidden size或者multi-attention heads,所有24个模型都使用了和BERT-base或BERT-large相同的MLM任务作为预训练目标,它们的使用方式和BERT-base或BERT-large完全一致。这些轻量模型有助于算法的快速迭代或应用部署。24个模型的具体参数配置和部分模型的性能如下:

pytorch版的24个模型打包下载链接:百度网盘 提取码:hc2l

各模型独立的下载链接:

| Layers | Hidden Size | Attention Heads | 链接 |

|---|---|---|---|

| 2 | 128 | 2 | 百度网盘 提取码:lnyy |

| 2 | 256 | 4 | 百度网盘 提取码:a8re |

| 2 | 512 | 8 | 百度网盘 提取码:3b7h |

| 2 | 768 | 12 | 百度网盘 提取码:vo21 |

| 4 | 128 | 2 | 百度网盘 提取码:4sd0 |

| 4 | 256 | 4 | 百度网盘 提取码:nyu9 |

| 4 | 512 | 8 | 百度网盘 提取码:r9e8 |

| 4 | 768 | 12 | 百度网盘 提取码:pelq |

| 6 | 128 | 2 | 百度网盘 提取码:lzr4 |

| 6 | 256 | 4 | 百度网盘 提取码:e15o |

| 6 | 512 | 8 | 百度网盘 提取码:jxcq |

| 6 | 768 | 12 | 百度网盘 提取码:sow7 |

| 8 | 128 | 2 | 百度网盘 提取码:iiq6 |

| 8 | 256 | 4 | 百度网盘 提取码:u4f2 |

| 8 | 512 | 8 | 百度网盘 提取码:pjz6 |

| 8 | 768 | 12 | 百度网盘 提取码:6srn |

| 10 | 128 | 2 | 百度网盘 提取码:v3sw |

| 10 | 256 | 4 | 百度网盘 提取码:6f2j |

| 10 | 512 | 8 | 百度网盘 提取码:wliw |

| 10 | 768 | 12 | 百度网盘 提取码:iznu |

| 12 | 128 | 2 | 百度网盘 提取码:1m8d |

| 12 | 256 | 4 | 百度网盘 提取码:9hea |

| 12 | 512 | 8 | 百度网盘 提取码:43fy |

| 12 | 768 | 12 | 百度网盘 提取码:8z3e |

tf版的24个模型打包下载链接:百度网盘 提取码:uyul

各模型独立的下载链接:

| Layers | Hidden Size | Attention Heads | 链接 |

|---|---|---|---|

| 2 | 128 | 2 | 百度网盘 提取码:s5sz |

| 2 | 256 | 4 | 百度网盘 提取码:wmrt |

| 2 | 512 | 8 | 百度网盘 提取码:rne4 |

| 2 | 768 | 12 | 百度网盘 提取码:6h5b |

| 4 | 128 | 2 | 百度网盘 提取码:vtwu |

| 4 | 256 | 4 | 百度网盘 提取码:iy1k |

| 4 | 512 | 8 | 百度网盘 提取码:4ocf |

| 4 | 768 | 12 | 百度网盘 提取码:3xcc |

| 6 | 128 | 2 | 百度网盘 提取码:4f59 |

| 6 | 256 | 4 | 百度网盘 提取码:hu32 |

| 6 | 512 | 8 | 百度网盘 提取码:zuna |

| 6 | 768 | 12 | 百度网盘 提取码:7pbg |

| 8 | 128 | 2 | 百度网盘 提取码:aeuy |

| 8 | 256 | 4 | 百度网盘 提取码:r7k3 |

| 8 | 512 | 8 | 百度网盘 提取码:yjdm |

| 8 | 768 | 12 | 百度网盘 提取码:6530 |

| 10 | 128 | 2 | 百度网盘 提取码:eqiy |

| 10 | 256 | 4 | 百度网盘 提取码:fpha |

| 10 | 512 | 8 | 百度网盘 提取码:0ipm |

| 10 | 768 | 12 | 百度网盘 提取码:1zwq |

| 12 | 128 | 2 | 百度网盘 提取码:evxu |

| 12 | 256 | 4 | 百度网盘 提取码:hplu |

| 12 | 512 | 8 | 百度网盘 提取码:lfp7 |

| 12 | 768 | 12 | 百度网盘 提取码:z1oe |