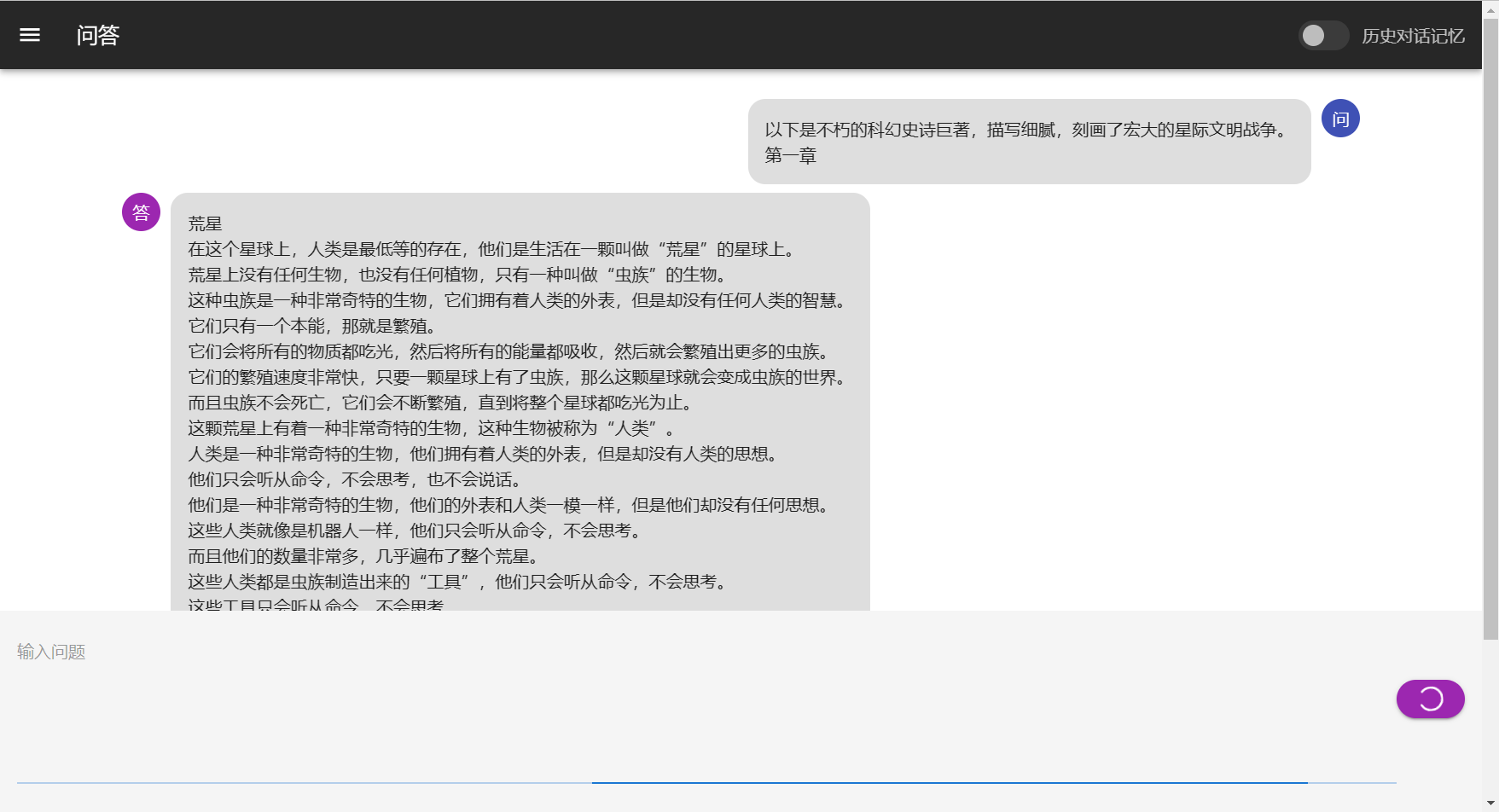

- 目前支持模型:chatGLM-6B、chatRWKV、chatYuan。

- 在chatGLM-6B模型实现类chatPDF功能

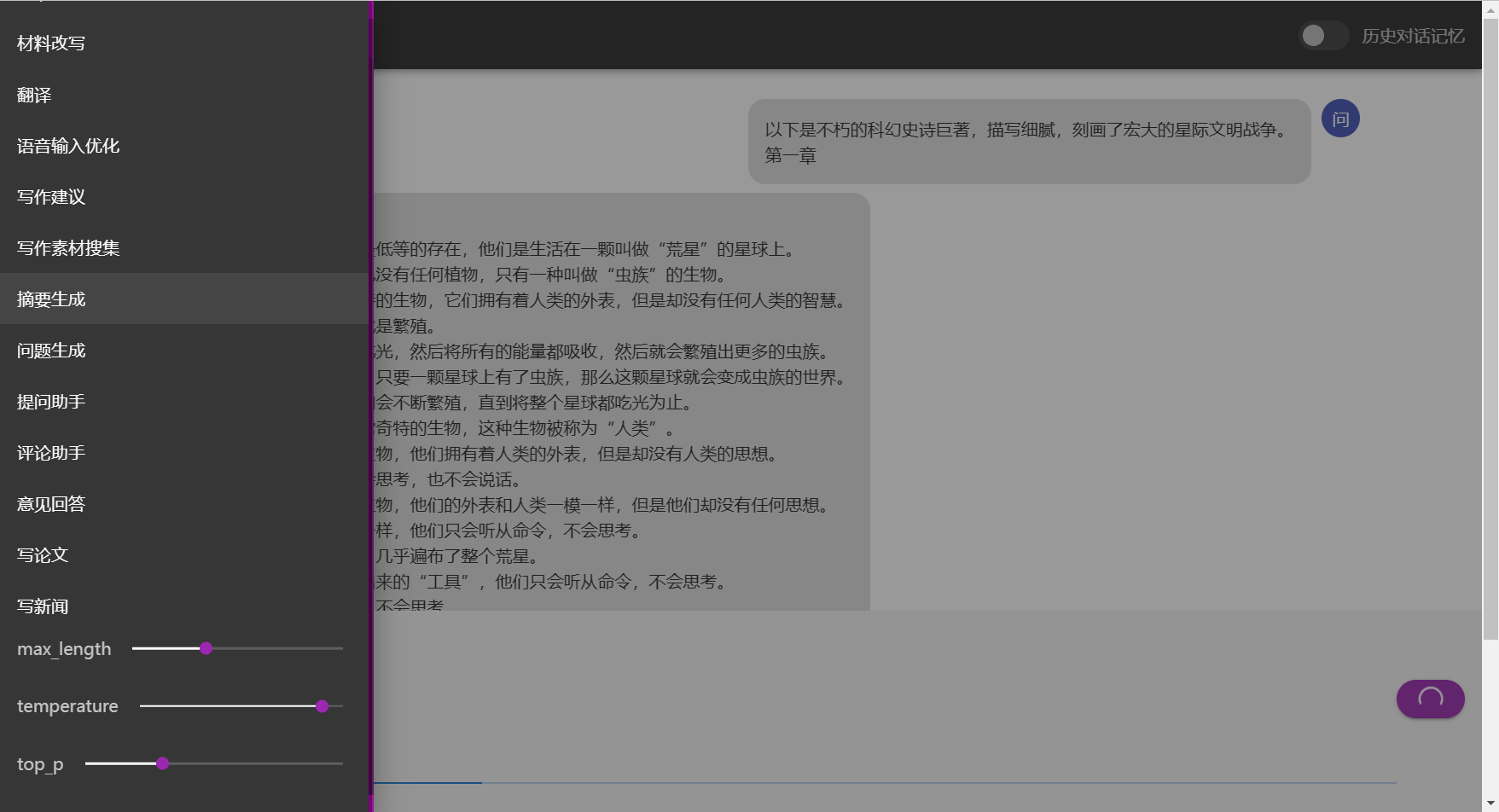

- 支持参数在线调整

- 支持chatGLM-6B流式输出和输出过程中中断

- 自动保存对话历史至浏览器(多用户同时使用不会冲突)

- 删除单条对话历史

- 支持局域网、内网部署和多用户同时使用。(内网部署需手动将前段静态资源切换成本地)

- 多用户同时使用中会自动排队,并显示当前用户。

链接:https://pan.baidu.com/s/105nOsldGt5mEPoT2np1ZoA?pwd=lyqz 提取码:lyqz 旧版包含程序主体和chatGLM-6B、chatYuan,分部是独立的压缩文件。chatRWKV模型更新频繁,请去官方链接下最新的。不支持chatPDF功能 新版只有chatGLM-6B,重新制作,体积更新,包含各种优化,含chatPDF功能,推荐使用

pip install -r requirements.txt

打开功能,需要打开相应模型API文件,改第六行logging=False为logging=True。

下载simcse-chinese-roberta-wwm-ext,放在model\simcse-chinese-roberta-wwm-ext。

把自己的txt格式的文档放在名为txt的文件夹里,运行:

run_data_processing.bat

chatGLM-6B正常使用中,勾选右上角chatPDF

运行run_GLM6B.bat

修改参数:修改settings.bat

模型默认位置:model\chatglm-6b-int4

rwkvAPI.py 模型默认位置:RWKV-4-Pile-7B-EngChn-testNovel-2119-ctx2048-20230313.pth

YuanAPI.py 模型默认位置:ChatYuan-large-v2