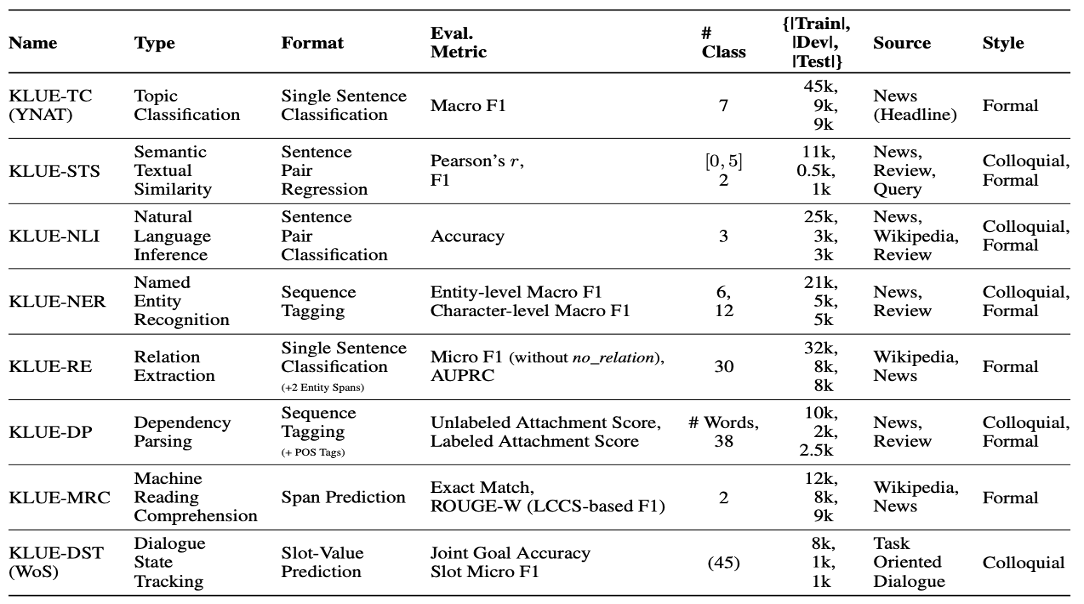

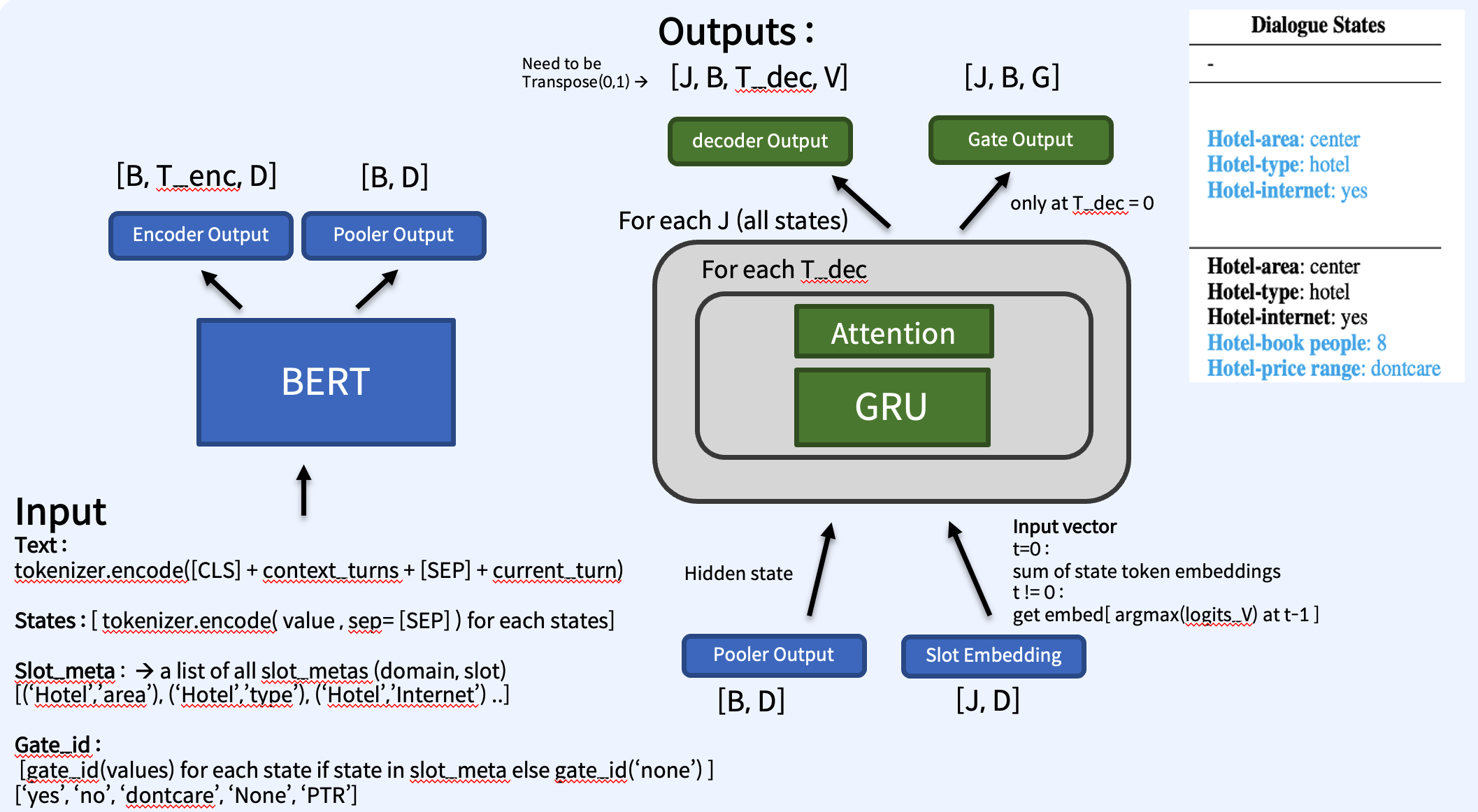

KLUE란 한국어 자연어 이해 평가 데이터셋(Korean Language Understanding Evaluation Benchmark)의 약자로, 한국어 언어모델의 공정한 평가를 위한 목적으로 8개 종류(뉴스 헤드라인 분류, 문장 유사도 비교, 자연어 추론, 개체명 인식, 관계 추출, 형태소 및 의존 구문 분석, 기계 독해 이해, 대화 상태 추적)의 한국어 자연어 이해 문제가 포함된 공개 데이터셋. 추가적으로 한국어 언어 모델의 공정한 성능 비교를 위해 평가 시스템 및 사전학습 Baseline 모델 공개.

transformers==4.27

sentence-transformers==2.2.0

evaluate==0.4.0

datasets==2.10

| Task | Colab |

|---|---|

| KLUE-TC | |

| KLUE-STS | |

| KLUE-NLI | |

| KLUE-NER | |

| KLUE-RE | |

| KLUE-DP | |

| KLUE-MRC | |

| KLUE-DST |

https://arxiv.org/pdf/2105.09680.pdf

https://github.com/KLUE-benchmark/KLUE-baseline