k8s-cka-certified

Tabla de contenidos

- Tabla de contenidos

- 01. Introduccion

- 02. Core Concepts

- 03. Scheduling

- 04. Logging & monitoring

- 05. Application Lifecycle Management

- 06. Cluster maintenance

- 07. Security

- 08. Storage

- 09. Networking

- 10. Install kubernetes hard way

- 11. Install kubernetes the kubeadm

- 12. End to End test on a Kubernetes cluster

- 13. Troubleshooting

- 14. Other Topics

01 - Introducción

La finalidad de este repositorio es tener una guia para obtener la certificación de Kubernetes CKA.

Introducción al curso:

- El examen se puede comprar en la siguiente web: https://www.cncf.io/certification/cka/

- En caso de examen fallido, podrá presentarse de nuevo sin coste, en un plazo máximo de 12 meses.

- No es un examen convencional, sino ejercicios que ponen a prueba sus conocimientos.

- Podrá consultar la documentación oficial de kubernetes en el examen

01.1 - Detalles de la certificación

Algunas referencias al examen:

- Administrador Certificado de Kubernetes: https://www.cncf.io/certification/cka/

- Plan de estudios del examen (temas): https://github.com/cncf/curriculum

- Manual del candidato: https://www.cncf.io/certification/candidate-handbook

- Consejos para el examen: http://training.linuxfoundation.org/go//Important-Tips-CKA-CKAD

Use the code - show code in Udemy - while registering for the CKA or CKAD exams at Linux Foundation to get a 15% discount.

02 - Conceptos principales

02.1 - Arquitectura del Cluster

El propósito de Kubernetes es alojar sus aplicaciones en forma de Pods de manera automatizada, para que pueda implementar tantas instancias como necesite, y facilitar la comunicación entre sus aplicaciones.

Un cluster de kubernetes consta de un conjunto de nodos (fisicos o virtuales), que alojan aplicaciones en forma de Pods.

- Los nodos Masters, son los responsables de administrar el cluster, y todas las tareas las lleva a través de un conjunto de componentes, llamados Control Plane (Plano de Control).

- Los nodos Workers, están destinados a alojar los Pods.

Componentes del Plano de Control:

- ETCD: es una base de datos que almacena la información en un formato clave-valor (key-value).

- kube-scheduler: es un componente del cluster que se encarga de planificar donde se alojarán los Pods, en base a etiquetas del Nodo o del Pod, capacidad, políticas o restricciones, y afinidad entre el Nodo y el Pod.

- Node-Controller: se encarga de los Nodos, es el responsable de comprobar si los nodos están disponibles o no.

- Replication-Controller: se encarga de los Pods, y de que se estén ejecutando el número de Pods que indica su Replication-Groups.

- kube-apiserver: es el componente de gestión principal, es el responsable de orquestar todas las operaciones del cluster. Expone el API de Kubernetes que utilizan los usuarios externos para realizar operaciones de administración, asi como los distintos controladores para monitorizar el cluster.

Dado que las aplicaciones se ejecutan en contendores, los nodos (Master y Workers) necesitarán tener un motor para ejecutarlos (Containe Runtime), uno popular es Docker. Kubernetes es compatible con otros Containers Runtime, como ContainerD o Rocket (RKT).

- Kubelet: es un servicio que se ejecuta en todos los nodos, escucha las intrucciones del kube-apiserver, y destruye o crea contenedores en base a la información que le proporciona el kube-apiserver.

- kube-apiserver: solicita información sobre el estado de los Pods que se encuentran en los nodos, a través de Kubelet.

- kube-proxy: es un servicio que corre en todos los nodos, y mantiene la comunicación entre nodos, para la comunicación entre Pods.

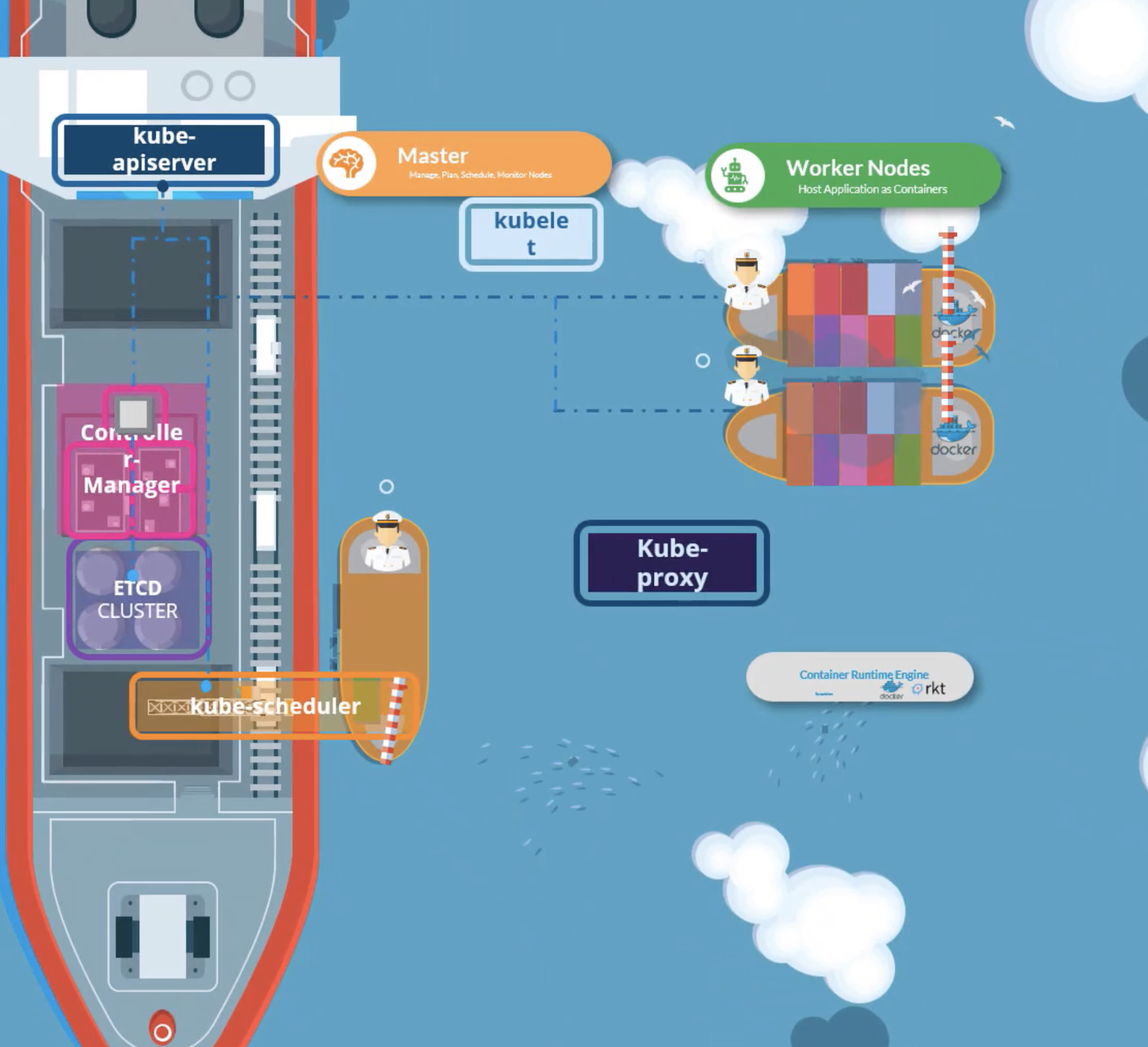

Ejemplo de arquitectura con buques.

Ejemplo de arquitectura con buques.

02.2 - ETCD

02.2.1 - Que es ETCD

ETCD es una base de datos clave-valor distribuida que es simple, segura y rápida.

02.2.1 - Como instalar ETCD

Puede usar ETCD ejecutando los siguientes pasos:

# Download file

curl -L https://github.com/coreos/etcd/releases/download/v3.3.1/etcd-v3.3.1-linux-amd64.tar.gz -o etcd-v3.3.1-linux-amd64.tar.gz

# decompress:

tar xzvf etcd-v3.3.1-linux-amd64.tar.gz

# Execute:

./etcdCuando ejecuta ETCD inicia un servicio que escucha en el puerto 2380 por defecto.

Existe un cliente de linea de comando que permite interactuar con la BBDD:

# Set value

./etcdctl set key1 value1

# Get value

./etcdctl get key102.2.2 - ETCD en Kubernetes

ETCD almacena información sobre Nodos, Pods, Roles, Secrets, etc.

Toda la información que proviene de kubectl (cliente de kubernetes en linea de comandos), proviene de ETCD. Cada cambio que realicemos en el cluster actualiza el ETCD, solo una vez que se actualice ETCD, el cambio se considerará completo.

Puede configurar ETCD de distintas formas, en este caso configuraremos ETCD desde cero, y con kubeadm.

- Configuración manual:

# Descargamos el fichero

wget -q --https-only \ "https://github.com/coreos/etcd/releases/download/v3.3.9/etcd-v3.3.9-linux-amd64.tar.gz"

# Show etcd.service

etcd.service

ExecStart=/usr/local/bin/etcd \\

--name ${ETCD_NAME} \\

--cert-file=/etc/etcd/kubernetes.pem \\

--key-file=/etc/etcd/kubernetes-key.pem \\

--peer-cert-file=/etc/etcd/kubernetes.pem \\

--peer-key-file=/etc/etcd/kubernetes-key.pem \\

--trusted-ca-file=/etc/etcd/ca.pem \\

--peer-trusted-ca-file=/etc/etcd/ca.pem \\

--peer-client-cert-auth \\

--client-cert-auth \\

--initial-advertise-peer-urls https://${INTERNAL_IP}:2380 \\

--listen-peer-urls https://${INTERNAL_IP}:2380 \\

--listen-client-urls https://${INTERNAL_IP}:2379,https://127.0.0.1:2379 \\

--advertise-client-urls https://${INTERNAL_IP}:2379 \\

--initial-cluster-token etcd-cluster-0 \\

--initial-cluster-controller-0=https://${CONTROLLER0_IP}:2380,controller-1=https://${CONTROLLER1_IP}:2380 \\ # ETCD Nodes IPs

--initial-cluster-state new \\

--data-dir=/var/lib/etcd- Configuración con kubeadm:

# Implementación como pod

kubectl get pods -n kube-system | grep etc

NAMESPACE NAME READY STATUS RESTARTS AGE

kube-system etcd-master 1/1 Running 0 1h

# Interactua con la BBDD desde dentro del pod

kubectl exec etcd-master –n kube-system etcdctl get / --prefix –keys-only

/registry/apiregistration.k8s.io/apiservices/v1.

/registry/apiregistration.k8s.io/apiservices/v1.apps

/registry/apiregistration.k8s.io/apiservices/v1.authentication.k8s.io

/registry/apiregistration.k8s.io/apiservices/v1.authorization.k8s.io

/registry/apiregistration.k8s.io/apiservices/v1.autoscaling

/registry/apiregistration.k8s.io/apiservices/v1.batch

/registry/apiregistration.k8s.io/apiservices/v1.networking.k8s.io

/registry/apiregistration.k8s.io/apiservices/v1.rbac.authorization.k8s.io

/registry/apiregistration.k8s.io/apiservices/v1.storage.k8s.ioEn un entorno de alta disponibilidad (HA), tendrá varios nodos Masters, y tendrá varias instancias de ETCD distribuidas entre los nodos Masters. En ese caso, tendrá que configurar la declaración y conexión entre los nodos del cluster de ETCD

# Show etcd.service

etcd.service

ExecStart=/usr/local/bin/etcd \\

--name ${ETCD_NAME} \\

--cert-file=/etc/etcd/kubernetes.pem \\

--key-file=/etc/etcd/kubernetes-key.pem \\

--peer-cert-file=/etc/etcd/kubernetes.pem \\

--peer-key-file=/etc/etcd/kubernetes-key.pem \\

--trusted-ca-file=/etc/etcd/ca.pem \\

--peer-trusted-ca-file=/etc/etcd/ca.pem \\

--peer-client-cert-auth \\

--client-cert-auth \\

--initial-advertise-peer-urls https://${INTERNAL_IP}:2380 \\

--listen-peer-urls https://${INTERNAL_IP}:2380 \\

--listen-client-urls https://${INTERNAL_IP}:2379,https://127.0.0.1:2379 \\

--advertise-client-urls https://${INTERNAL_IP}:2379 \\

--initial-cluster-token etcd-cluster-0 \\

--initial-cluster controller-0=https://${CONTROLLER0_IP}:2380,controller-1=https://${CONTROLLER1_IP}:2380 \\

--initial-cluster-state new \\

--data-dir=/var/lib/etcd02.2.3 - ETCD commands

etcdctl es la herramienta CLI utilizada para interactuar con ETCD.

ETCDCTL puede interactuar con el Servidor ETCD utilizando 2 versiones de la API - Versión 2 y Versión 3.

Por defecto está configurado para usar la versión 2. Cada versión tiene diferentes conjuntos de comandos.

Soporta los siguientes comandos:

# Version 2

etcdctl backup

etcdctl cluster-health

etcdctl mk

etcdctl mkdir

etcdctl set

# Version 3

etcdctl snapshot save

etcdctl endpoint health

etcdctl get

etcdctl put

# Para establecer la versión correcta de la API establezca la variable de entorno ETCDCTL_API

export ETCDCTL_API=3Debes especificar la ruta a los archivos de certificado para que ETCDCTL pueda autenticarse en el servidor de la API de ETCD. Los archivos de certificados están disponibles en el etcd-master en la siguiente ruta.

--cacert /etc/kubernetes/pki/etcd/ca.crt

--cert /etc/kubernetes/pki/etcd/server.crt

--key /etc/kubernetes/pki/etcd/server.keyComando final:

kubectl exec etcd-master -n kube-system -- sh -c "ETCDCTL_API=3 02.3 - Kube API Server

API Server, es el componente de adminstración principal del cluster de kubernetes.

Cuando ejecuta comandos con kubectl, la solicitud llega al APIServer, este primero autentica la solicitud y la valida, obtiene los datos del ETCD y responde con la información solicitada.

Flujo de creación de objetos (para realizar los cambios se sigue un flujo similar):

- APIServer crea un Pod sin asignarlo a ningún nodo.

- APIServer actualiza el estado del pod en cluster de ETCD.

- APIServer responde al usuario sobre el estado de su solicitud.

- Scheduler monitoriza el APIServer, y se da cuenta de que hay un nuevo Pod sin asignar a ningún nodo.

- Scheduler identifica el nodo correcto, y se lo comunica al APIServer.

- APIServer actualiza ETCD con la nueva información.

- APIServer se comunica con el nodo donde se va colocar el pod, a través de kubelet.

- Kubelet crea el pod y comunica al Container Runtime la imagen o imagenes del Pod.

- Kubelet actualiza el estado del Pod al APIServer.

- APIServer actualiza el estado del Pod a ETCD.

APIServer es el responsable de autenticar, validar solicitudes, recuperar y actualizar datos en el cluster de ETCD (es el único componente que se comunica con el).

La arquitectura de Kubernetes consiste en una gran cantidad de componentes diferentes que trabajan entre si.

Depende como configure su cluster, podrá ver las opciones de kube-APIServer.

- Manifiesto YAML

cat /etc/kubernetes/manifests/kube-apiserver.yaml

...

spec:

containers:

- command:

- kube-apiserver

- --authorization-mode=Node,RBAC

- --advertise-address=172.17.0.32

- --allow-privileged=true

- --client-ca-file=/etc/kubernetes/pki/ca.crt

- --disable-admission-plugins=PersistentVolumeLabel

- --enable-admission-plugins=NodeRestriction

- --enable-bootstrap-token-auth=true

- --etcd-cafile=/etc/kubernetes/pki/etcd/ca.crt

- --etcd-certfile=/etc/kubernetes/pki/apiserver-etcd-client.crt

- --etcd-keyfile=/etc/kubernetes/pki/apiserver-etcd-client.key

- --etcd-servers=https://127.0.0.1:2379

- --insecure-port=0

- --kubelet-client-certificate=/etc/kubernetes/pki/apiserver-kubelet-client.crt

- --kubelet-client-key=/etc/kubernetes/pki/apiserver-kubelet-client.key

- --kubelet-preferred-address-types=InternalIP,ExternalIP,Hostname

- --proxy-client-cert-file=/etc/kubernetes/pki/front-proxy-client.crt

- --proxy-client-key-file=/etc/kubernetes/pki/front-proxy-client.key

- --requestheader-allowed-names=front-proxy-client

- --requestheader-client-ca-file=/etc/kubernetes/pki/front-proxy-ca.crt

- --requestheader-extra-headers-prefix=X-Remote-Extra-

- --requestheader-group-headers=X-Remote-Group

- --requestheader-username-headers=X-Remote-User

...- Como servicio:

cat /etc/systemd/system/kube-apiserver.service

[Service] ExecStart=/usr/local/bin/kube-apiserver \\

--advertise-address=${INTERNAL_IP} \\

--allow-privileged=true \\

--apiserver-count=3 \\

--audit-log-maxage=30 \\

--audit-log-maxbackup=3 \\

--audit-log-maxsize=100 \\

--audit-log-path=/var/log/audit.log \\

--authorization-mode=Node,RBAC \\

--bind-address=0.0.0.0 \\

--client-ca-file=/var/lib/kubernetes/ca.pem \\

--enable-admission-plugins=Initializers,NamespaceLifecycle,NodeRestriction,LimitRanger,ServiceAccount,Defa ultStorageClass,ResourceQuota \\

--enable-swagger-ui=true \\

--etcd-cafile=/var/lib/kubernetes/ca.pem \\

--etcd-certfile=/var/lib/kubernetes/kubernetes.pem \\

--etcd-keyfile=/var/lib/kubernetes/kubernetes-key.pem \\

--etcd-servers=https://10.240.0.10:2379,https://10.240.0.11:2379,https://10.240.0.12:2379 \\

--event-ttl=1h \\

--experimental-encryption-provider-config=/var/lib/kubernetes/encryption-config.yaml \\

--kubelet-certificate-authority=/var/lib/kubernetes/ca.pem \\

--kubelet-client-certificate=/var/lib/kubernetes/kubernetes.pem \\- Como proceso:

ps -aux | grep kube-apiserver

root 2348 3.3 15.4 399040 315604 ? Ssl 15:46 1:22 kube-apiserver --authorization-mode=Node,RBAC -- advertise-address=172.17.0.32 --allow-privileged=true --client-ca-file=/etc/kubernetes/pki/ca.crt

--disable- admission-plugins=PersistentVolumeLabel --enable-admission-plugins=NodeRestriction--enable-bootstrap-token- auth=true --etcd-cafile=/etc/kubernetes/pki/etcd/ca.crt

--etcd-certfile=/etc/kubernetes/pki/apiserver-etcd- client.crt --etcd-keyfile=/etc/kubernetes/pki/apiserver-etcd-client.key --etcd-servers=https://127.0.0.1:2379 -- insecure-port=0

--kubelet-client-certificate=/etc/kubernetes/pki/apiserver-kubelet-client.crt --kubelet-client- key=/etc/kubernetes/pki/apiserver-kubelet-client.key

--kubelet-preferred-address-types=InternalIP,ExternalIP,Hostname --proxy-client-cert-file=/etc/kubernetes/pki/front-proxy-client.crt --proxy- client-key-file=/etc/kubernetes/pki/front-proxy-client.key--requestheader-allowed-names=front-proxy-client --requestheader-client-ca-file=/etc/kubernetes/pki/front-proxy-ca.crt

--requestheader-extra-headers-prefix=X-Remote-Extra- --requestheader-group-headers=X-Remote-Group

--requestheader-username-headers=X-Remote-User --secure- port=6443 --service-account-key-file=/etc/kubernetes/pki/sa.pub --service-cluster-ip-range=10.96.0.0/12

--tls-cert-file=/etc/kubernetes/pki/apiserver.crt --tls-private-key-file=/etc/kubernetes/pki/apiserver.key02.4 - Kube Controller Manager

En terminos de kubernetes, un controlador es un proceso que monitoriza el estado de varios componentes dentro del sistema y trabaja para llevar todo el sistema al estado deseado.

- Node Controller: verifica el estado de los nodos cada 5 segundos. Si deja de recibir datos de un nodo, espera 40 segundos antes de marcarlo como inalcanzable. Después de marcarlo como inalcanzable, espera 5 minutos para ver que reconecte, si no lo hace elimina los Pods asignados a ese nodo, y lo hace en otro sano.

- Replication Controller: se encarga de monitorizar los ReplicaSets y garantiza el número deseados.

Hay muchos otros Controllers, y están empaquetados en un solo proceso conocido como Controller Manager.

- Puede encontrarlo como Pod:

kubectl get pods -n kube-system

NAMESPACE NAME READY STATUS RESTARTS AGE

kube-system coredns-78fcdf6894-hwrq9 1/1 Running 0 1h

kube-system coredns-78fcdf6894-rzhjr 1/1 Running 0 1h

kube-system etcd-master 1/1 Running 0 1h

kube-system kube-apiserver-master 1/1 Running 0 1h

kube-system kube-controller-manager-master 1/1 Running 0 1h

kube-system kube-proxy-lzt6f 1/1 Running 0 1h

kube-system kube-proxy-lz1sf 1/1 Running 0 1h

kube-system kube-scheduler-master 1/1 Running 0 1h

kube-system weave-net-12ffc 1/1 Running 0 1h- Como servicio:

cat /etc/kubernetes/manifests/kube-controller-manager.yaml

...

spec:

containers:

- command:

- kube-controller-manager

- --address=127.0.0.1

- --cluster-signing-cert-file=/etc/kubernetes/pki/ca.crt

- --cluster-signing-key-file=/etc/kubernetes/pki/ca.key

- --controllers=*,bootstrapsigner,tokencleaner

- --kubeconfig=/etc/kubernetes/controller-manager.conf

- --leader-elect=true

- --root-ca-file=/etc/kubernetes/pki/ca.crt

- --service-account-private-key-file=/etc/kubernetes/pki/sa.key

- --use-service-account-credentials=true

...02.5 - Kube Scheduler

El Scheduler, es el proceso que indica donde irá cada Pod, no los coloca el mismo, en este caso lo hace Kubelet.

El Scheduler pasa por dos fases para identificar el mejor nodo:

- Filtra los nodos que no se ajustan al perfil del Pod. (Por ejemplo, descarta los nodos que no tienen suficientes recursos)

- Con los nodos restantes, utiliza una función de prioridad puntuando a los nodos de 0 a 10. Calculando el espacio que quedará disponible en un nodo si el pod se desplegase en el (a más espacio disponible - mejor puntuación).

Hay más factores a que tener en cuenta como, Limits, Taints y Tolerations, NodeSelectors o Affinity.

- Instalando Scheduler como servicio:

kube-scheduler.service

ExecStart=/usr/local/bin/kube-scheduler \\

--config=/etc/kubernetes/config/kube-scheduler.yaml \\

--v=2- Opciones de schuduler:

cat /etc/kubernetes/manifests/kube-scheduler.yaml

...

spec:

containers:

- command:

- kube-scheduler

- --address=127.0.0.1

- --kubeconfig=/etc/kubernetes/scheduler.conf - --leader-elect=true

...02.6 - Kubelet

Kubelet es el agente de Kubernetes desplegado en cada nodo y se encarga de:

- Registar el nodo en cluster.

- Cuando recibe la orden de crear un contenedor, se lo indica al Container Runtime (Docker, ContainerD, RLT, etc), para que descargue la imagen y lo instancie en el nodo.

- Monitoriza los Pods, y envía informes al API Server.

Kubelet no se instala automáticamente, el agente se instala en cada nodo como servicio.

kubelet.service

ExecStart=/usr/local/bin/kubelet \\

--config=/var/lib/kubelet/kubelet-config.yaml \\

--container-runtime=remote \\

--container-runtime-endpoint=unix:///var/run/containerd/containerd.sock \\

--image-pull-progress-deadline=2m \\

--kubeconfig=/var/lib/kubelet/kubeconfig \\

--network-plugin=cni \\

--register-node=true \\

--v=2Las opciones de kubelet pueden verse si observamos el proceso:

ps -aux | grep kubelet

root 2095 1.8 2.4 960676 98788 ? Ssl 02:32 0:36 /usr/bin/kubelet --bootstrap- kubeconfig=/etc/kubernetes/bootstrap-kubelet.conf --kubeconfig=/etc/kubernetes/kubelet.conf -- config=/var/lib/kubelet/config.yaml --cgroup-driver=cgroupfs --cni-bin-dir=/opt/cni/bin --cni- conf-dir=/etc/cni/net.d --network-plugin=cni02.7 - Kube-proxy

Dentro de un cluster de Kubernetes, cada Pod puede tener comunicación con cualquier otro Pod.

Esto se logra mediante la implementación de una red entre los Pods. Una red virtual se extiende por todo el cluster, a la que se conectan todos los Pods, cuando se crea un Service, kube-proxy lo escanea y crea las reglas necesarias, una forma de hacerlo es con Iptables.

Kube-proxy se implementa como DaemonSet (Pod por nodo).

02.8 - Pods

Un Pod un conjunto de propiedades definidas en un fichero YAML, este fichero contiene la definición del objeto y agrupa uno o varios contenedores.

Un Pod, es la unidad más pequeña en Kubernetes.

#Versión de la API de Kubernetes que estás usando para crear el objeto (String). Es una propiedad obligatoria. Ej: apps/v1, v1, ...

apiVersion: v1

#Tipo de objeto que tratamos de crear (String). Es una propiedad obligatoria. Ej: ReplicaSet, Deployment, Service, ...

kind: Pod

#Permite indicar datos sobre el objecto (diccionario), como el nombre, namespace, labels, etc. Es una propiedad obligatoria.

metadata:

name: myapp-pod

#Permite identificar un objeto y relacionarlo con otros, por ejemplo un Service, podría apuntar a este pod a través de sus Labels.

labels:

app: myapp

type: front-end

#Bajo esta propiedad se indican configuracaciones específicas para este Pod. Es una propiedad obligatoria

spec:

#Propiedad que define los contenedores que se declaran en este Pod (List), dado que puede haber uno o más.

containers:

- name: nginx-container

image: nginxDefinimos algunos comando importantes relativos a los Pods.

- Crear a partir de la definición en un fichero

kubectl create -f pod.yaml

pod/myapp-pod created!- Obtener todos los Pods de un namespace:

kubectl -n kube-system get pod

NAME READY STATUS RESTARTS AGE

coredns-74ff55c5b-twd8d 1/1 Running 0 20s

etcd-minikube 1/1 Running 0 31s

kube-apiserver-minikube 1/1 Running 0 31s

kube-controller-manager-minikube 1/1 Running 0 31s

kube-proxy-h29mh 1/1 Running 0 20s

kube-scheduler-minikube 1/1 Running 0 31s

storage-provisioner 1/1 Running 0 33s- Obtener información de los Pods:

kubectl -n kube-system get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

coredns-74ff55c5b-twd8d 1/1 Running 0 13m 172.17.0.2 node01 <none> <none>

etcd-minikube 1/1 Running 0 13m 192.168.49.2 node01 <none> <none>

kube-apiserver-minikube 1/1 Running 0 13m 192.168.49.2 node01 <none> <none>

kube-controller-manager-minikube 1/1 Running 0 13m 192.168.49.2 node01 <none> <none>

kube-proxy-h29mh 1/1 Running 0 13m 192.168.49.2 node01 <none> <none>

kube-scheduler-minikube 1/1 Running 0 13m 192.168.49.2 node01 <none> <none>

storage-provisioner 1/1 Running 1 13m 192.168.49.2 node01 <none> <none>- Obtener información sobre un Pod existente en el cluster (Etiquetas, variables, Contanedores, IP, volumenes, puntos de montaje, etc)

kubectl -n kube-system describe pod kube-proxy-h29mh

Name: kube-proxy-h29mh

Namespace: kube-system

Priority: 2000001000

Priority Class Name: system-node-critical

Node: minikube/192.168.49.2

Start Time: Mon, 03 May 2021 15:39:13 +0200

Labels: controller-revision-hash=b89db7f56

k8s-app=kube-proxy

pod-template-generation=1

Annotations: <none>

Status: Running

IP: 192.168.49.2

IPs:

IP: 192.168.49.2

Controlled By: DaemonSet/kube-proxy

Containers:

kube-proxy:

Container ID: docker://86b1f246816bd3fc3354df5e7d6ffcace8ba9826f240c3936e3cb2ccbf0c6445

Image: k8s.gcr.io/kube-proxy:v1.20.2

Image ID: docker-pullable://k8s.gcr.io/kube-proxy@sha256:326fe8a4508a5db91cf234c4867eff5ba458bc4107c2a7e15c827a74faa19be9

Port: <none>

Host Port: <none>

Command:

/usr/local/bin/kube-proxy

--config=/var/lib/kube-proxy/config.conf

--hostname-override=$(NODE_NAME)

State: Running

Started: Mon, 03 May 2021 15:39:14 +0200

Ready: True

Restart Count: 0

Environment:

NODE_NAME: (v1:spec.nodeName)

Mounts:

/lib/modules from lib-modules (ro)

/run/xtables.lock from xtables-lock (rw)

/var/lib/kube-proxy from kube-proxy (rw)

/var/run/secrets/kubernetes.io/serviceaccount from kube-proxy-token-kntxm (ro)

Conditions:

Type Status

Initialized True

Ready True

ContainersReady True

PodScheduled True

Volumes:

kube-proxy:

Type: ConfigMap (a volume populated by a ConfigMap)

Name: kube-proxy

Optional: false

xtables-lock:

Type: HostPath (bare host directory volume)

Path: /run/xtables.lock

HostPathType: FileOrCreate

lib-modules:

Type: HostPath (bare host directory volume)

Path: /lib/modules

HostPathType:

kube-proxy-token-kntxm:

Type: Secret (a volume populated by a Secret)

SecretName: kube-proxy-token-kntxm

Optional: false

QoS Class: BestEffort

Node-Selectors: kubernetes.io/os=linux

Tolerations: op=Exists

CriticalAddonsOnly op=Exists

node.kubernetes.io/disk-pressure:NoSchedule op=Exists

node.kubernetes.io/memory-pressure:NoSchedule op=Exists

node.kubernetes.io/network-unavailable:NoSchedule op=Exists

node.kubernetes.io/not-ready:NoExecute op=Exists

node.kubernetes.io/pid-pressure:NoSchedule op=Exists

node.kubernetes.io/unreachable:NoExecute op=Exists

node.kubernetes.io/unschedulable:NoSchedule op=Exists

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal Scheduled 2m default-scheduler Successfully assigned kube-system/kube-proxy-h29mh to minikube

Normal Pulled 119s kubelet Container image "k8s.gcr.io/kube-proxy:v1.20.2" already present on machine

Normal Created 119s kubelet Created container kube-proxy

Normal Started 119s kubelet Started container kube-proxy- Crear Pods en linea de comandos:

kubectl run nginx --imagen=nginx- Crear un manifiesto de un pod a través de kubectl

kubectl run redis --image=redis --dry-run=client -o yaml > pod.yaml

# Mostramos el fichero generado

cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

creationTimestamp: null

labels:

run: redis

name: redis

spec:

containers:

- image: redis

name: redis

resources: {}

dnsPolicy: ClusterFirst

restartPolicy: Always

status: {}02.9 - ReplicaSet

El objeto ReplicaSet, garantiza que el número de replicas indicadas en el objeto, esté siempre disponibles. Permite escalar y balancear si fuera necesarios, creando más replicas en el mismo nodo, incluso en otros, de tal forma que para el usuario es transparente.

En Clusters con versiones más antiguas, podemos encontranos Replication Controller, y en cluster con versiones más modernas, ReplicaSet.

- Replication Controller:

apiVersion: v1

kind: ReplicationController

metadata: # Metadata para el ReplicationController.

name: myapp-rc

labels:

app: myapp

type: front-end

spec: # Especificaciones para el ReplicacionController.

template: # Definimos una plantilla para las réplicas que controlará este objeto. Que contendrá las mismas propiedades que un Pod.

metadata: # Metadata para el Pod.

name: myapp-pod

labels:

app: myapp

type: front-end

spec: # Especificaciones para el Pod.

containers:

- name: nginx-container

image: nginx

replicas: 3 # Número de réplicas del Pod.- Creamos el Replication Controller definido:

kubectl create -f rc-definition.yaml

replicationconrtoller "myapp-rc" created!

# Listamos los Replication Controllers

kubectl get replicationcontrollers

NAME DESIRED CURRENT READY AGE

myapp-rc 3 3 3 72s

# Listamos los pods

kubectl get pod

NAME READY STATUS RESTARTS AGE

myapp-rc-gr4hm 1/1 Running 0 33s

myapp-rc-kwm72 1/1 Running 0 33s

myapp-rc-szjkd 1/1 Running 0 33s- Replica Set:

apiVersion: apps/v1 # apiVersion cambia con respecto a los RCs

kind: ReplicationSet

metadata: # Metadata para el ReplicaSet.

name: myapp-replicaset

labels:

app: myapp

type: front-end

spec: # Especificaciones para el ReplicaSet.

template: # Definimos una plantilla para las réplicas que controlará este objeto. Que contendrá las mismas propiedades que un Pod.

metadata: # Metadata para el Pod.

name: myapp-pod

labels:

app: myapp

type: front-end

spec: # Especificaciones para el Pod.

containers:

- name: nginx-container

image: nginx

replicas: 3 # Número de réplicas del Pod.

selector: # Esta propiedad es la diferencia entre RS y RC, prmite identificar que partes se encuentran bajo el

matchLabels:

type: front-end- Creamos el ReplicationSet definido:

kubectl create -f rc-definition.yaml

replicationconrtoller "myapp-replicaset" created!

# Listamos los ReplicaSet

kubectl get replicaset

NAME DESIRED CURRENT READY AGE

myapp-replicaset 3 3 3 72s

# Listamos los pods

kubectl get pod

NAME READY STATUS RESTARTS AGE

myapp-replicaset-gr4hm 1/1 Running 0 33s

myapp-replicaset-kwm72 1/1 Running 0 33s

myapp-replicaset-szjkd 1/1 Running 0 33sLos Labels, permiten identificar los objetos de kubernetes, a través de estas etiquetas proporcionamos un filtro para los ReplicaSets.

Podemos escalar las réplicas de distintas formas:

# Editar el manifiesto replicaset-definition.yaml

vim replicaset-definition.yaml # set a new value

kubectl replace -f replicaset-definition.yaml

# Editar el Replicaset and change replica property

kubectl edit myapp-replicaset

# Seteando nuevo valor con kubectl

kubectl scale --replicas=6 -f replicast-definition.yaml

kubectl scale --replicas=6 replicaset myapp-replicaset 02.10 - Deployments

Los Deployments, son objectos de kubernetes, que permiten ejecutar Rolling update, Roll-backs, actualizar la versión de sus aplicaciones, cambiar asignaciones de recursos, variables de entorno, escalado, pausar y reanudar cambios según la necesidad, etc.

Para comprender que otros objectos controlan los Deployments observemos la siguiente imagen. IMAGEN DEPLOYMENT

Un ejemplo de manifiesto de Deployment:

apiVersion: apps/v1

# Con respecto a los RS, cambia la propiedad Kind

kind: Deployment

metadata:

name: myapp-deployment

labels:

app: myapp

type: front-end

spec:

template:

metadata:

name: myapp-pod

labels:

app: myapp

type: front-end

spec:

containers:

- name: nginx-container

image: nginx

replicas: 3

selector:

matchLabels:

type: front-end- Creamos el Deployment definido:

kubectl create -f deployment-definition.yaml

deployment "myapp-deployment" created!

# Listamos los Deployments

kubectl get deployments

NAME DESIRED CURRENT READY AGE

myapp-deployment 3 3 3 72s

# Listamos los Replicationset

kubectl get replicaset

NAME DESIRED CURRENT READY AGE

myapp-deployment-325423452345 3 3 3 72s

# Listamos los pods

kubectl get pod

NAME READY STATUS RESTARTS AGE

myapp-deployment-325423452345-gr4hm 1/1 Running 0 33s

myapp-deployment-325423452345-kwm72 1/1 Running 0 33s

myapp-deployment-325423452345-szjkd 1/1 Running 0 33s

# todos los objetos creados

kubectl get all

NAME DESIRED CURRENT READY AGE

deploy/myapp-deployment 3 3 3 72s

NAME DESIRED CURRENT READY AGE

rs/myapp-deployment-325423452345 3 3 3 72s

NAME READY STATUS RESTARTS AGE

po/myapp-deployment-325423452345-gr4hm 1/1 Running 0 33s

po/myapp-deployment-325423452345-kwm72 1/1 Running 0 33s

po/myapp-deployment-325423452345-szjkd 1/1 Running 0 33sAlgunos comando necesarios:

# Crear un pod

kubectl run nginx --image=nginx

# Crear el manifiesto de un pod a partir de kubectl

kubectl run nginx --image=nginx --dry-run=client -o yaml > pod.yaml

# Crear un deployment

kubectl create deploymetn --image=nginx nginx

# Crear manifiesto de un deployment a partir de kubectl

kubectl create deploymetn --image=nginx nginx --dry-run=client -o yaml > deployment.yaml

# Crear manifiesto de un deployment con 4 réplicas a partir de kubectl

kubectl create deployment nginx --image=nginx --replicas=4 --dry-run=client -o yaml > deployment.yaml02.11 - Namespaces

Si varios usuarios y equipos utilizan el mismo clúster de Kubernetes podemos dividir el clúster en subclústeres virtuales utilizando Namespaces. El nombre de los recursos/objetos creados dentro de un Namespace son únicos, pero no en los Namespaces del cluster.

Para listar todos los Namespaces, podemos ejecutar el siguiente comando:

$ kubectl get namespaces

NAME STATUS AGE

default Active 11h

kube-node-lease Active 11h

kube-public Active 11h

kube-system Active 11hGeneralmente, Kubernetes crea cuatro Namespaces por defecto:

- kube-system: Contiene los objetos creados por el sistema, principalmente los agentes del plano de control.

- kube-public: Es un namespace inseguro y legible por cualquiera, utilizado para la exposición de información pública no sensible sobre el cluster.

- default: Contiene los objetos y recursos creados por los administradores y desarrolladores.

Puede asignar Quota de recursos a cada uno de los Namespaces.

Los recursos en el mismo Namespace, puede referise entre si por sus nombres. Ej: una aplicación (app-a) se conectará con otra (app-b) a través de un Service (b-service).

mysql.connect("b-service")Es posible conectar aplicaciones de Namespaces distintos.

mysql.connect("<service-name>.<namespace>.svc.cluster.local")

mysql.connect("b-service.dev.svc.cluster.local")Objeto namespace en YAML:

apiVersion: v1

kind: Namespace

metadata:

name: devAlgunos comandos:

# Listar Pods namespace por defecto

kubectl get pods

# Listar Pods nampespace específico

kubectl get pods --namespace kube-system

# Crear Pod a través de un manifiesto en el namespace por defecto

kubectl create -f pod-definition.yaml

pod/my-app created!

# Crear Pod a través de un manifiesto en un namespace específico

kubectl create -f pod-definition.yaml --namespace dev

pod/my-app created!

# Crear Namespace con kubectl

kubectl create namespace dev

namespace/dev created!

# Cambiar namespace por defecto

kubectl config set-context $(kubectl config current context) --namespace dev

# Listar Pods de todos los namespaces

kubectl get pods --all-namespaces

kubectl get pods -APara limitar los recursos asignados a su namespace, puede definir otro objeto llamado ResourceQuota:

apiVersion: v1

kind: ResourceQuota

metadata:

name: compute-quota

namespace: dev

spec:

hard:

pods: "10" # 10 Pods como máximo en el namespace

requests.cpu: "4" # Request CPU. La suma de las request de todos los Pods del namespace, no puede exceder de 4.

requests.memory: 5Gi # Request Memory. La suma de las request de todos los Pods del namespace, no puede exceder de 5Gi

limits.cpu: "10" # Limits CPU. La suma de las limits de todos los Pods del namespace, no puede exceder de 10

limits.memory: 10Gi # Limits Memory. La suma de las limits de todos los Pods del namespace, no puede exceder de 10GiCreamos el objeto en kubernetes

kubectl create -f compute.quota.yaml02.12 - Services

Los Services son objectos de Kubernetes que permiten la comunicación dentro y fuera del cluster.

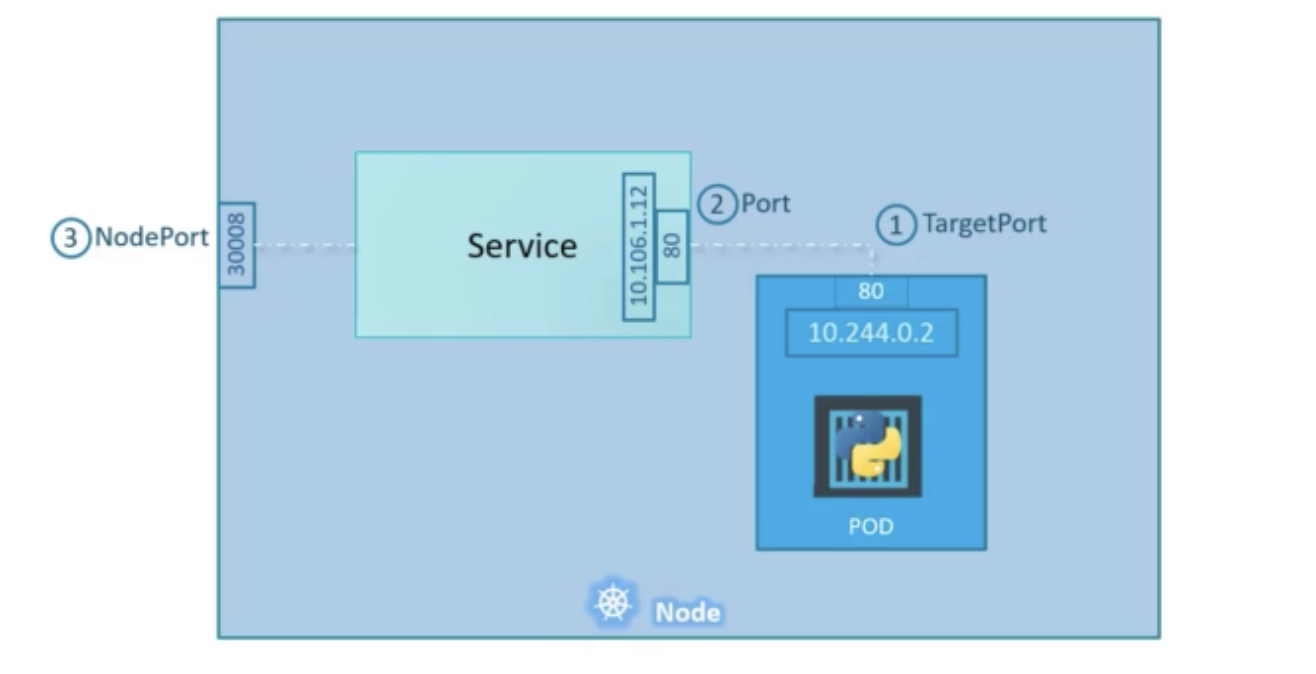

02.12.1 - NodePort

Los Service de tipo NodePort, permiten dedicar un puerto alto (30000-32767) en todos los nodos del cluster. El propio cluster detectará todos los Pods con las etiquetas indicadas y balancerá la carga entre todos ellos.

Se accedería a la aplicación

http://node-ip:30008- Ejemplo de manifiesto YAML:

apiVersion: v1

kind: Service

metadata:

name: myapp-service

spec:

# Tipo de objeto, podría ser ClusterIP, LoadBalancer o NodePort

type: NodePort

selector:

# Se declaran las mismas labels que contiene el Pod, para que el Service, apunte a la aplicación o aplicaciones correctas.

app: myapp

type: front-end

# Puede tener uno o más puertos

ports:

# Si no se indica targePort, por defecto tendrá el mismo que el valor de Port

- port: 80

targetPort: 80

# Si no se indica, el Control Plan de Kubernetes asignará un puerto alto del rango (default: 30000-32767)

nodePort: 30007Comprobamos que el SVC ha sido creado y realizamos una petición curl a todos los nodos con el mismo puerto proporcionado por el SVC:

kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 14s

myapp-service NodePort 10.106.127.123 <none> 80:30007 4s

# Realizamos una petición a las IPs y puertos de los nodos

curl http://192.168.1.2:30007

Hello World!

curl http://192.168.1.3:30007

Hello World!

curl http://192.168.1.4:30007

Hello World!02.12.2 - Services - ClusterIP

Pueden encontrarse distintos componentes, en una aplicación. Por ejemplo: Front-end, back-end y redis. Todos ellos son Pods de nuestro cluster y necesitarán tener conectividad.

Todos los Pods de nuestro cluster, tiene IP, pero, ¿que necesitariamos para conectar los Pods?

Necesitaremos un Service de tipo ClusterIP, permite la comunicación entre distintas capas. Cada capa puedes escalar sin afectar a la comunicación. Estos servicios definene una IP dentro del cluster, a través del nombre proporcionado para el Service, se establece la comunicación.

- Ejemplo de definición de Service ClusterIP:

apiVersion: v1

kind: Service

metadata:

name: back-end

spec:

type: ClusterIP

selector:

app: myapp

type: back-end

ports:

- protocol: TCP

port: 80

targetPort: 80- Creación del SVC:

kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 14s

back-end ClusterIP 10.106.127.123 <none> 80/TCP 4s02.12.3 - Services - LoadBalancer

Como hemos visto, si los usuarios quisieran acceder a una aplicación del cluster, podriamos utilizar un Service de tipo NodePort, les facilitariamos las IPs de los nodos y el puerto asignado, pero, ¿que ocurre si los nodos no son accesibles? ¿y si hay multitud de puertos para los mismos nodos? Podriamos crear una máquina virtual con el propósito de equilibrar la carga entre todos los nodos con nginx, y enrutar hacia los nodos del cluster, pero esto puede ser una tarea tediosa.

Sin embargo, si estuvieramos en una plataforma Cloud, podriamos aprovechar los Load Balancer que nos proporcionan. Kubernetes, tiene soporte para integrase con los balanceadores de carga de estas plataformas, y configurarlo para nosotros.

- Definición de SVC LoadBalancer:

apiVersion: v1

kind: Service

metadata:

name: myapp-service

spec:

selector:

app: myapp

type: front-end

ports:

- nodePort: 80

port: 80

targetPort: 30007

type: LoadBalancer02.13 - Imperativo Vs Declarativo

Los comandos imperativos realizan una tarea concreta, como por ejemplo crear o borrar un objecto en Kubernetes. Los comandos declarativos son más inteligentes, permiten crear un objeto si no existe o actualizarlo si existe.

Los comandos imperativos, de cara al examen, le ayudan a realizar una tarea con mayor rapidez. Algunos comandos:

- Imperativos:

# Crear un objeto a partir de un fichero

kubectl create -f nginx.yaml

# Edita un fichero alojado en memoria

kubectl edit deployment nginx

# Reemplaza un objeto a partir de un fichero

kubectl replace -f nginx.yaml

# Recrear objetos

kubectl replace --force -f nginx.yaml

# No permite crear un objeto que ya existe

kubectl create -f nginx.yaml

`Error from Server (AlreadyExists): error when creating "nginx.yaml": pods "myapp-pod" already exists`

# No permite reemplazar si el objeto no existe

kubectl replace -f nginx.yaml

`Error from Server (Conflict): error when replacing "nginx.yaml": Operation cannot be fulfilled on pods "myapp-pod"`- Declarativos

# Crear un objeto si no existe

kubectl apply -f nginx.yaml

# Crear todos los objetos de un path

kubectl apply -f .

# Actualizar un objeto si existe

kubectl apply -f nginx.yaml- Tips

# Mostar configuración de kubeconfig

kubectl config view

# Mostrar los contextos

kubectl config get-contexts

# Crear o actualizar objetos a partir de un fichero

kubectl apply -f file.yaml

# Crear un Pod

kubectl run nginx --image=nginx

# Crear un Deployment

kubectl create deployment nginx --image=nginx --replicas=4

# Exponer un Deployment

kubectl expose deployment nginx --port 80

# Editar un Deployment

kubectl edit deployment nginx

# Escalar un Deployment

kubectl scale deployment nginx --replicas=5

# Setear imagen en un Deployment

kubectl set image deployment nginx=nginx:1.18

# Crear un Job

kubectl create job hello --image=busybox -- echo "Hello World"

# Crear pod con shell interactiva

kubectl run -ti busybox --image=busybox -- sh

# Crear manifiesto para Pod

kubectl run nginx --image=nginx --dry-run=client -o yaml > pod.yaml

# Crear manifiesto para SVC

kubectl expose pod redis --port=6379 --name redis-service --dry-run=client -o yaml

kubeclt create service clusterip redis --tcp=6379:6379 --dry-run=client -o yaml03 - Scheduling

03.1 - Manual Scheduling

En el manifiesto de Pods, hay una propiedad que normalmente no se especifica ,nodeName, si no se indica, Kubernetes lo agrega automáticamente si existe un Scheduler.

El Scheduler es el encargado de revisar los Pods buscando los que no tienen esta propiedad, estos serán programados, el Scheduler identitifica el nodo correcto, y añade esta propiedad.

nodeName: node02

Cuando no hay un Scheduler en el cluster, el estado de los Pods creados resultará Pending.

kubectl get pods

NAME READY STATUS RESTARTS AGE

nginx 0/1 Pending 0 3SPuedes indicar manualmente esta propiedad en tu manifiesto, de esta forma provisionarás el Pod en el nodo indicado:

- Manifiesto:

apiVersion: v1

kind: Pod

metadata:

name: nginx

spec:

containers:

- name: nginx

image: nginx

nodeName: node02kubectl get pods

NAME READY STATUS RESTARTS AGE IP NODE

nginx 1/1 Pending 0 3S 10.40.0.4 node02Cuando asignas la propiedad manualmente, no permite su modificación.

03.2 - Labels and Selectors

Las Labels son muy útiles para filtrar y ver diferentes objetos por diferentes categorías, como agrupar por su tipo o ver objetos por aplicación o por funcionalidad.

Puede agrupar objetos usando Labels según el tipo de objeto, necesidad, función, etc. En el manifiesto de su objeto, en la sección de Metadata, indique tantas Labels como necesite con un formato key-value.

apiVersion: v1

kind: Pod

metadata:

name: simple-webapp

labels:

app: App1

function: Front-end

spec:

containers:

- name: simple-webapp

image: nginx

ports:

- containerPort: 8080Puede seleccionar objetos usando Selectors, para filtrar objetos específicos.

kubectl get pod --selector app=App1

NAME READY STATUS RESTARTS AGE

simple-webapp 1/1 Running 0 11sLos objetos de Kubernetes utilizan Labels y Selectors internamente para conectar diferentes objetos entre si.

apiVersion: apps/v1

kind: Deployment

metadata:

name: simple-webapp

# Labels definidas para el Deployment

labels:

app: App1

function: Front-end

spec:

replicas: 3

# Sección que une el Deployment con los Pods que controlará. Añadir las mismas Labels que contiene el Pod.

selector:

matchLabels:

app: App1

function: Front-end

template:

metadata:

# Labels definidas para los Pods.

labels:

app: App1

function: Front-end

spec:

containers:

- name: simple-webapp

image: nginx

ports:

- containerPort: 80Funciona igual con otros objetos:

apiVersion: v1

kind: Service

metadata:

name: my-service

spec:

# Sección que une el Service con los Pods.

selector:

app: App1

function: Front-end

ports:

- protocol: TCP

port: 80

targetPort: 9376Mientras que las Labels y Selectors, se usan para agrupar y seleccionar, las Annotations se usan para indicar cualquier dato, como detalles de herramientas, nombres, contactos, números de telefono, correos electrónicos, etc, que pueden usarse para algún tipo de propósito de integración.

apiVersion: apps/v1

kind: Deployment

metadata:

name: simple-webapp

labels:

app: App1

# Annotations, permiten indicar datos, incluso la integración con terceros

## https://github.com/stakater/Reloader

annotations:

secret.reloader.stakater.com/reload: "foo-secret,bar-secret,baz-secret"

spec:

replicas: 3

selector:

matchLabels:

app: App1

template:

metadata:

labels:

app: App1

spec:

containers:

- name: simple-webapp

image: nginx03.3 - Taints and Tolerations

Por defecto, no existen restricciones ni limitaciones en los Nodes, por lo tanto cualquier Pod puede ser ubicado en cualquier Node.

Para evitar que un Node, contenga Pods que no son deseados, se marca con la propiedad Taint, y para que ciertos recursos caigan sobre esos nodos, necesitan una propiedad Tolerations.

# Taints - Node

kubectl taint nodes node-name key=value:taint-effectExisten distintos efectos sobre los Taints:

- NoSchedule: El sistema no provisionará ningún Pod sin Tolerations, en el Nodo.

- PreferNoSchedule: El sistema intentará evitar colocar un Pod en ese nodo, pero no lo garantiza.

- NoExecute: Los nuevos Pods provisionados en el cluster no se añadirán a este nodo, y si ya existen, drenará los Pods si no tienen el Toleration correcto.

# Taint con NoSchedule

kubectl taint nodes node1 app=blue:NoSchedule# Pod con Toleration

apiVersion: v1

kind: Pod

metadata:

name: myapp-pod

spec:

containers:

- name: nginx

image: nginx

imagePullPolicy: IfNotPresent

tolerations:

- key: "app"

operator: "Equal"

value: "blue"

effect: "NoSchedule"Los Nodos Masters, también tienen capacidad para tener Pods, sin embargo no se recomienda programar Pods en el. Estos, tambíen tienen la propiedad Taint.

kubectl describe node master01 | grep Taint

Taints: node-role.kubernetes.io/master:NoSchedule03.4 - Node Selectors

Podemos indicar en los Pods, el Nodo en el que tienen que programarse. NodeSelector, es la propiedad que permite esto, es la unión entre un Pod y un Nodo.

Debe tener un Label en el Nodo

kubectl label nodes node01 size=Large# Pod

apiVersion: v1

kind: Pod

metadata:

name: nginx

labels:

env: test

spec:

containers:

- name: nginx

image: nginx

imagePullPolicy: IfNotPresent

nodeSelector:

size: Large03.5 - Node Affinity

Si quisieramos indicar al Scheduler que un Pod debe ser provisionado en un nodo con LAbel size=Large o size=Medium, necesitariamos utilizar otra propiedad, nodeAffinity.

# Pod con affinity In

apiVersion: v1

kind: Pod

metadata:

name: nginx

labels:

env: test

spec:

containers:

- name: nginx

image: nginx

imagePullPolicy: IfNotPresent

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: size

operator: In # In, NotIn

values:

- Large

- Medium

---

# Pod con Affinity NotIn

apiVersion: v1

kind: Pod

metadata:

name: nginx

labels:

env: test

spec:

containers:

- name: nginx

image: nginx

imagePullPolicy: IfNotPresent

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: size

operator: NotIn

values:

- Small

---

# Solo comprobar que existe una key

apiVersion: v1

kind: Pod

metadata:

name: nginx

labels:

env: test

spec:

containers:

- name: nginx

image: nginx

imagePullPolicy: IfNotPresent

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: size

operator: ExistsExisten tipos de Node Affinity:

- requiredDuringSchedulingIgnoredDuringExecution: No se provisionará cuando se crea, pero será ignorado si ya se encuentra provisinado.

- preferredDuringSchedulingIgnoredDuringExecution: Evitará provisionarse si se crea, y será ignorado si ya se encuentra provisinado.

- requiredDuringSchedulingRequiredDuringExecution: No se provisionará cuando se crea, si ya existe será drenado a otro nodo.

DuringScheduling: estado donde no existe un Pod y se crea por primera vez. DuringExecution: estado donde ya existe un Pod programado.

03.6 - Resource Requirements and Limits

Cada Nodo tiene un conjunto de recursos de CPU, Memoria y Disco. Cada Pod consume un conjunto de recursos.

El Scheduler trata de programar el Pod en el Nodo con menos carga para balancear el uso de los nodos, pero además, también evalua el tamaño de los recursos del Pod, evitando los nodos que no pueden alojar el Pod por recursos insuficientes.

Cuando un Pod no pueda ser alojado por motivos de recursos, podrá ver el siguiente log en el Pod:

Events:

Reason Message

------ -------

FailedScheduling No nodes are available: Insufficient cpu (3).Por defecto, Kubernetes supone que un Pod requiere 0.5CPU y 256Mi. Pero se pueden indicar otros valores:

apiVersion: v1

kind: Pod

metadata:

name: nginx

labels:

env: test

spec:

containers:

- name: nginx

image: nginx

resources:

requests:

memory: "1Gi"

cpu: 1Los recursos de un Pod se pueden establecer:

- CPU: 1m (valor mínimo), 100m, 0.1, 1, etc

- Memory: 1Mi(1,048,576 bytes), 1M(1,000,000 bytes), 1G, 1Gi,

También puede establecer un límite de recursos para el Pod

apiVersion: v1

kind: Pod

metadata:

name: nginx

labels:

env: test

spec:

containers:

- name: nginx

image: nginx

resources:

requests:

memory: "1Gi"

cpu: 1

limits:

memory: "2Gi"

cpu: 2Si no define límites en sus Pods, podrán utilizar si en algún momento lo requieren, toda la CPU o Memoria del nodo, sin embargo, puede limitar el uso a través de los Limits.

Para la CPU, el nodo limitará al Pod, sin embargo para el consumo de memoria, si el Pod excede del límite, el Pod será eliminado.

Puede establecer el límite por defecto para un Pod, creando objetos LimitRange.

# Default Memory

apiVersion: v1

kind: LimitRange

metadata:

name: default-mem-limits

spec:

limits:

- default:

memory: 512Mi

defaultRequest:

memory: 256Mi

type: Container

---

# Default CPU

apiVersion: v1

kind: LimitRange

metadata:

name: default-cpu-limits

spec:

limits:

- default:

cpu: 1

defaultRequest:

cpu: 0.5

type: ContainerAdemás, podemos limitar la asignación de recursos en un Namespace.

# Min Max Memory

apiVersion: v1

kind: LimitRange

metadata:

name: mem-min-max

spec:

limits:

- max:

memory: 500Mi

min:

memory: 128Mi

type: Container

---

# Min Max CPU

apiVersion: v1

kind: LimitRange

metadata:

name: cpu-min-max

spec:

limits:

- max:

cpu: "500m"

min:

cpu: "100m"

type: Container03.7 - DaemonSets

Un DaemonSets es un objeto de Kubernetes, que a su vez, contiene un ReplicaSet. Permite programar una réplica del Pod gestionado en cada Nodo del cluster, además de asegurar de añadir nuevas réplicas en los nuevos nodos que se añadan al cluster.

Kube-proxy o Calico, son ejemplos de DaemonSet, se programan en cada nodo.

# Ejemplo con algunas de las propiedades descritas

apiVersion: apps/v1

kind: DaemonSet

metadata:

name: monitoring-daemon

namespace: kube-system

labels:

k8s-app: monitoring

spec:

selector:

matchLabels:

name: monitoring-agent

template:

metadata:

labels:

name: monitoring-agent

spec:

containers:

- name: fluentd

image: gcr.io/fluentd-elasticsearch/fluentd:v2.5.1

resources:

limits:

memory: 200Mi

requests:

cpu: 100m

memory: 200MiPara garantizar que cada nodo contiene las réplicas del DaemonSet, se le añade la propiedad NodeName.

03.8 - Static Pods

Si no hubiese Control Planne, un nodo podría funcionar por si mismo a través de Kubelet. Sabemos que la única misión de kubelet, es crear Pods, pero en este caso no tenemos API Server para comunicarle la creación de Pods. Podemos configurar kubelet para leer los ficheros de una ruta en el nodo /etc/kubernetes/manifest/, kubelet revisará periódicamente este diretorio y creará los Pods (solo puede crear Pods) que alli se encuentren definidos, también se ocupará de que se mantenga vivos.

[Service]

ExecStart=/usr/local/bin/kubelet \\

--container-runtime=remote \\

--container-runtime-endpoint=unix://var/run/containerd/containerd.sock \\

# Con esta propiedad se define donde se encuentran los Statics Pods

--pod-manifest-path=/etc/kubernetes/manifest \\

--kubeconfig=/var/lib/kubelet/kubeconfig \\

--network-plugin=cni \\

--register-node=true \\

--v=2También puede indicarse en el fichero kubeconfig

cat /var/lib/kubelet/kubeconfig

...

staticPodPath: /etc/kubernetes/manifest

...

Una vez creados, podriamos visualizar nuestros Statics Pods a través de Docker, recordemos que no tenemos un API Server.

Si tuvieramos un API Server, podriamos ver los Statics Pods creados pero no podriamos editarlos a través de kubectl.

03.9 - Multiple Scheduler

Un caso de uso para tener múltiples Schedulers, es que el algoritmo y comprobraciones que hace el actual Scheduler no satisfacen sus necesidades.

# kube-scheduler.service

ExecStart=/usr/local/bin/kube-scheduler \\

--config=/etc/kubernetes/config/kube-scheduler.yaml \\

--scheduler-name= default-scheduler

# my-custom-scheduler.service

ExecStart=/usr/local/bin/kube-scheduler \\

--config=/etc/kubernetes/config/kube-scheduler.yaml \\

--scheduler-name= default-schedulerPodemos copiar el Pod del actual Scheduler y añadirle algunos parámetros más:

# /etc/kubernetes/manifest/kube-scheduler.yaml

apiVersion: v1

kind: Pod

metadata:

name: kube-scheduler

namespace: kube-system

spec:

containers:

- command:

- kube-scheduler

- --address=127.0.0.1

- --kubeconfig=/etc/kubernetes/scheduler.conf

- --leader-elect=true

image: k8s.gcr.io/kube-scheduler-amd64:v1.11.3

name: kube-scheduler

---

# my-custom-scheduler.yaml

apiVersion: v1

kind: Pod

metadata:

name: my-custom-scheduler

namespace: kube-system

spec:

containers:

- command:

- kube-scheduler

- --address=127.0.0.1

- --kubeconfig=/etc/kubernetes/scheduler.conf

- --leader-elect=true

- --scheduler-name=my-custom-scheduler

- --lock-object-name=my-custom-scheduler

image: k8s.gcr.io/kube-scheduler-amd64:v1.11.3

name: kube-schedulerNAME READY STATUS RESTARTS AGE

coredns-78fcdf6894-bk4ml 1/1 Running 0 1h

coredns-78fcdf6894-ppr6m 1/1 Running 0 1h

etcd-master 1/1 Running 0 1h

kube-apiserver-master 1/1 Running 0 1h

kube-controller-manager-master 1/1 Running 0 1h

kube-proxy-dgbgv 1/1 Running 0 1h

kube-proxy-fptbr 1/1 Running 0 1h

kube-scheduler-master 1/1 Running 0 1h

my-custom-scheduler 1/1 Running 0 9s

weave-net-4tfpt 2/2 Running 1 1h

weave-net-6j6zs 2/2 Running 1 1hPara usar el nuevo Scheduler, basta con indicarselo al Pod:

apiVersion: v1

kind: Pod

metadata:

name: annotation-default-scheduler

labels:

name: multischeduler-example

spec:

# Define la propiedad schedulerName

schedulerName: my-custom-scheduler

containers:

- name: pod-with-default-annotation-container

image: k8s.gcr.io/pause:2.0Mostramos los eventos del namespace donde corre el pod

kubectl get events -n default

LAST SEEN COUNT NAME KIND TYPE REASON SOURCE MESSAGE

9s 1 nginx.15 Pod Normal Scheduled my-custom-scheduler Successfully assigned default/nginx to node01

8s 1 nginx.15 Pod Normal Pulling kubelet, node01 pulling image "nginx"

2s 1 nginx.15 Pod Normal Pulled kubelet, node01 Successfully pulled image "nginx"04 - Logging and Monitoring

04.1 - Monitorizar componentes del Cluster

Kubernetes no facilita por defecto un sistema de monitorización, existen multitud de ellos

- Metrics Server

- Prometheus

- Elastic Stack

- DataDog

- DynaTrace

Heapster fue uno de los proyectos originales que habilitó las funciones de monitorización, cuando realice búsquedas, verá muchas referencias a este componente. Sin embargo, se encuentra deprecada. Se formó una versión reducida como Metrics Server.

Metrics-server recupera las métricas de cada uno de los Nodos y Pods en memoria, no puede ver el histórico.

Kubelete tiene un subcomponente conocido como cAdvisor o Container Advisor, es el responsable de recuperar las métricas de rendimiento, y exponerlas a través de la API de kubelet.

Puede instalar este servicio instalando los objetos que lo componen:

kubectl apply -f https://github.com/kubernetes-sigs/metrics-server/releases/latest/download/components.yamlUna vez creado metrics-server, podemos obtener métricas de los nodos y de los Pods:

# Nodes

kubectl top node

NAME CPU(cores) CPU% MEMORY(bytes) MEMORY%

kubemaster 166m 8% 1337Mi 70%

kubenode1 36m 1% 1046Mi 55%

kubenode2 39m 1% 1048Mi 55%

# Pods

kubectl top pod

NAME CPU(cores) CPU% MEMORY(bytes) MEMORY%

nginx 166m 8% 1337Mi 70%

redis 36m 1% 1046Mi 55%04.2 - Manejar logs de aplicación

Al igual que Docker, Kubernetes nos permite visualizar los logs de nuestras aplicaciones.

# -f logs en tiempo real

# -c seleccionar un contenedor si nuestro Pod contiene más de uno.

kubectl logs –f event-simulator-pod -c event-simulator

2018-10-06 15:57:15,937 - root - INFO - USER1 logged in

2018-10-06 15:57:16,943 - root - INFO - USER2 logged out

2018-10-06 15:57:17,944 - root - INFO - USER2 is viewing page2

2018-10-06 15:57:18,951 - root - INFO - USER3 is viewing page3

2018-10-06 15:57:19,954 - root - INFO - USER4 is viewing page1

2018-10-06 15:57:20,955 - root - INFO - USER2 logged out

2018-10-06 15:57:21,956 - root - INFO - USER1 logged in

2018-10-06 15:57:22,957 - root - INFO - USER3 is viewing page2

2018-10-06 15:57:23,959 - root - INFO - USER1 logged out

2018-10-06 15:57:24,959 - root - INFO - USER2 is viewing page2

2018-10-06 15:57:25,961 - root - INFO - USER1 logged in

2018-10-06 15:57:26,965 - root - INFO - USER4 is viewing page3

2018-10-06 15:57:27,965 - root - INFO - USER4 is viewing page3

2018-10-06 15:57:28,967 - root - INFO - USER2 is viewing page1

2018-10-06 15:57:29,967 - root - INFO - USER3 logged out

2018-10-06 15:57:30,972 - root - INFO - USER1 is viewing page2

2018-10-06 15:57:31,972 - root - INFO - USER4 logged out

2018-10-06 15:57:32,973 - root - INFO - USER1 logged in

2018-10-06 15:57:33,974 - root - INFO - USER1 is viewing page305 - Application Lifecycle Management

05.1 - Rolling Updates and Rollbacks

Cuando se crea un Deployment, se crea una versión (PE: v1) (replicaSet), en el futuro cuando el Deployment es actualizado, las versiones también son actualizadas. Esto nos ayuda a realizar el seguimiento de nuestro Deploymente, y retroceder a una versión anterior si fuera necesario.

# Conocer el estado de un Deployment

kubectl rollout status deployment/myapp-deployment

Waiting for rollout to finish: 0 of 10 updated replicas are available...

Waiting for rollout to finish: 1 of 10 updated replicas are available...

Waiting for rollout to finish: 2 of 10 updated replicas are available...

Waiting for rollout to finish: 3 of 10 updated replicas are available...

Waiting for rollout to finish: 4 of 10 updated replicas are available...

Waiting for rollout to finish: 5 of 10 updated replicas are available...

Waiting for rollout to finish: 6 of 10 updated replicas are available...

Waiting for rollout to finish: 7 of 10 updated replicas are available...

Waiting for rollout to finish: 8 of 10 updated replicas are available...

Waiting for rollout to finish: 9 of 10 updated replicas are available...

deployment "myapp-deployment" successfully rolled out

# Conocer el historial de estado de un Dployment

kubectl rollout history deployment/myapp-deployment

deployments "myapp-deployment"

REVISION CHANGE-CAUSE

1 <none>

2 kubectl apply --filename=deployment-definition.yml --record=trueExisten dos tipos de estrategias de despliegues:

- Recreate: destruir primero los Pods, e implementar la nueva versión. Utilizar este método causa que la aplicación no esté disponible.

- Rolling Update: destruir y crear la nueva versión Pod a Pod, sin causar que la aplicación no esté disponible.

# Recreate

...

spec:

replicas: 3

strategy:

type: Recreate

...

# RollingUpdate

...

spec:

replicas: 3

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 2 # Cuantos Pods se añaden al mismo tiempo

maxUnavailable: 0 # Cuantos Pods puede no estar disponibles durante la actualización

...Cuando una actualización no funciona como esperabamos, podemos utilizar la estrategia de Rollback,

kubectl rollout undo deployment/myapp-deployment

deployment "deployment/myapp-deployment" rolled back

# Alternativamente puedes indicarle la revisión a la que quieres volver

kubectl rollout undo deployment/myapp-deployment --to-revision=2

deployment "deployment/myapp-deployment" rolled back05.2 - Commands and Arguments

Una imagen pueden contener parámetros que indiquen como se comportará el contendor cuando se lanza:

# Dockerfile ubuntu-sleeper

FROM Ubuntu # imagen

ENTRYPOINT ["sleep"] # Comando que se lanza

CMD ["5"] # argumento para el comando por defecto

# Ejecución

docker run ubuntu-sleeper 10La misma imagen, usada en un Pod:

apiVersion: v1

kind: Pod

metadata:

name: ubuntu-sleeper-pod

spec:

containers:

- name: ubuntu-sleeper

image: ubuntu-sleeper # imagen

command: ["sleep2.0"] # Reemplazamos el ENTRYPOINT de la imagen

args: ["10"] # Indicamos un argumento05.3 - Configurar ENVs en aplicaciones

Podemos proporcionar variables a un Pod de distintas formas.

- Texto plano:

apiVersion: v1

kind: Pod

metadata:

name: simple-webapp

spec:

containers:

- name: simple-webapp

image: simple-webapp

ports:

- containerPort: 8080

env:

- name: APP_COLOR

value: green- Carga de variables a través de Configmap

apiVersion: v1

kind: Pod

metadata:

name: simple-webapp

spec:

containers:

- name: simple-webapp

image: simple-webapp

ports:

- containerPort: 8080

env:

- name: APP_COLOR

valueFrom:

configMapKeyRef:

name: configmap-color

key: color- Carga de variables a través de Secrets

apiVersion: v1

kind: Pod

metadata:

name: simple-webapp

spec:

containers:

- name: simple-webapp

image: simple-webapp

ports:

- containerPort: 8080

env:

- name: APP_COLOR

valueFrom:

secretKeyRef:

name: secret-color

key: color05.4 - Configurar ConfigMaps en aplicaciones

Si tenemos muchos datos que pasar a un Pod, podemos configurar objetos configMaps para almacenarlos.

- Crear configMap:

# Sintaxis Imperativa

kubectl create configmap <config-name> --from-literal=<key>=<value>

# Ejemplos

## Configmap con una clave

kubectl create configmap \

app-config --from-literal=APP_COLOR=blue

## Configmap con varias claves

kubectl create configmap \

app-config --from-literal=APP_COLOR=blue \

--from-literal=ENVIRONMENT=pro \

--from-literal=email=test@test.test

## Configmap a partir de un fichero

kubectl create configmap \

app-config --from-file=app_config.properties- Componer manifiesto configMap:

# app-config

apiVersion: v1

kind: ConfigMap

metadata:

name: app-config

data:

APP_COLOR: blue

APP_MODE: prodPara referenciarlos basta con detallarlo en el Pod:

apiVersion: v1

kind: Pod

metadata:

name: simple-webapp

spec:

containers:

- name: simple-webapp

image: simple-webapp

ports:

- containerPort: 8080

env:

- name: APP_COLOR

valueFrom:

configMapKeyRef:

name: app-configExisten distintas formas de pasar un ConfigMap a un Pod:

# Carga como variable de entorno

envForm:

- configMapRef:

name: app-config

# Carga como variable simple

env:

- name: APP_COLOR

valueFrom:

configMapRefKey:

name: app-config

key: APP_COLOR

# Carga de variables como un volumen

volumes:

- name: app-config-volume

configMap:

name: app-config05.5 - Configurar Secrets en aplicaciones

Los Secrets de Kubernetes, son objetos que codifican su contenido en base64, son útiles para almacenar datos sensibles, que posteriormente se utilizarán en los servicios que implementen.

# Sintaxis creación de secretos

kubectl create secret generic \

<secret-name> --from-literal=<key>=<value>

# Ejemplos

## Crear secreto con una clave

kubectl create secret generic \

app-secret --from-literal=DB_PASS=pass

## Crear secreto con múltiples claves

kubectl create secret generic \

app-secret --from-literal=DB_PASS=pass \

app-secret --from-literal=DB_HOST=host

## Crear secreto a partir de un fichero

kubectl create secret generic \

app-secret --from-file=db.propertiesCuando se crea el secreto a través de comando imperativo, el contenido se codifica en Base64.

kubectl describe secret app-secret

...

DB_PASS: ZXMgdW4gc2VjcmV0bwo=

...Crear un manifiesto de un secreto se vería así, debemos indicar el contenido codificado:

apiVersion: v1

kind: Secret

metadata:

name: app-secret

data:

DB_PASS: ZXMgdW4gc2VjcmV0bwo= # base64Para pasar un secreto a un Pod, lo hacemos:

apiVersion: v1

kind: Pod

metadata:

name: simple-webapp

spec:

containers:

- name: simple-webapp

image: simple-webapp

ports:

- containerPort: 8080

envFrom:

- secretRef:

name: app-secret# Secreto como variables

envFrom:

- secretRef:

name: app-secret

# Secreto como única variable

env:

- name: DB_PASSWORD

valueFrom:

secretKeyRef:

name: app-secret

key: DB_Pass

# Secreto como volumen (se crearán en el punto de montaje tantos ficheros como keys contenta el screto)

volumes:

- name: app-secret-volume

secret:

secretName: app-secretPara codificar y decodificar un texto:

echo "pass" | base64 #Codificar

echo "ZXMgdW4gc2VjcmV0bwo=" | base 64 -d05.6 - Escalar aplicaciones

En ocasiones puede necesitar más de un contenedor en un Pod, por ejemplo, puede necesitar un contenedor para recoger los logs.

apiVersion: v1

kind: Pod

metadata:

name: multiple-container

spec:

containers:

- name: simple-webapp

image: simple-webapp

ports:

- containerPort: 8080

- name: agent-log

image: agent-lob05.7 - Init Containers

En un Pod con múltiples contenedores, se espera que cada uno ejecute un proceso que permanezca vivo mientras dure el ciclo de vida del POD.

Los initContainer, es un contendor que se inicia cuando el Pod es provisionado, permite ejecutar tareas antes de que la aplicación principal esté disponible, un caso de uso puede ser un proceso que espera a que un servicio externo o una base de datos esté disponible antes de que se inicie la aplicación real. Es posible declarar múltiples initContainers y su ejecución es secuencial.

apiVersion: v1

kind: Pod

metadata:

name: myapp-pod

labels:

app: myapp

spec:

containers:

- name: myapp-container

image: busybox:1.28

command: ['sh', '-c', 'echo The app is running! && sleep 3600']

initContainers:

- name: init-myservice

image: busybox

command: ['sh', '-c', 'git clone <some-repository-that-will-be-used-by-application> ; done;']06 - Cluster Maintenance

06.1 - OS upgrades

Existe múltiples tareas de mantenimiento sobre los nodos de un cluster, pero estos nodos es posible que estén dando servicio. Kubectl, permite indicar a kubernetes el drenado de Pods de un nodo.

kubectl drain node01Cuando drenamos un nodo, lo que estamos haciendo es acordonarlo (ningún Pod será programado en el nodo), y terminar los Pods que están programados en el. Kubernetes los recreará en otro nodo.

Una vez terminemos las tareas de mantenimiento sobre el nodo, podrá volver a estar disponible para el programar Pods.

# Permite programar Pods en el nodo

kubectl uncordon node01

# Evita que se programen Pods en el nodo

kubectl cordon node0106.2 - Cluster Upgrade process

Existe diferentes estrategias para la actualización de las versiones que corren en los nodos. Los primeros nodos a actualizar, sería los Master. Partiendo de que tenemos los Master, actualizados:

- Todos a la vez, supone que ninguna de sus aplicaciones estarán disponibles durante el proceso de actualización.

- Uno a uno, moviendo los Pods entre nodos para evitar que no estén disponibles las aplicaciones.

- Agregar nuevos nodos actualizados, moviendo los Pods a estos, y eliminando los desactualizados.

Con Kubeadm podemos actualizar los nodos con el siguente comando:

# Mostramos el plan de actualización

$ kubeadm upgrade plan

[preflight] Running pre-flight checks.

[upgrade] Making sure the cluster is healthy:

[upgrade/config] Making sure the configuration is correct:

[upgrade] Fetching available versions to upgrade to

[upgrade/versions] Cluster version: v1.11.8

[upgrade/versions] kubeadm version: v1.11.3

[upgrade/versions] Latest stable version: v1.13.4

[upgrade/versions] Latest version in the v1.11 series: v1.11.8

Components that must be upgraded manually after you have

upgraded the control plane with 'kubeadm upgrade apply':

COMPONENT CURRENT AVAILABLE

Kubelet 3 x v1.11.3 v1.13.4

Upgrade to the latest stable version:

COMPONENT CURRENT AVAILABLE

API Server v1.11.8 v1.13.4

Controller Manager v1.11.8 v1.13.4

Scheduler v1.11.8 v1.13.4

Kube Proxy v1.11.8 v1.13.4

CoreDNS 1.1.3 1.1.3

Etcd 3.2.18 N/A

You can now apply the upgrade by executing the following command:

kubeadm upgrade apply v1.13.4

apt-get upgrade -y kubeadm=1.12.0-00

kubeadm upgrade apply v1.12.0

[upgrade/successful] SUCCESS! Your cluster was upgraded to "v1.12.0". Enjoy!

[upgrade/kubelet] Now that your control plane is upgraded, please proceed with

upgrading your kubelets if you havent already done so.

# Mostramos la versión de nuestros nodos

kubectl get nodes

NAME STATUS ROLES AGE VERSION

master Ready master 1d v1.11.3

node-1 Ready <none> 1d v1.11.3

node-2 Ready <none> 1d v1.11.3

$ apt-get upgrade -y kubelet=1.12.0-00

$ systemctl restart kubelet

$ kubectl get nodes

NAME STATUS ROLES AGE VERSION

master Ready master 1d v1.12.0

node-1 Ready <none> 1d v1.11.3

node-2 Ready <none> 1d v1.11.306.3 - Backup and restore methods

- Configuraciones Lo más seguro es almacenar todos nuestos manifiestos de Kubernetes en un sistema de control de versiones, de esta forma será mantenido más facilmente por un equipo.

Si alguien ha creado algún recurso de forma imperativa, puede obtener un backup consultando al API Server.

kubectl get all --all-namespaces -o yaml > all-deploy-services.yaml

Algunos sitemas se encarga de realizar estas tareas Velero

- ETCD

ETCD cuenta con un comando para realizar snapshots de sus datos

ETCD_API=3 etcdctl snapshot save snapshot.db

Restaurar una copia de ETCD

# Para el servicio kube-apiserver

$ service kube-apiserver stop

Service kube-apiserver stopped

# Restauramos la copia en una ruta

ETCDCTL_API=3 etcdctl \

snapshot restore snapshot.db \

--data-dir /var/lib/etcd-from-backup \

# Configuramos el servicio para que obtenga los datos de la nueva ruta

etcd.service

ExecStart=/usr/local/bin/etcd \\

--name ${ETCD_NAME} \\

--cert-file=/etc/etcd/kubernetes.pem \\

--key-file=/etc/etcd/kubernetes-key.pem \\

--peer-cert-file=/etc/etcd/kubernetes.pem \\

--peer-key-file=/etc/etcd/kubernetes-key.pem \\

--trusted-ca-file=/etc/etcd/ca.pem \\

--peer-trusted-ca-file=/etc/etcd/ca.pem \\

--peer-client-cert-auth \\

--client-cert-auth \\

--initial-advertise-peer-urls https://${INTERNAL_IP}:2380

--listen-peer-urls https://${INTERNAL_IP}:2380 \\

--listen-client-urls https://${INTERNAL_IP}:2379,https://127.0.0.1:2379

--advertise-client-urls https://${INTERNAL_IP}:2379 \\

--initial-cluster-token etcd-cluster-0 \\

--initial-cluster controller-0=https://${CONTROLLER0_IP}:2380,controller

--initial-cluster-state new \\

--data-dir=/var/lib/etcd-from-backup

# Reiniciamos el demonio

$ systemctl daemon-reload

$ systemctl etcd restart

# Finalmente, inicie el servicio kube-apiserver

$ service kube-apiserver start

Service kube-apiserver started

# Recuerde indicar todos los parámetros necesario para interactuar con ETCD

ETCDCTL_API=3 etcdctl \

snapshot restore snapshot.db \

--data-dir /var/lib/etcd-from-backup \

--initial-cluster master-1=https://192.168.5.11:2380,master-2=https://192.168.5.12:2380 \

--initial-cluster-token etcd-cluster-1 \

--initial-advertise-peer-urls https://${INTERNAL_IP}:238006.4 - Working with ETCD

etcdctl es un cliente de línea de comandos para etcd.

Cuando realice acciones sobre ETCD v3, asegurse de indicar la versión: export ETCDCTL_API=3.

Puede pasar el flag -h para conocer todas las opciones de un comando.

07 - Security

07.1 - Kubernetes Security Primivite

Algunos puntos a tener en cuenta con respecto a la seguridad en kubernetes, son los siguientes:

07.1.1 - Securización de Hosts

Debe deshabilitar el acceso al usuario root, deshabilitar la password de usuarios y permitir solo la autenticación solo por clave ssh.

07.1.2 - Securización de Kubernetes

Para comenzar, necesitamos tomar dos tipos de decisiones: quien puede acceder al cluster y que puede hacer.

-

Autenticación: los mecanismos de autenticación definen quien puede acceder al API Server. Existen diferentes formas de autenticarse contra el API Server.

- Usuario y password

- Usuario y token

- Certificados

- Provedores externos - LDAP

- Service Accounts

-

Autorización: los mecanismos de autorización definen que puede hacer una vez se han autenticado en el sistema:

- RBAC Authorization

- ABAC Authorization

- Node Authorization

- Webhook Mode

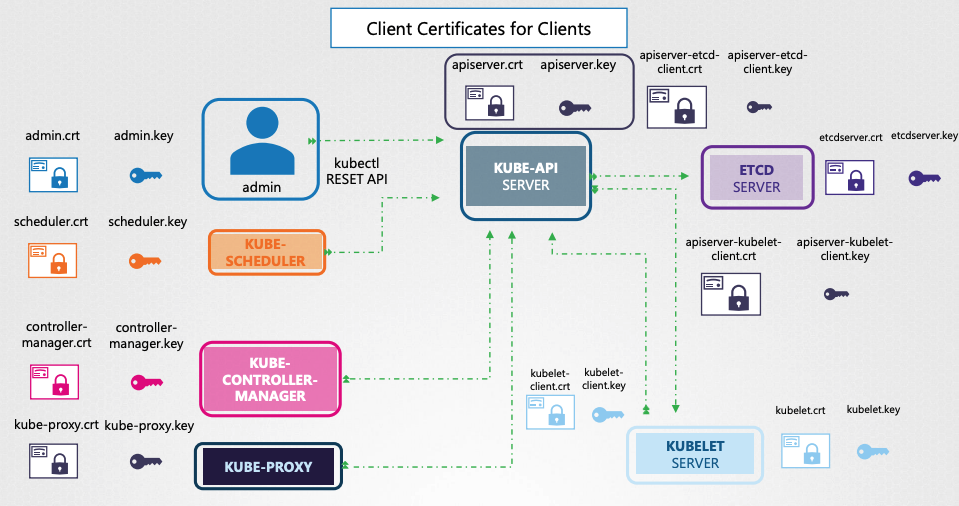

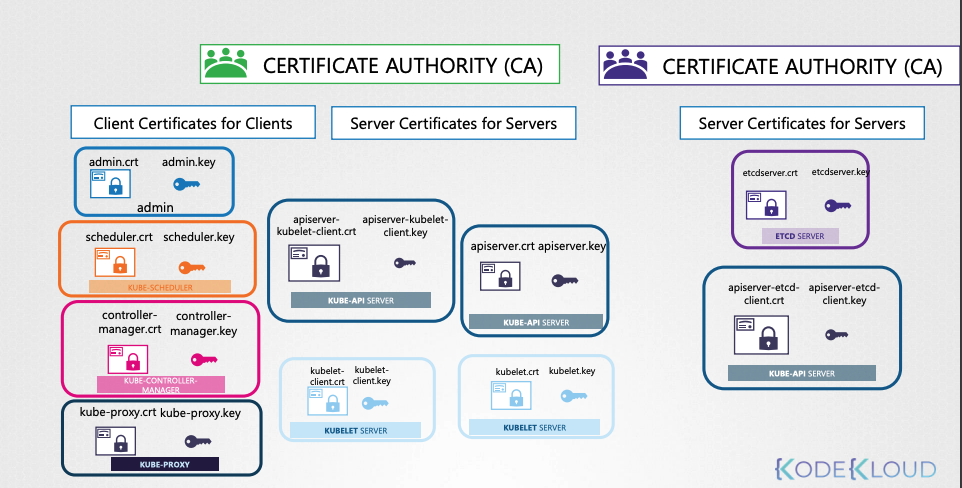

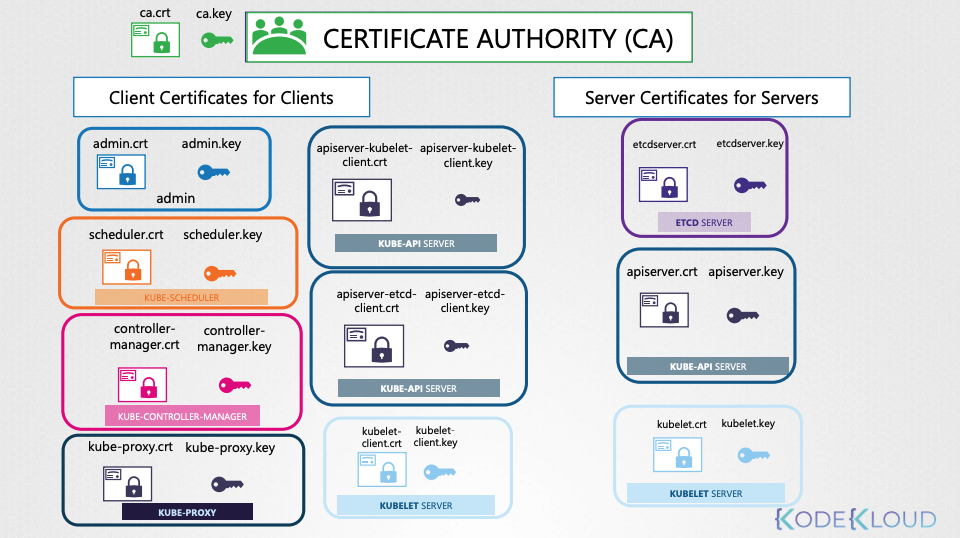

Todas las comunicaciones entre los distintos componentes del clusters, se garantiza mediante el cifrado TLS.

Las Pods del cluster, tienen conectividad entre si. Pero es posible restringir el acceso entre ellos utilizando Network Policies.

07.2 - Authentication

Kubernetes no administra usuario de forma nativa, se basa en fuentes externas como un archivo con detalles de usuarios, certificados o cuentas de identidad de terceros.

Por lo tanto, no puede crear usuarios.

7.2.3 - Auth Basic

Puede crear una lista de usuarios y sus contraseñas en formato CSV.

# User details

## password,user,ID_user,group(optional)

password123,user1,u0001

password123,user2,u0002

password123,user3,u0003

password123,user4,u0004Dentro el servicio kube-apiserver, puede indicar lo siguiente:

# kube-apiserver.service

ExecStart=/usr/local/bin/kube-apiserver \\

--advertise-address=${INTERNAL_IP} \\

--allow-privileged=true \\

--apiserver-count=3 \\

--authorization-mode=Node,RBAC \\

--bind-address=0.0.0.0 \\

--enable-swagger-ui=true \\

--etcd-servers=https://127.0.0.1:2379 \\

--event-ttl=1h \\

--runtime-config=api/all \\

--service-cluster-ip-range=10.32.0.0/24 \\

--service-node-port-range=30000-32767 \\

--v=2 \\