pytorch 实现Grad-CAM:Visual Explanations from Deep Networks via Gradient-based Localization 和

Grad-CAM++: Improved Visual Explanations for Deep Convolutional Networks

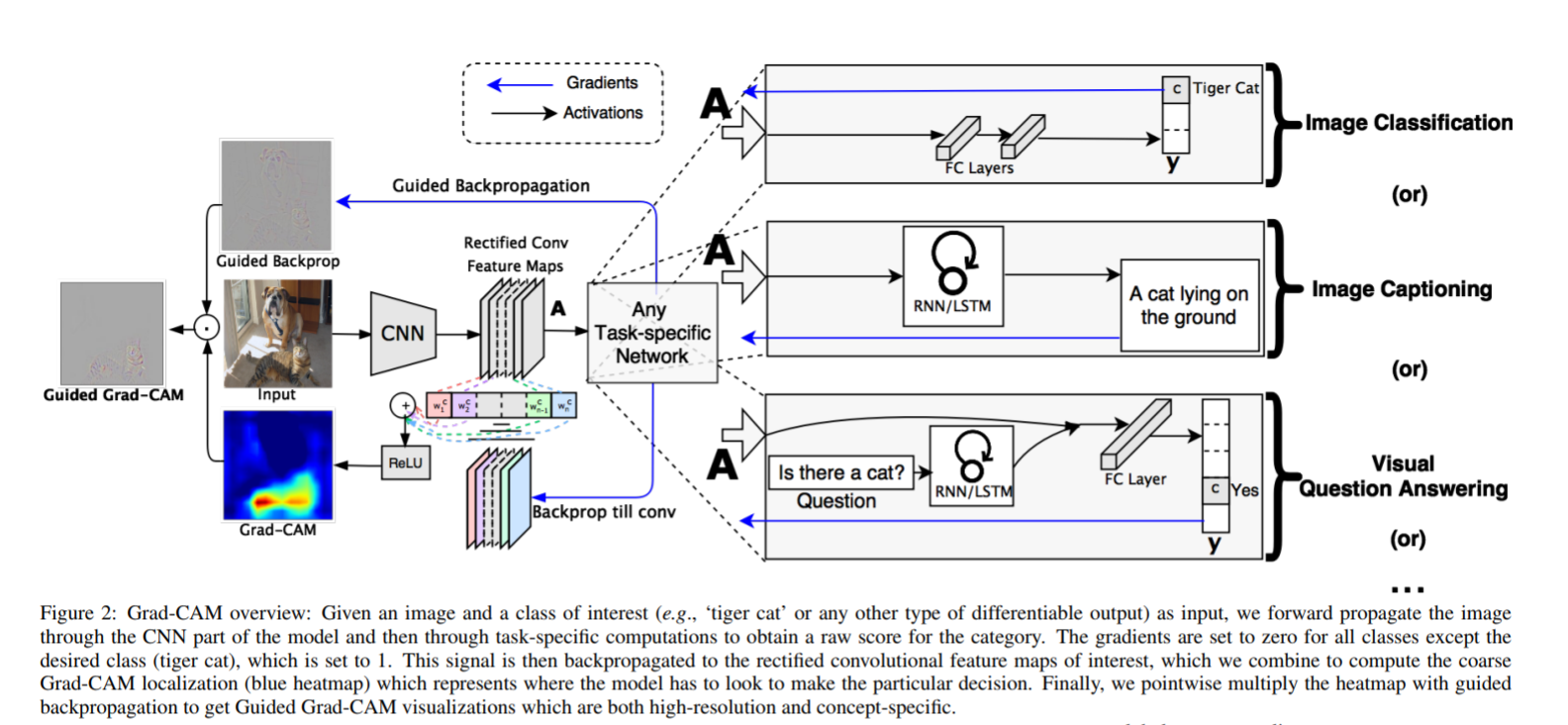

Grad-CAM整体架构

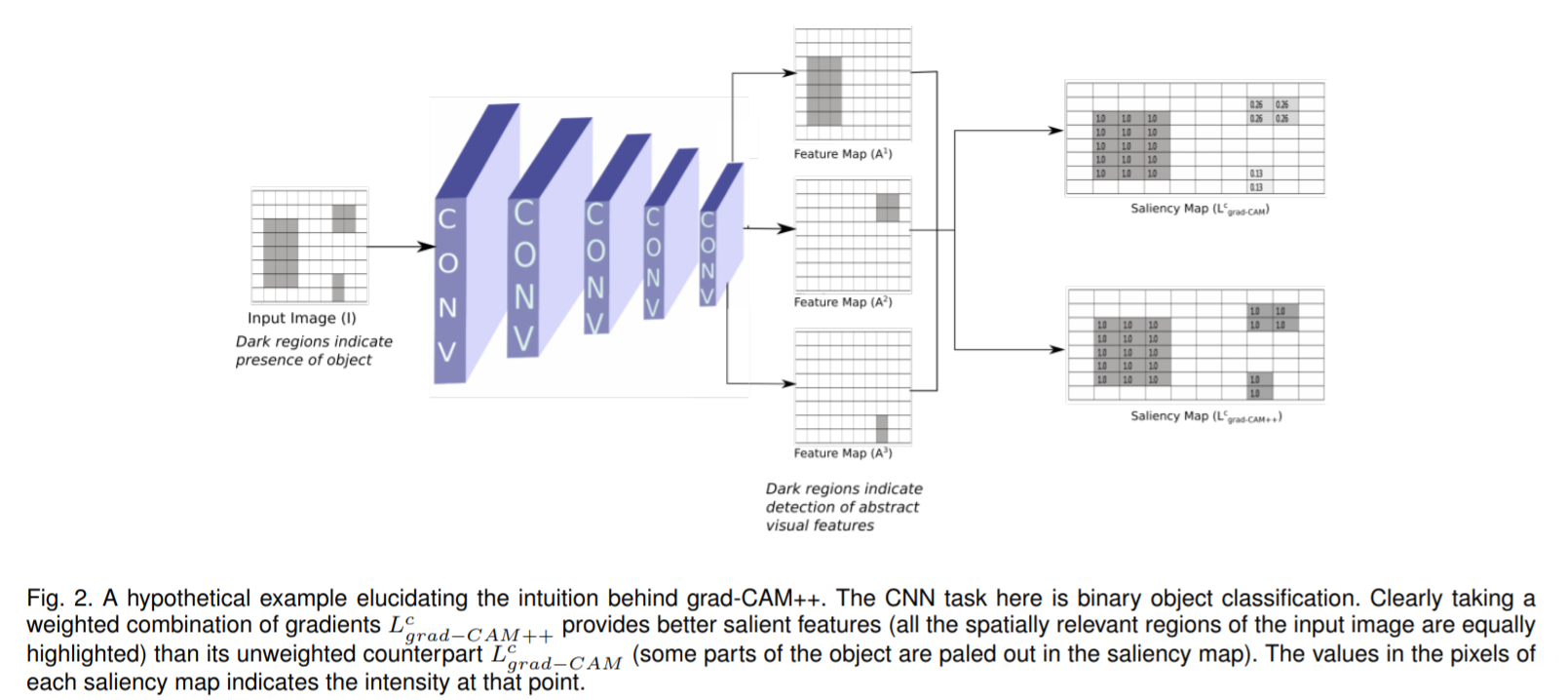

Grad-CAM++与Grad-CAM的异同

python 3.6.x

pytoch 1.0.1+

torchvision 0.2.2

opencv-python

matplotlib

scikit-image

numpypython main.py --image-path examples/pic1.jpg \

--network densenet121 \

--weight-path /opt/pretrained_model/densenet121-a639ec97.pth参数说明:

-

image-path:需要可视化的图像路径(可选,默认

./examples/pic1.jpg) -

network: 网络名称(可选,默认

resnet50) -

weight-path: 网络对应的与训练参数权重路径(可选,默认从pytorch官网下载对应的预训练权重)

-

layer-name: Grad-CAM使用的层名(可选,默认最后一个卷积层)

-

class-id:Grad-CAM和Guided Back Propagation反向传播使用的类别id(可选,默认网络预测的类别)

-

output-dir:可视化结果图像保存目录(可选,默认

results目录)

原始图像

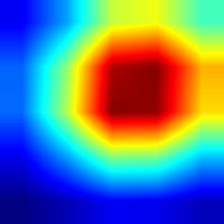

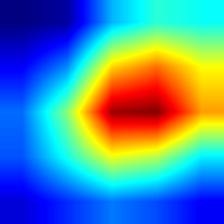

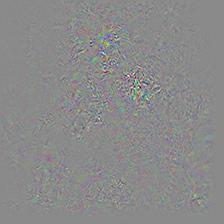

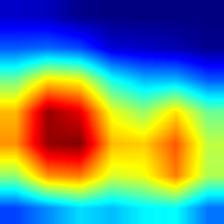

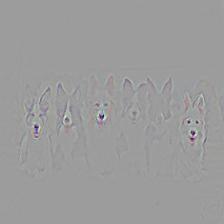

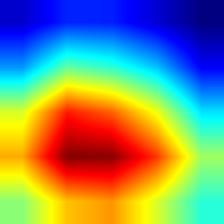

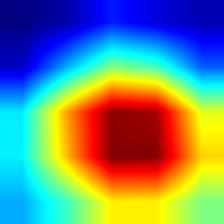

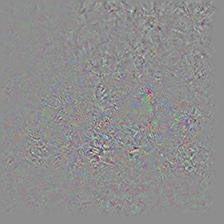

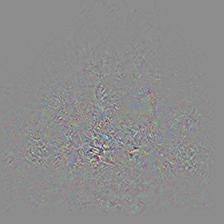

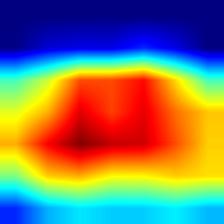

效果

| network | HeatMap | Grad-CAM | HeatMap++ | Grad-CAM++ | Guided backpropagation | Guided Grad-CAM |

|---|---|---|---|---|---|---|

| vgg16 |  |

|

|

|

|

|

| vgg19 |  |

|

|

|

|

|

| resnet50 |  |

|

|

|

|

|

| resnet101 |  |

|

|

|

|

|

| densenet121 |  |

|

|

|

|

|

| inception_v3 |  |

|

|

|

|

|

| mobilenet_v2 |  |

|

|

|

|

|

| shufflenet_v2 |  |

|

|

|

|

|

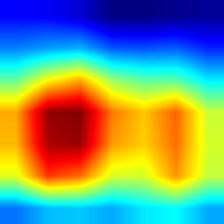

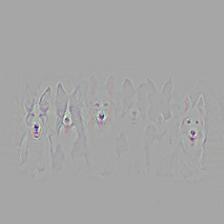

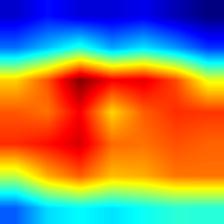

对应多个图像Grad-CAM++比Grad-CAM覆盖要更全面一些,这也是Grad-CAM++最主要的优势

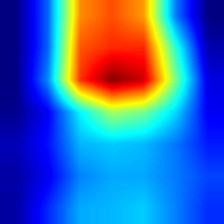

原始图像

效果

| network | HeatMap | Grad-CAM | HeatMap++ | Grad-CAM++ | Guided backpropagation | Guided Grad-CAM |

|---|---|---|---|---|---|---|

| vgg16 |  |

|

|

|

|

|

| vgg19 |  |

|

|

|

|

|

| resnet50 |  |

|

|

|

|

|

| resnet101 |  |

|

|

|

|

|

| densenet121 |  |

|

|

|

|

|

| inception_v3 |  |

|

|

|

|

|

| mobilenet_v2 |  |

|

|

|

|

|

| shufflenet_v2 |  |

|

|

|

|

|

- vgg模型的Grad-CAM并没有覆盖整个对象,相对来说resnet和denset覆盖更全,特别是densenet;从侧面说明就模型的泛化和鲁棒性而言densenet>resnet>vgg

- Grad-CAM++相对于Grad-CAM也是覆盖对象更全面,特别是对于同一个类别有多个实例的情况下,Grad-CAM可能只覆盖部分对象,Grad-CAM++基本覆盖所有对象;但是这仅仅对于vgg而言,想densenet直接使用Grad-CAM也基本能够覆盖所有对象

- MobileNet V2的Grad-CAM覆盖也很全面

- Inception V3和MobileNet V2的Guided backpropagation图轮廓很模糊,但是ShuffleNet V2的轮廓则比较清晰

有位网友@SHAOSIHAN问道怎样在目标检测中使用Grad-CAM;在Grad-CAM和Grad-CAM++论文中都没有提及对目标检测生成CAM图。我想主要有两个原因:

a) 目标检测不同于分类,分类网络只有一个分类损失,而且所有网络都是一样的(几个类别最后一层就是几个神经元),最后的预测输出都是单一的类别得分分布。目标检测则不同,输出都不是单一的,而且不同的网络如Faster R-CNN, CornerNet,CenterNet,FCOS,它们的建模方式不一样,输出的含义都不相同。所以不会有统一的生成Grad-CAM图的方法。

b) 分类属于弱监督,通过CAM可以了解网络预测时主要关注的空间位置,也就是"看哪里",对分析问题有实际的价值;而目标检测,本身是强监督,预测边框就直接指示了“看哪里”。

这里以detetron2中的faster-rcnn网络为例,生成Grad-CAM图。主要思路是直接获取预测分值最高的边框;将该边框的预测分值反向传播梯度到,该边框对应的proposal 边框的feature map上,生成此feature map的CAM图。

a) 下载

git clone https://github.com/facebookresearch/detectron2.gitb) 修改detectron2/modeling/roi_heads/fast_rcnn.py文件中的fast_rcnn_inference_single_image函数,主要是增加索引号,记录分值高的预测边框是由第几个proposal边框生成的;修改后的fast_rcnn_inference_single_image函数如下:

def fast_rcnn_inference_single_image(

boxes, scores, image_shape, score_thresh, nms_thresh, topk_per_image

):

"""

Single-image inference. Return bounding-box detection results by thresholding

on scores and applying non-maximum suppression (NMS).

Args:

Same as `fast_rcnn_inference`, but with boxes, scores, and image shapes

per image.

Returns:

Same as `fast_rcnn_inference`, but for only one image.

"""

valid_mask = torch.isfinite(boxes).all(dim=1) & torch.isfinite(scores).all(dim=1)

indices = torch.arange(start=0, end=scores.shape[0], dtype=int)

indices = indices.expand((scores.shape[1], scores.shape[0])).T

if not valid_mask.all():

boxes = boxes[valid_mask]

scores = scores[valid_mask]

indices = indices[valid_mask]

scores = scores[:, :-1]

indices = indices[:, :-1]

num_bbox_reg_classes = boxes.shape[1] // 4

# Convert to Boxes to use the `clip` function ...

boxes = Boxes(boxes.reshape(-1, 4))

boxes.clip(image_shape)

boxes = boxes.tensor.view(-1, num_bbox_reg_classes, 4) # R x C x 4

# Filter results based on detection scores

filter_mask = scores > score_thresh # R x K

# R' x 2. First column contains indices of the R predictions;

# Second column contains indices of classes.

filter_inds = filter_mask.nonzero()

if num_bbox_reg_classes == 1:

boxes = boxes[filter_inds[:, 0], 0]

else:

boxes = boxes[filter_mask]

scores = scores[filter_mask]

indices = indices[filter_mask]

# Apply per-class NMS

keep = batched_nms(boxes, scores, filter_inds[:, 1], nms_thresh)

if topk_per_image >= 0:

keep = keep[:topk_per_image]

boxes, scores, filter_inds = boxes[keep], scores[keep], filter_inds[keep]

indices = indices[keep]

result = Instances(image_shape)

result.pred_boxes = Boxes(boxes)

result.scores = scores

result.pred_classes = filter_inds[:, 1]

result.indices = indices

return result, filter_inds[:, 0]c) 安装;如遇到问题,请参考detectron2;不同操作系统安装有差异

cd detectron2

pip install -e .a) 预训练模型下载

wget https://dl.fbaipublicfiles.com/detectron2/PascalVOC-Detection/faster_rcnn_R_50_C4/142202221/model_final_b1acc2.pklb) 测试Grad-CAM图像生成

在本工程目录下执行如下命令

export KMP_DUPLICATE_LIB_OK=TRUE

python detection/demo.py --config-file detection/faster_rcnn_R_50_C4.yaml \

--input ./examples/pic1.jpg \

--opts MODEL.WEIGHTS /Users/yizuotian/pretrained_model/model_final_b1acc2.pkl MODEL.DEVICE cpu| 原始图像 | 检测边框 | Grad-CAM HeatMap | 边框预测类别 |

|---|---|---|---|

|

|

|

Dog |

|

|

|

aeroplane |

|

|

|

Person |

|

|

|

Horse |