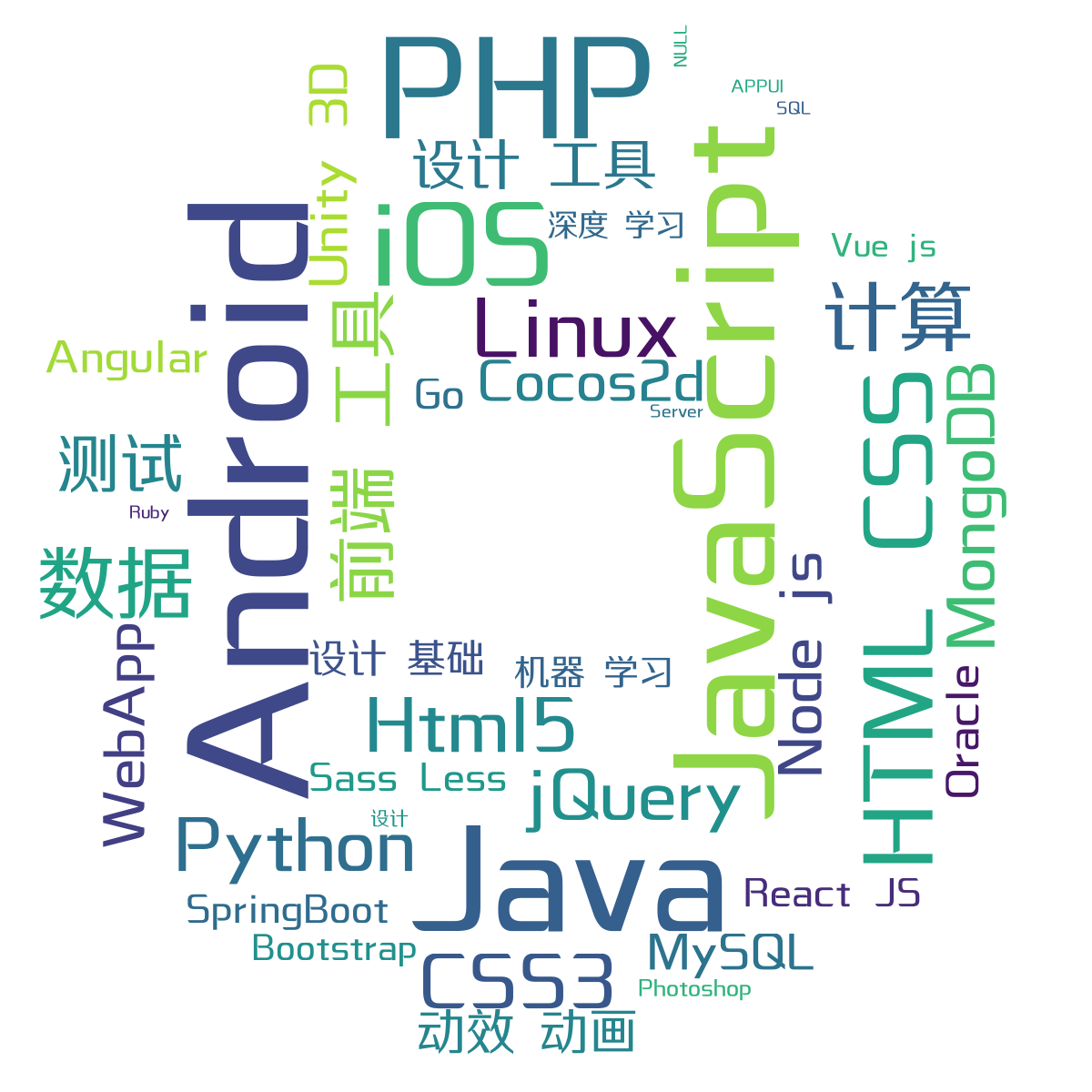

人生苦短, 我用Python!

| Ⅰ | Ⅱ | Ⅲ | Ⅳ | Ⅴ | Ⅵ | Ⅶ | Ⅷ | Ⅸ | X |

|---|---|---|---|---|---|---|---|---|---|

| 嗶哩嗶哩 | 豆瓣 | 优酷 | Pixiv | 网易云 | 微博 | 知乎 | 百度 | 微软 | 其他 |

- [Usage]:

python danmu.py $url - [Example]:

python danmu.py https://www.bilibili.com/video/av9933492/

- 使用方法:将要爬取的视频链接写入 'bili-pendant.txt'

- 根据相册 id 爬取所有图片,并保存到对应 id 目录下

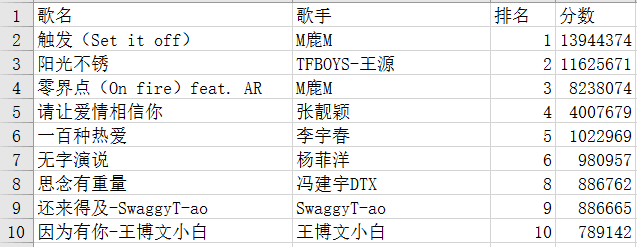

- 网易云获取歌曲

API为http://music.163.com/song/media/outer/url?id={song_id}.mp3 - 只需要传入对应歌曲的

song_id即可

- 使用前需要更新问题

id, 填入Cookie,include应该不需要更新

- 返回未验证方式是因为没有给headers传递

X-API-VERSION,X-UDID,authorization等参数 - 问题来自知乎一位朋友问我, 因此做的比较粗糙, 没有详细提取数据, 仅将答主提取出来

- 得到的一些答主 数据

- [Usage]:

python danmu.py $pid - [Example]:

python getTiebaPics.py 2271504759

- [Usage]:

python3 getBaiduPics.py [Word] [pages = 1] - [Example]:

python3 getBaiduPics.py 猫 30 - 注: 图片将保存在关键词的同名目录下。

爬取煎蛋网妹子图

- 有时间将爬取专辑的函数加上