Нам потребуются в GCP 4 ноды с образом Ubuntu 18.04 LTS

- master - 1 экземпляр (n1-standard-2)

- worker - 3 экземпляра (n1-standard-1)

На каждой машине

- Отключаем swap

sudo -i

swapoff -a- Включаем маршрутизацию

cat > /etc/sysctl.d/99-kubernetes-cri.conf <<EOF

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-ip6tables = 1

EOF

sysctl --system- Устанавливаем Docker

apt-get update && apt-get install -y \

apt-transport-https ca-certificates curl software-properties-common gnupg2curl -fsSL https://download.docker.com/linux/ubuntu/gpg | apt-key add -

add-apt-repository \

"deb [arch=amd64] https://download.docker.com/linux/ubuntu \

$(lsb_release -cs) \

stable"apt-get update && apt-get install -y \

containerd.io=1.2.13-1 \

docker-ce=5:19.03.8~3-0~ubuntu-$(lsb_release -cs) \

docker-ce-cli=5:19.03.8~3-0~ubuntu-$(lsb_release -cs)# Setup daemon.

cat > /etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2"

}

EOF

mkdir -p /etc/systemd/system/docker.service.d

# Restart docker.

systemctl daemon-reload

systemctl restart docker- Устанавливаем kubeadm, kubelet and kubectl

apt-get update && apt-get install -y apt-transport-https curl

curl -s https://packages.cloud.google.com/apt/doc/apt-key.gpg | apt-key add -

cat <<EOF > /etc/apt/sources.list.d/kubernetes.list

deb https://apt.kubernetes.io/ kubernetes-xenial main

EOF

apt-get update

apt-get install -y kubelet=1.17.4-00 kubeadm=1.17.4-00 kubectl=1.17.4-00- Создаем кластер

kubeadm init --pod-network-cidr=192.168.0.0/24В выводе будут:

- команда для копирования конфига kubectl

- сообщение о том, что необходимо установить сетевой плагин

- команда для присоединения worker ноды

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join 10.132.0.52:6443 --token u8gxos.mf3ok30ad4xlgqj4 \

--discovery-token-ca-cert-hash sha256:939bb3eb4be6e159e824b7f0b698a4e53e1b6ee59a7190d462cbc332a1731fec- Копируем конфиг kubectl

mkdir -p $HOME/.kube

cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

chown $(id -u):$(id -g) $HOME/.kube/config- Устанавливаем сетевой плагин (Документация)

kubectl apply -f https://docs.projectcalico.org/manifests/calico.yaml- Присоединяем остальные ноды

kubeadm join 10.132.0.52:6443 --token u8gxos.mf3ok30ad4xlgqj4 \

--discovery-token-ca-cert-hash sha256:939bb3eb4be6e159e824b7f0b698a4e53e1b6ee59a7190d462cbc332a1731fecЕсли вывод команды потерялся, токены можно посмотреть командой: kubeadm token list

Получить хеш

openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der

2>/dev/null | \

openssl dgst -sha256 -hex | sed 's/^.* //'- Проверяем

kubectl get nodes

NAME STATUS ROLES AGE VERSION

master Ready master 7m40s v1.17.4

worker1 Ready <none> 2m6s v1.17.4

worker2 Ready <none> 86s v1.17.4

worker3 Ready <none> 59s v1.17.4- Запуск нагрузки

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

replicas: 4

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.17.2

ports:

- containerPort: 80kubectl apply -f deployment.yaml

deployment.apps/nginx-deployment createdkubectl get pods

NAME READY STATUS RESTARTS AGE

nginx-deployment-c8fd555cc-46jzj 1/1 Running 0 41s

nginx-deployment-c8fd555cc-h8frd 1/1 Running 0 41s

nginx-deployment-c8fd555cc-jnkw4 1/1 Running 0 41s

nginx-deployment-c8fd555cc-m5nf4 1/1 Running 0 41s- Обновляем кластер

Так как кластер мы разворачивали с помощью kubeadm, то и производить обновление будем с помощью него.

Обновлять ноды будем по очереди.

Допускается, отставание версий worker-нод от master, но не наоборот. Поэтому обновление будем начинать с нее master-нода у нас версии 1.16.8

- Обновляем пакеты

apt-get update && apt-get install -y kubeadm=1.18.0-00 \

kubelet=1.18.0-00 kubectl=1.18.0-00- Проверка

kubectl get nodes

NAME STATUS ROLES AGE VERSION

master Ready master 14m v1.18.0

worker1 Ready <none> 8m55s v1.17.4

worker2 Ready <none> 8m15s v1.17.4

worker3 Ready <none> 7m48s v1.17.4kubelet --version

Kubernetes v1.18.0

cat /etc/kubernetes/manifests/kube-apiserver.yaml

image: k8s.gcr.io/kube-apiserver:v1.17.4- Обновим остальные компоненты кластера

kubeadm upgrade plan

[upgrade/config] Making sure the configuration is correct:

[upgrade/config] Reading configuration from the cluster...

[upgrade/config] FYI: You can look at this config file with 'kubectl -n kube-system get cm kubeadm-config -oyaml'

[preflight] Running pre-flight checks.

[upgrade] Running cluster health checks

[upgrade] Fetching available versions to upgrade to

[upgrade/versions] Cluster version: v1.17.9

[upgrade/versions] kubeadm version: v1.18.0

[upgrade/versions] Latest stable version: v1.18.6

[upgrade/versions] Latest stable version: v1.18.6

[upgrade/versions] Latest version in the v1.17 series: v1.17.9

[upgrade/versions] Latest version in the v1.17 series: v1.17.9

Components that must be upgraded manually after you have upgraded the control plane with 'kubeadm upgrade apply':

COMPONENT CURRENT AVAILABLE

Kubelet 3 x v1.17.4 v1.18.6

1 x v1.18.0 v1.18.6

Upgrade to the latest stable version:

COMPONENT CURRENT AVAILABLE

API Server v1.17.9 v1.18.6

Controller Manager v1.17.9 v1.18.6

Scheduler v1.17.9 v1.18.6

Kube Proxy v1.17.9 v1.18.6

CoreDNS 1.6.5 1.6.7

Etcd 3.4.3 3.4.3-0

You can now apply the upgrade by executing the following command:

kubeadm upgrade apply v1.18.6

Note: Before you can perform this upgrade, you have to update kubeadm to v1.18.6.

_____________________________________________________________________- Применим изменения

kubeadm upgrade apply v1.18.0- Проверка

kubeadm version

kubeadm version: &version.Info{Major:"1", Minor:"18", GitVersion:"v1.18.0", GitCommit:"9e991415386e4cf155a24b1da15b

ecaa390438d8", GitTreeState:"clean", BuildDate:"2020-03-25T14:56:30Z", GoVersion:"go1.13.8", Compiler:"gc", Platfor

m:"linux/amd64"}

kubelet --version

Kubernetes v1.18.0

kubectl version

Client Version: version.Info{Major:"1", Minor:"18", GitVersion:"v1.18.0", GitCommit:"9e991415386e4cf155a24b1da15bec

aa390438d8", GitTreeState:"clean", BuildDate:"2020-03-25T14:58:59Z", GoVersion:"go1.13.8", Compiler:"gc", Platform:

"linux/amd64"}

Server Version: version.Info{Major:"1", Minor:"18", GitVersion:"v1.18.0", GitCommit:"9e991415386e4cf155a24b1da15bec

aa390438d8", GitTreeState:"clean", BuildDate:"2020-03-25T14:50:46Z", GoVersion:"go1.13.8", Compiler:"gc", Platform:

"linux/amd64"}kubectl describe pod kube-apiserver-master -n kube-system

Name: kube-apiserver-master

Namespace: kube-system

Priority: 2000000000

Priority Class Name: system-cluster-critical

Node: master/10.132.0.52

Start Time: Fri, 31 Jul 2020 22:17:25 +0000

Labels: component=kube-apiserver

tier=control-plane

Annotations: kubeadm.kubernetes.io/kube-apiserver.advertise-address.endpoint: 10.132.0.52:6443

kubernetes.io/config.hash: 6f8d44727c25dcb6d73add9fc1b1ea33

kubernetes.io/config.mirror: 6f8d44727c25dcb6d73add9fc1b1ea33

kubernetes.io/config.seen: 2020-07-31T22:33:56.757141182Z

kubernetes.io/config.source: file

Status: Running

IP: 10.132.0.52

IPs:

IP: 10.132.0.52

Controlled By: Node/master

Containers:

kube-apiserver:

Container ID: docker://53f03fb4f66819192bdf6c189a4d584aa386ce4304fa1447b1e3201da4bea860

Image: k8s.gcr.io/kube-apiserver:v1.18.0

Image ID: docker-pullable://k8s.gcr.io/kube-apiserver@sha256:fc4efb55c2a7d4e7b9a858c67e24f00e739df4ef50825

00c2b60ea0903f18248

Port: <none>

Host Port: <none>

Command:

kube-apiserver

--advertise-address=10.132.0.52

--allow-privileged=true

--authorization-mode=Node,RBAC

--client-ca-file=/etc/kubernetes/pki/ca.crt

--enable-admission-plugins=NodeRestriction

--enable-bootstrap-token-auth=true

--etcd-cafile=/etc/kubernetes/pki/etcd/ca.crt

--etcd-certfile=/etc/kubernetes/pki/apiserver-etcd-client.crt

--etcd-keyfile=/etc/kubernetes/pki/apiserver-etcd-client.key

--etcd-servers=https://127.0.0.1:2379

--insecure-port=0

--kubelet-client-certificate=/etc/kubernetes/pki/apiserver-kubelet-client.crt

--kubelet-client-key=/etc/kubernetes/pki/apiserver-kubelet-client.key

--kubelet-preferred-address-types=InternalIP,ExternalIP,Hostname

--proxy-client-cert-file=/etc/kubernetes/pki/front-proxy-client.crt

--proxy-client-key-file=/etc/kubernetes/pki/front-proxy-client.key

--requestheader-allowed-names=front-proxy-client

--requestheader-client-ca-file=/etc/kubernetes/pki/front-proxy-ca.crt

--requestheader-extra-headers-prefix=X-Remote-Extra-

--requestheader-group-headers=X-Remote-Group

--requestheader-username-headers=X-Remote-User

--secure-port=6443

--service-account-key-file=/etc/kubernetes/pki/sa.pub

--service-cluster-ip-range=10.96.0.0/12

--tls-cert-file=/etc/kubernetes/pki/apiserver.crt

--tls-private-key-file=/etc/kubernetes/pki/apiserver.key

State: Running

Started: Fri, 31 Jul 2020 22:33:57 +0000

Ready: True

Restart Count: 0

Requests:

cpu: 250m

Liveness: http-get https://10.132.0.52:6443/healthz delay=15s timeout=15s period=10s #success=1 #failure=8

Environment: <none>

Mounts:

/etc/ca-certificates from etc-ca-certificates (ro)

/etc/kubernetes/pki from k8s-certs (ro)

/etc/ssl/certs from ca-certs (ro)

/usr/local/share/ca-certificates from usr-local-share-ca-certificates (ro)

/usr/share/ca-certificates from usr-share-ca-certificates (ro)

Conditions:

Type Status

Initialized True

Ready True

ContainersReady True

PodScheduled True

Volumes:

ca-certs:

Type: HostPath (bare host directory volume)

Path: /etc/ssl/certs

HostPathType: DirectoryOrCreate

etc-ca-certificates:

Type: HostPath (bare host directory volume)

Path: /etc/ca-certificates

HostPathType: DirectoryOrCreate

k8s-certs:

Type: HostPath (bare host directory volume)

Path: /etc/kubernetes/pki

HostPathType: DirectoryOrCreate

usr-local-share-ca-certificates:

Type: HostPath (bare host directory volume)

Path: /usr/local/share/ca-certificates

HostPathType: DirectoryOrCreate

usr-share-ca-certificates:

Type: HostPath (bare host directory volume)

Path: /usr/share/ca-certificates

HostPathType: DirectoryOrCreate

QoS Class: Burstable

Node-Selectors: <none>

Tolerations: :NoExecute

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal Pulled 2m28s kubelet, master Container image "k8s.gcr.io/kube-apiserver:v1.18.0" already present on m

achine

Normal Created 2m28s kubelet, master Created container kube-apiserver

Normal Started 2m28s kubelet, master Started container kube-apiserver- Вывод worker-нод из планирования

Первым делом, мы сливаем всю нагрузку с ноды и выводим ее из планирования

kubectl drain worker1

node/worker1 cordoned

error: unable to drain node "worker1", aborting command...

There are pending nodes to be drained:

worker1

error: cannot delete DaemonSet-managed Pods (use --ignore-daemonsets to ignore): kube-system/calico-node-26ppd, kub

e-system/kube-proxy-clnf8kubectl drain убирает всю нагрузку, кроме DaemonSet, поэтому мы явно должны сказать, что уведомлены об этом

kubectl drain worker1 --ignore-daemonsets

node/worker1 already cordoned

WARNING: ignoring DaemonSet-managed Pods: kube-system/calico-node-26ppd, kube-system/kube-proxy-clnf8

evicting pod default/nginx-deployment-c8fd555cc-h8frd

evicting pod default/nginx-deployment-c8fd555cc-m5nf4

pod/nginx-deployment-c8fd555cc-h8frd evicted

pod/nginx-deployment-c8fd555cc-m5nf4 evicted

node/worker1 evicted- Когда мы вывели ноду на обслуживание, к статусу добавилась строчка SchedulingDisabled

kubectl get nodes -o wide

NAME STATUS ROLES AGE VERSION INTERNAL-IP EXTERNAL-IP OS-IMAGE KERNEL-VERSION CONTAINER-RUNTIME

master Ready master 22m v1.18.0 10.132.0.52 <none> Ubuntu 18.04.4 LTS 5.3.0-1032-gcp docker://19.3.8

worker1 Ready,SchedulingDisabled <none> 17m v1.17.4 10.132.0.53 <none> Ubuntu 18.04.4 LTS 5.3.0-1032-gcp docker://19.3.8

worker2 Ready <none> 16m v1.17.4 10.132.0.54 <none> Ubuntu 18.04.4 LTS 5.3.0-1032-gcp docker://19.3.8

worker3 Ready <none> 15m v1.17.4 10.132.0.55 <none> Ubuntu 18.04.4 LTS 5.3.0-1032-gcp docker://19.3.8- Обновление worker-нод

apt-get install -y kubelet=1.18.0-00 kubeadm=1.18.0-00

systemctl restart kubelet- После обновления kubectl показывает новую версию, и статус SchedulingDisabled

kubectl get nodes

NAME STATUS ROLES AGE VERSION

master Ready master 23m v1.18.0

worker1 Ready,SchedulingDisabled <none> 18m v1.18.0

worker2 Ready <none> 17m v1.17.4

worker3 Ready <none> 16m v1.17.4- Командой kubectl uncordon worker-instance-1 возвращаем ноду обратно в планирование нагрузки

kubectl uncordon worker1- Обновим остальные ноды и получим

kubectl get nodes

NAME STATUS ROLES AGE VERSION

master Ready master 27m v1.18.0

worker1 Ready <none> 21m v1.18.0

worker2 Ready <none> 21m v1.18.0

worker3 Ready <none> 20m v1.18.0В данном задании ради демонстрации механики обновления мы вручную развернули и обновили кластер с одной master-нодой.

Но развертывать большие кластера подобным способом не удобно. Поэтому мы рассмотрим инструмент для автоматического развертывания кластеров kubespray.

Kubespray - это Ansible playbook для установки Kubernetes. Для его использования достаточно иметь SSH-доступ на машины, поэтому не важно как они были созданы (Cloud, Bare-metal).

- Установка kubespray

Пре-реквизиты:

- Python и pip на локальной машине

- SSH доступ на все ноды кластера

# получение kubespray

git clone https://github.com/kubernetes-sigs/kubespray.git

# установка зависимостей

sudo pip install -r requirements.txt

# копирование примера конфига в отдельную директорию

cp -rfp inventory/sample inventory/myclusterДобавьте адреса машин кластера в конфиг kubespray inventory/mycluster/inventory.ini:

# в блоке all мы описывем все машины (master и worker)

# для мастер нод мы указывем переменную etcd_member_name

[all]

node1 ansible_host=192.168.10.1 etcd_member_name=etcd1

node2 ansible_host=192.168.10.2

node3 ansible_host=192.168.10.3

node4 ansible_host=192.168.10.4

# в блоке kube-master мы указывем master-ноды

[kube-master]

node1

# в блоке etcd ноды, где будет установлен etcd

# если мы хотим HA кластер, то etcd устанавливаетcя отдельно от API-server

[etcd]

node1

# в блоке kube-node описываем worker-ноды

[kube-node]

node2

node3

node4

# в блоке k8s-cluster:children соединяем kube-master и kube-node

[k8s-cluster:children]

kube-master

kube-node- После редактирования конфига можно устанавливать кластер

ansible-playbook -i inventory/mycluster/inventory.ini --become --become-user=root \

--user=${SSH_USERNAME} --key-file=${SSH_PRIVATE_KEY} cluster.ymlВыполним установку кластера с 3 master-нодами, 2 worker нодами и external etcd topology. Используем kubeadm, keekalived, haproxy.

Документация

/etc/keepalived/keepalived.conf

! /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

router_id LVS_DEVEL

}

vrrp_script check_apiserver {

script "/etc/keepalived/check_apiserver.sh"

interval 3

weight -2

fall 10

rise 2

}

vrrp_instance VI_1 {

state MASTER

interface ens160

virtual_router_id 51

priority 101

authentication {

auth_type PASS

auth_pass 42

}

virtual_ipaddress {

10.2.1.1

}

track_script {

check_apiserver

}

}/etc/keepalived/check_apiserver.sh

#!/bin/sh

errorExit() {

echo "*** $*" 1>&2

exit 1

}

curl --silent --max-time 2 --insecure https://localhost:6443/healthz -o /dev/null || errorExit "Error GET https://localhost:6443/healthz"

if ip addr | grep -q 10.2.1.1; then

curl --silent --max-time 2 --insecure https://10.2.1.1:6443/healthz -o /dev/null || errorExit "Error GET https://10.2.1.1:6443/healthz"

fi/etc/haproxy/haproxy.cfg

# /etc/haproxy/haproxy.cfg

#---------------------------------------------------------------------

# Global settings

#---------------------------------------------------------------------

global

log /dev/log local0

log /dev/log local1 notice

daemon

#---------------------------------------------------------------------

# common defaults that all the 'listen' and 'backend' sections will

# use if not designated in their block

#---------------------------------------------------------------------

defaults

mode http

log global

option httplog

option dontlognull

option http-server-close

option forwardfor except 127.0.0.0/8

option redispatch

retries 1

timeout http-request 10s

timeout queue 20s

timeout connect 5s

timeout client 20s

timeout server 20s

timeout http-keep-alive 10s

timeout check 10s

#---------------------------------------------------------------------

# apiserver frontend which proxys to the masters

#---------------------------------------------------------------------

frontend apiserver

bind *:6443

mode tcp

option tcplog

default_backend apiserver

#---------------------------------------------------------------------

# round robin balancing for apiserver

#---------------------------------------------------------------------

backend apiserver

mode tcp

balance roundrobin

option tcp-check

server dev_master1 10.2.1.5:6443 check

server dev_master2 10.2.1.6:6443 check

server dev_master2 10.2.1.7:6443 check/etc/keepalived/keepalived.conf

! /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

router_id LVS_DEVEL

}

vrrp_script check_apiserver {

script "/etc/keepalived/check_apiserver.sh"

interval 3

weight -2

fall 10

rise 2

}

vrrp_instance VI_1 {

state BACKUP

interface ens160

virtual_router_id 51

priority 100

authentication {

auth_type PASS

auth_pass 42

}

virtual_ipaddress {

10.2.1.1

}

track_script {

check_apiserver

}

}/etc/keepalived/check_apiserver.sh

#!/bin/sh

errorExit() {

echo "*** $*" 1>&2

exit 1

}

curl --silent --max-time 2 --insecure https://localhost:6443/healthz -o /dev/null || errorExit "Error GET https://localhost:6443/healthz"

if ip addr | grep -q 10.2.1.1; then

curl --silent --max-time 2 --insecure https://10.2.1.1:6443/healthz -o /dev/null || errorExit "Error GET https://10.2.1.1:6443/healthz"

fi/etc/haproxy/haproxy.cfg

# /etc/haproxy/haproxy.cfg

#---------------------------------------------------------------------

# Global settings

#---------------------------------------------------------------------

global

log /dev/log local0

log /dev/log local1 notice

daemon

#---------------------------------------------------------------------

# common defaults that all the 'listen' and 'backend' sections will

# use if not designated in their block

#---------------------------------------------------------------------

defaults

mode http

log global

option httplog

option dontlognull

option http-server-close

option forwardfor except 127.0.0.0/8

option redispatch

retries 1

timeout http-request 10s

timeout queue 20s

timeout connect 5s

timeout client 20s

timeout server 20s

timeout http-keep-alive 10s

timeout check 10s

#---------------------------------------------------------------------

# apiserver frontend which proxys to the masters

#---------------------------------------------------------------------

frontend apiserver

bind *:6443

mode tcp

option tcplog

default_backend apiserver

#---------------------------------------------------------------------

# round robin balancing for apiserver

#---------------------------------------------------------------------

backend apiserver

mode tcp

balance roundrobin

option tcp-check

server dev_master1 10.2.1.5:6443 check

server dev_master2 10.2.1.6:6443 check

server dev_master2 10.2.1.7:6443 checkРезультат

kubectl get nodes

NAME STATUS ROLES AGE VERSION

dev-master1 Ready master 1d v1.18.3

dev-master2 Ready master 1d v1.18.3

dev-master3 Ready master 1d v1.18.3

dev-worker1 Ready <none> 1d v1.18.3

dev-worker2 Ready <none> 1d v1.18.3

Устанавливам в наш кластер kubectl debug

brew install aylei/tap/kubectl-debugИ применяем манифест агента

kubectl apply -f strace/agent_daemonset.yml

daemonset.apps/debug-agent createdЗапускаем pod с приложением

kubectl apply -f strace/nginx.yaml

pod/nginx createdЗапускаем debug

kubectl-debug nginx --agentless=false --port-forward=true

bash-5.0# strace -p 1

strace: attach: ptrace(PTRACE_SEIZE, 1): Operation not permittedВидим, что не хватает capability, которые есть в версии v0.1.1.

Меняем image tag и применяем манифест

kubectl apply -f strace/agent_daemonset.yml

daemonset.apps/debug-agent configuredПроверяем, что все в порядке

kubectl-debug nginx --agentless=false --port-forward=true

bash-5.0# strace -c -p1

strace: Process 1 attachedОдин из полезных инструментов - это kube-iptables-tailer.

Он предназначен для того, чтобы выводить информацию об отброшенных iptables пакетах в журнал событий Kubernetes (kubectl get events).

Основной кейс - сообщить разработчикам сервисов о проблемах с NetworkPolicy.

Установим netperf-operator

- Это Kubernetes-оператор, который позволяет запускать тесты пропускной способности сети между нодами кластера

- Сам проект - не очень production-grade, но иногда выручает

kubectl apply -f https://raw.githubusercontent.com/piontec/netperf-operator/master/deploy/crd.yaml

kubectl apply -f https://raw.githubusercontent.com/piontec/netperf-operator/master/deploy/rbac.yaml

kubectl apply -f https://raw.githubusercontent.com/piontec/netperf-operator/master/deploy/operator.yaml

kubectl apply -f https://raw.githubusercontent.com/piontec/netperf-operator/master/deploy/cr.yamlПроверяем

kubectl describe netperf.app.example.com/example

Name: example

Namespace: default

Labels: <none>

Annotations: kubectl.kubernetes.io/last-applied-configuration:

{"apiVersion":"app.example.com/v1alpha1","kind":"Netperf","metadata":{"annotations":{},"name":"example","namespace":"default"}}

API Version: app.example.com/v1alpha1

Kind: Netperf

Metadata:

Creation Timestamp: 2020-07-31T14:39:27Z

Generation: 4

Resource Version: 1162239

Self Link: /apis/app.example.com/v1alpha1/namespaces/default/netperfs/example

UID: 983574f7-60db-4ccb-8a09-d0f7c738dd20

Spec:

Client Node:

Server Node:

Status:

Client Pod: netperf-client-d0f7c738dd20

Server Pod: netperf-server-d0f7c738dd20

Speed Bits Per Sec: 12478.8

Status: Done

Events: <none>Видим статус Done и скорость: 12478 bps

Добавим сетевую политику для Calicoo, чтобы ограничить доступ к подам Netperf и включить логирование в iptables

kubectl apply -f kit/netperf-calico-policy.yamlПерезапустим тест удалив cr и создав вновь

kubectl delete -f kit/deploy/cr.yaml

netperf.app.example.com "example" deleted

kubectl apply -f kit/deploy/cr.yaml

netperf.app.example.com/example createdПроверим:

kubectl describe netperf.app.example.com/example

Name: example

Namespace: default

Labels: <none>

Annotations: kubectl.kubernetes.io/last-applied-configuration:

{"apiVersion":"app.example.com/v1alpha1","kind":"Netperf","metadata":{"annotations":{},"name":"example","namespace":"default"}}

API Version: app.example.com/v1alpha1

Kind: Netperf

Metadata:

Creation Timestamp: 2020-07-31T14:47:20Z

Generation: 3

Resource Version: 1164540

Self Link: /apis/app.example.com/v1alpha1/namespaces/default/netperfs/example

UID: 704fc8e5-7f7f-4035-aa2d-60cdcba88958

Spec:

Client Node:

Server Node:

Status:

Client Pod: netperf-client-60cdcba88958

Server Pod: netperf-server-60cdcba88958

Speed Bits Per Sec: 0

Status: Started test

Events: <none>Видим, что тест висит в состоянии Starting. В нашей сетевой политике есть ошибка.

Проверим, что в логах ноды Kubernetes появились сообщения об отброшенных пакетах

kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

netperf-client-60cdcba88958 1/1 Running 0 108s 10.32.0.15 gke-cluster-1-default-pool-02a8e156-dr3f <none> <none>

netperf-operator-85569b59dd-hgvnn 1/1 Running 0 9m44s 10.32.2.6 gke-cluster-1-default-pool-3d470404-lm1s <none> <none>

netperf-server-60cdcba88958 1/1 Running 0 110s 10.32.0.14 gke-cluster-1-default-pool-02a8e156-dr3f <none> <none>Подключимся к ноде по ssh

gcloud compute ssh gke-cluster-1-default-pool-02a8e156-dr3fiptables --list -nv | grep DROP

19 1140 DROP all -- * * 0.0.0.0/0 0.0.0.0/0 /* cali:He8TRqGPuUw3VGwk */счетчики дропов ненулевые

iptables --list -nv | grep LOG

21 1260 LOG all -- * * 0.0.0.0/0 0.0.0.0/0 /* cali:B30DykF1ntLW86eD */ LOG flags 0 level 5 prefix "calico-packet: "счетчики с действием логирования ненулевые

journalctl -k | grep calico

Jul 31 14:52:04 gke-cluster-1-default-pool-02a8e156-dr3f kernel: calico-packet: IN=cali34a48ed36b3 OUT=cali2ff164dea95 MAC=ee:ee:ee:ee:ee:ee:76:35:a4:01:96:bd:08:00 SRC=10.32.0.15 DST=10.32.0.14 LEN=60 TOS=0x00 PREC=0x00 TTL=63 ID=16881 DF PROTO=TCP SPT=48029 DPT=12865 WINDOW=42600 RES=0x00 SYN URGP=0

Jul 31 14:52:12 gke-cluster-1-default-pool-02a8e156-dr3f kernel: calico-packet: IN=cali34a48ed36b3 OUT=cali2ff164dea95 MAC=ee:ee:ee:ee:ee:ee:76:35:a4:01:96:bd:08:00 SRC=10.32.0.15 DST=10.32.0.14 LEN=60 TOS=0x00 PREC=0x00 TTL=63 ID=16882 DF PROTO=TCP SPT=48029 DPT=12865 WINDOW=42600 RES=0x00 SYN URGP=0

Jul 31 14:52:28 gke-cluster-1-default-pool-02a8e156-dr3f kernel: calico-packet: IN=cali34a48ed36b3 OUT=cali2ff164dea95 MAC=ee:ee:ee:ee:ee:ee:76:35:a4:01:96:bd:08:00 SRC=10.32.0.15 DST=10.32.0.14 LEN=60 TOS=0x00 PREC=0x00 TTL=63 ID=16883 DF PROTO=TCP SPT=48029 DPT=12865 WINDOW=42600 RES=0x00 SYN URGP=0

Jul 31 14:53:01 gke-cluster-1-default-pool-02a8e156-dr3f kernel: calico-packet: IN=cali34a48ed36b3 OUT=cali2ff164dea95 MAC=ee:ee:ee:ee:ee:ee:76:35:a4:01:96:bd:08:00 SRC=10.32.0.15 DST=10.32.0.14 LEN=60 TOS=0x00 PREC=0x00 TTL=63 ID=16884 DF PROTO=TCP SPT=48029 DPT=12865 WINDOW=42600 RES=0x00 SYN URGP=0Установим iptables-tailer

Поправим манифест iptables-tailer.yaml

env:

- name: "JOURNAL_DIRECTORY"

value: "/var/log/journal"

- name: "IPTABLES_LOG_PREFIX"

value: "calico-packet:"iptables-tailer умеет работать с systemd journal - для этого надо передать ему параметр JOURNAL_DIRECTORY б указав каталог с файлами журнала (по умолчанию, /var/log/journal)

kubectl apply -f kit/deploy/kit-serviceaccount.yaml

kubectl apply -f kit/deploy/kit-clusterrole.yaml

kubectl apply -f kit/deploy/kit-clusterrolebinding.yaml

kubectl apply -f kit/deploy/iptables-tailer.yamlПерезапустим тест удалив cr и создав вновь

kubectl delete -f kit/deploy/cr.yaml

netperf.app.example.com "example" deleted

kubectl apply -f kit/deploy/cr.yaml

netperf.app.example.com/example createdПроверим

kubectl describe pod --selector=app=netperf-operator

Name: netperf-server-f6b4c7e04d56

Namespace: default

Priority: 0

Node: gke-cluster-1-default-pool-068f038d-4h0p/10.166.0.3

Start Time: Fri, 31 Jul 2020 18:11:25 +0300

Labels: app=netperf-operator

netperf-type=server

Annotations: cni.projectcalico.org/podIP: 10.32.1.4/32

kubernetes.io/limit-ranger: LimitRanger plugin set: cpu request for container netperf-server-f6b4c7e04d56

Status: Running

IP: 10.32.1.4

IPs:

IP: 10.32.1.4

Controlled By: Netperf/example

Containers:

netperf-server-f6b4c7e04d56:

Container ID: docker://47233e57a3a83ef573d8e28be8adbaf2f6cb14b25869e204e4b84c5b13e24a3a

Image: tailoredcloud/netperf:v2.7

Image ID: docker-pullable://tailoredcloud/netperf@sha256:0361f1254cfea87ff17fc1bd8eda95f939f99429856f766db3340c8cdfed1cf1

Port: <none>

Host Port: <none>

State: Running

Started: Fri, 31 Jul 2020 18:11:30 +0300

Ready: True

Restart Count: 0

Requests:

cpu: 100m

Environment: <none>

Mounts:

/var/run/secrets/kubernetes.io/serviceaccount from default-token-66ln5 (ro)

Conditions:

Type Status

Initialized True

Ready True

ContainersReady True

PodScheduled True

Volumes:

default-token-66ln5:

Type: Secret (a volume populated by a Secret)

SecretName: default-token-66ln5

Optional: false

QoS Class: Burstable

Node-Selectors: <none>

Tolerations: node.kubernetes.io/not-ready:NoExecute for 300s

node.kubernetes.io/unreachable:NoExecute for 300s

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal Scheduled 9m34s default-scheduler Successfully assigned default/netperf-server-f6b4c7e04d56 to gke-cluster-1-default-pool-068f038d-4h0p

Normal Pulling 9m33s kubelet, gke-cluster-1-default-pool-068f038d-4h0p Pulling image "tailoredcloud/netperf:v2.7"

Normal Pulled 9m30s kubelet, gke-cluster-1-default-pool-068f038d-4h0p Successfully pulled image "tailoredcloud/netperf:v2.7"

Normal Created 9m30s kubelet, gke-cluster-1-default-pool-068f038d-4h0p Created container netperf-server-f6b4c7e04d56

Normal Started 9m29s kubelet, gke-cluster-1-default-pool-068f038d-4h0p Started container netperf-server-f6b4c7e04d56

Warning PacketDrop 9m24s kube-iptables-tailer Packet dropped when receiving traffic from 10.32.2.8

Warning PacketDrop 2m14s (x3 over 7m12s) kube-iptables-tailer Packet dropped when receiving traffic from client (10.32.2.8)Теперь можно наблюдать в events сообщения о дропах пакетов

- Исправим ошибку в нашей сетевой политике, чтобы Netperf снова начал работать

ingress:

- action: Allow

source:

selector: app == "netperf-operator"

- action: Log

- action: Deny

egress:

- action: Allow

destination:

selector: app == "netperf-operator"

- action: Log

- action: Deny- Поправим манифест DaemonSet из репозитория, чтобы в логах отображались имена Podов, а не их IP-адреса

Приведем iptables-tailer.yaml к следующему виду

env:

- name: "POD_IDENTIFIER"

value: "name"

# - name: "POD_IDENTIFIER_LABEL"

# value: "netperf-type"Результат:

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Warning PacketDrop 89s kube-iptables-tailer Packet dropped when receiving traffic from netperf-client-6a28b0921dda (10.32.2.14)https://github.com/kubernetes-csi/csi-driver-host-path/blob/master/docs/deploy-1.17-and-later.md

Разворачиваем кластер

kind create cluster --config ./cluster/cluster.yamlКлонируем репозиторий

git clone git@github.com:kubernetes-csi/csi-driver-host-path.gitПрименяем CRD

# Change to the latest supported snapshotter version

export SNAPSHOTTER_VERSION=v2.0.1

# Apply VolumeSnapshot CRDs

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/$SNAPSHOTTER_VERSION/config/crd/snapshot.storage.k8s.io_volumesnapshotclasses.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/$SNAPSHOTTER_VERSION/config/crd/snapshot.storage.k8s.io_volumesnapshotcontents.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/$SNAPSHOTTER_VERSION/config/crd/snapshot.storage.k8s.io_volumesnapshots.yaml

# Create snapshot controller

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/$SNAPSHOTTER_VERSION/deploy/kubernetes/snapshot-controller/rbac-snapshot-controller.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/$SNAPSHOTTER_VERSION/deploy/kubernetes/snapshot-controller/setup-snapshot-controller.yamlУстанавливаем драйвер

./csi-driver-host-path/deploy/kubernetes-1.18/deploy.shПроверяем поды

kubectl get pods

NAME READY STATUS RESTARTS AGE

csi-hostpath-attacher-0 1/1 Running 0 106s

csi-hostpath-provisioner-0 1/1 Running 0 105s

csi-hostpath-resizer-0 1/1 Running 0 104s

csi-hostpath-snapshotter-0 1/1 Running 0 103s

csi-hostpath-socat-0 1/1 Running 0 103s

csi-hostpathplugin-0 3/3 Running 0 105s

snapshot-controller-0 1/1 Running 0 5m48sПроверяем storageclass

kubectl get sc

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE

standard (default) rancher.io/local-path Delete WaitForFirstConsumer false 12mПрименяем манифесты sc, pvc, app

for i in ./hw/csi-storageclass.yaml ./hw/csi-pvc.yaml ./hw/csi-app.yaml; do kubectl apply -f $i; done

storageclass.storage.k8s.io/csi-hostpath-sc created

persistentvolumeclaim/csi-pvc created

pod/my-csi-app createdkubectl get pv

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

pvc-220ed5b5-ebd4-4a64-bb9a-c1fa567d47b7 1Gi RWO Delete Bound default/csi-pvc csi-hostpath-sc 7skubectl get pvc

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

csi-pvc Bound pvc-220ed5b5-ebd4-4a64-bb9a-c1fa567d47b7 1Gi RWO csi-hostpath-sc 28sИнспектируем под

kubectl describe pods/my-csi-app

Name: my-csi-app

Namespace: default

Priority: 0

Node: kind-worker/172.18.0.2

Start Time: Tue, 28 Jul 2020 00:46:36 +0300

Labels: <none>

Annotations: kubectl.kubernetes.io/last-applied-configuration:

{"apiVersion":"v1","kind":"Pod","metadata":{"annotations":{},"name":"my-csi-app","namespace":"default"},"spec":{"containers":[{"command":[...

Status: Running

IP: 10.244.1.9

IPs:

IP: 10.244.1.9

Containers:

my-frontend:

Container ID: containerd://487ab4754a47e7f467cb6e27e2c47604881ae02c12e472f084f2e7285c6d5bbd

Image: busybox

Image ID: docker.io/library/busybox@sha256:9ddee63a712cea977267342e8750ecbc60d3aab25f04ceacfa795e6fce341793

Port: <none>

Host Port: <none>

Command:

sleep

1000000

State: Running

Started: Tue, 28 Jul 2020 00:46:45 +0300

Ready: True

Restart Count: 0

Environment: <none>

Mounts:

/data from my-csi-volume (rw)

/var/run/secrets/kubernetes.io/serviceaccount from default-token-p2sd2 (ro)

Conditions:

Type Status

Initialized True

Ready True

ContainersReady True

PodScheduled True

Volumes:

my-csi-volume:

Type: PersistentVolumeClaim (a reference to a PersistentVolumeClaim in the same namespace)

ClaimName: csi-pvc

ReadOnly: false

default-token-p2sd2:

Type: Secret (a volume populated by a Secret)

SecretName: default-token-p2sd2

Optional: false

QoS Class: BestEffort

Node-Selectors: <none>

Tolerations: node.kubernetes.io/not-ready:NoExecute for 300s

node.kubernetes.io/unreachable:NoExecute for 300s

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal Scheduled 44s default-scheduler Successfully assigned default/my-csi-app to kind-worker

Normal SuccessfulAttachVolume 44s attachdetach-controller AttachVolume.Attach succeeded for volume "pvc-220ed5b5-ebd4-4a64-bb9a-c1fa567d47b7"

Normal Pulling 40s kubelet, kind-worker Pulling image "busybox"

Normal Pulled 35s kubelet, kind-worker Successfully pulled image "busybox"

Normal Created 35s kubelet, kind-worker Created container my-frontend

Normal Started 35s kubelet, kind-worker Started container my-frontendНас интересует следующая информация

Mounts:

/data from my-csi-volume (rw)

Volumes:

my-csi-volume:

Type: PersistentVolumeClaim (a reference to a PersistentVolumeClaim in the same namespace)

ClaimName: csi-pvc

ReadOnly: false

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal SuccessfulAttachVolume 44s attachdetach-controller AttachVolume.Attach succeeded for volume "pvc-220ed5b5-ebd4-4a64-bb9a-c1fa567d47b7"

Подтверждение создания объекта VolumeAttachment

kubectl describe volumeattachment

Name: csi-eb85c21cc2107b883d10fdb1bf15fce62d06166aa889b7528588c1e41e8d3942

Namespace:

Labels: <none>

Annotations: <none>

API Version: storage.k8s.io/v1

Kind: VolumeAttachment

Metadata:

Creation Timestamp: 2020-07-27T21:46:36Z

Managed Fields:

API Version: storage.k8s.io/v1

Fields Type: FieldsV1

fieldsV1:

f:status:

f:attached:

Manager: csi-attacher

Operation: Update

Time: 2020-07-27T21:46:36Z

API Version: storage.k8s.io/v1

Fields Type: FieldsV1

fieldsV1:

f:spec:

f:attacher:

f:nodeName:

f:source:

f:persistentVolumeName:

Manager: kube-controller-manager

Operation: Update

Time: 2020-07-27T21:46:36Z

Resource Version: 1189

Self Link: /apis/storage.k8s.io/v1/volumeattachments/csi-eb85c21cc2107b883d10fdb1bf15fce62d06166aa889b7528588c1e41e8d3942

UID: f9858161-7497-4200-a5ed-0a736d029a52

Spec:

Attacher: hostpath.csi.k8s.io

Node Name: kind-worker

Source:

Persistent Volume Name: pvc-220ed5b5-ebd4-4a64-bb9a-c1fa567d47b7

Status:

Attached: true

Events: <none>Запишем данные в volume

kubectl exec -it my-csi-app /bin/sh

/ # touch /data/hello-world

/ # ls -la /data

total 8

drwxr-xr-x 2 root root 4096 Jul 27 21:24 .

drwxr-xr-x 1 root root 4096 Jul 27 21:15 ..

-rw-r--r-- 1 root root 0 Jul 27 21:24 hello-worldСоздадим snapshot

kubectl apply -f hw/csi-snapshot-v1beta1.yaml

volumesnapshot.snapshot.storage.k8s.io/new-snapshot-demo createdУбедимся, что snapshot создался

kubectl get volumesnapshot

NAME AGE

new-snapshot-demo 94skubectl describe volumesnapshot

Name: new-snapshot-demo

Namespace: default

Labels: <none>

Annotations: kubectl.kubernetes.io/last-applied-configuration:

{"apiVersion":"snapshot.storage.k8s.io/v1beta1","kind":"VolumeSnapshot","metadata":{"annotations":{},"name":"new-snapshot-demo","namespace...

API Version: snapshot.storage.k8s.io/v1beta1

Kind: VolumeSnapshot

Metadata:

Creation Timestamp: 2020-07-27T21:49:13Z

Finalizers:

snapshot.storage.kubernetes.io/volumesnapshot-as-source-protection

snapshot.storage.kubernetes.io/volumesnapshot-bound-protection

Generation: 1

Managed Fields:

API Version: snapshot.storage.k8s.io/v1beta1

Fields Type: FieldsV1

fieldsV1:

f:metadata:

f:finalizers:

v:"snapshot.storage.kubernetes.io/volumesnapshot-bound-protection":

Manager: snapshot-controller

Operation: Update

Time: 2020-07-27T21:49:13Z

Resource Version: 1642

Self Link: /apis/snapshot.storage.k8s.io/v1beta1/namespaces/default/volumesnapshots/new-snapshot-demo

UID: 41b224d8-9699-43bf-88f5-c65204b0f99a

Spec:

Source:

Persistent Volume Claim Name: csi-pvc

Volume Snapshot Class Name: csi-hostpath-snapclass

Status:

Bound Volume Snapshot Content Name: snapcontent-41b224d8-9699-43bf-88f5-c65204b0f99a

Ready To Use: false

Events: <none>kubectl get volumesnapshotcontent

NAME AGE

snapcontent-41b224d8-9699-43bf-88f5-c65204b0f99a 64skubectl describe volumesnapshotcontents

Name: snapcontent-41b224d8-9699-43bf-88f5-c65204b0f99a

Namespace:

Labels: <none>

Annotations: <none>

API Version: snapshot.storage.k8s.io/v1beta1

Kind: VolumeSnapshotContent

Metadata:

Creation Timestamp: 2020-07-27T21:49:13Z

Finalizers:

snapshot.storage.kubernetes.io/volumesnapshotcontent-bound-protection

Generation: 1

Managed Fields:

API Version: snapshot.storage.k8s.io/v1beta1

Fields Type: FieldsV1

fieldsV1:

f:metadata:

f:finalizers:

.:

v:"snapshot.storage.kubernetes.io/volumesnapshotcontent-bound-protection":

Manager: snapshot-controller

Operation: Update

Time: 2020-07-27T21:49:13Z

API Version: snapshot.storage.k8s.io/v1beta1

Fields Type: FieldsV1

fieldsV1:

f:status:

.:

f:creationTime:

f:readyToUse:

f:restoreSize:

f:snapshotHandle:

Manager: csi-snapshotter

Operation: Update

Time: 2020-07-27T21:50:00Z

Resource Version: 1777

Self Link: /apis/snapshot.storage.k8s.io/v1beta1/volumesnapshotcontents/snapcontent-41b224d8-9699-43bf-88f5-c65204b0f99a

UID: b120abb0-0470-4550-a900-dc1ac88405db

Spec:

Deletion Policy: Delete

Driver: hostpath.csi.k8s.io

Source:

Volume Handle: a4fc4a93-d052-11ea-8b8f-c22405f4a253

Volume Snapshot Class Name: csi-hostpath-snapclass

Volume Snapshot Ref:

API Version: snapshot.storage.k8s.io/v1beta1

Kind: VolumeSnapshot

Name: new-snapshot-demo

Namespace: default

Resource Version: 1636

UID: 41b224d8-9699-43bf-88f5-c65204b0f99a

Status:

Creation Time: 1595886600444714000

Ready To Use: true

Restore Size: 1073741824

Snapshot Handle: 1eb7cf15-d053-11ea-8b8f-c22405f4a253

Events: <none>Удалим pod, pvc и pv

kubectl delete -f ./hw/csi-app.yaml

pod "my-csi-app" deleted

kubectl delete -f ./hw/csi-pvc.yaml

persistentvolumeclaim "csi-pvc" deleted

kubectl get pvc

No resources found in default namespace.

kubectl get pv

No resources found in default namespace.Восстанавливаемся из snapshot

kubectl apply -f ./hw/csi-restore.yaml

persistentvolumeclaim/hpvc-restore createdПрименяем манифест пода

kubectl apply -f ./hw/csi-app.yaml

persistentvolumeclaim/hpvc-restore created

kubectl get pv

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

pvc-25dc08a9-8f0e-4748-92df-0dd39526cba7 1Gi RWO Delete Bound default/csi-pvc csi-hostpath-sc 4s

kubectl get pvc

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

csi-pvc Bound pvc-25dc08a9-8f0e-4748-92df-0dd39526cba7 1Gi RWO csi-hostpath-sc 5sПроверяем, что данные на месте

kubectl exec my-csi-app -- ls -la /data

total 8

drwxr-xr-x 2 root root 4096 Jul 27 22:00 .

drwxr-xr-x 1 root root 4096 Jul 27 22:00 ..

-rw-r--r-- 1 root root 0 Jul 27 21:48 hello-worldРазвертывание k8s-кластер, к которому добавляется хранилище на iSCSI и проверка работы snapshots | Задание со ⭐

Полезные ссылки:

https://github.com/kubernetes/examples/tree/master/volumes/iscsi

https://www.saqwel.ru/articles/linux/nastrojka-linux-iscsi-posredstvom-targetcli/

https://kifarunix.com/how-to-install-and-configure-iscsi-storage-server-on-ubuntu-18-04/

- На vm для iscsi хранилища добавляем дополнительный диск на 200Гб

- Добавляем второй сетевой интерфейс для трафика хранилища

Выключаем SELinux: disabled > /etc/sysconfig/selinux

Если не перезагрузились то: setenforce 0

Выключаем firewall

systemctl disable firewalld

systemctl stop firewalldУстанавливаем targetcli и targetd (рассмотрим в следующем разделе)

yum install -f targetcli targetdСделаем доступным демона (службу) target и запустить его

systemctl enable target

systemctl start targetСоздание physical volume

pvcreate /dev/sdb

Physical volume "/dev/sdb" successfully created.

pvdisplay

"/dev/sdb" is a new physical volume of "200.00 GiB"

--- NEW Physical volume ---

PV Name /dev/sdb

VG Name

PV Size 200.00 GiB

Allocatable NO

PE Size 0

Total PE 0

Free PE 0

Allocated PE 0

PV UUID DFvQro-J3FV-xMsW-gRqX-flHE-Gqne-hsdneMСоздаем volume group

vgcreate vg-targetd /dev/sdb

Volume group "vg-targetd" successfully created

vgdisplay

--- Volume group ---

VG Name vg-targetd

System ID

Format lvm2

Metadata Areas 1

Metadata Sequence No 1

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 0

Open LV 0

Max PV 0

Cur PV 1

Act PV 1

VG Size <200.00 GiB

PE Size 4.00 MiB

Total PE 51199

Alloc PE / Size 0 / 0

Free PE / Size 51199 / <200.00 GiB

VG UUID ZGVJ7J-DQ2N-SlTZ-O8mq-mTlA-6Arh-gQFG3a

vgs

VG #PV #LV #SN Attr VSize VFree

vg-targetd 1 0 0 wz--n- <200.00g <200.00gСоздаем logical volume

lvcreate -L1024 -n lv01 vg-targetd

Logical volume "lv01" created.

lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

lv01 vg-targetd -wi-a----- 1.00gНастраиваем iscsi target через targetcli

targetcli

targetcli shell version 2.1.fb49

Copyright 2011-2013 by Datera, Inc and others.

For help on commands, type 'help'.

/> ls

o- / ......................................................................................................................... [...]

o- backstores .............................................................................................................. [...]

| o- block .................................................................................................. [Storage Objects: 0]

| o- fileio ................................................................................................. [Storage Objects: 0]

| o- pscsi .................................................................................................. [Storage Objects: 0]

| o- ramdisk ................................................................................................ [Storage Objects: 0]

o- iscsi ............................................................................................................ [Targets: 0]

o- loopback ......................................................................................................... [Targets: 0]

/> /backstores/block create storage1 /dev/vg-targetd/lv01

Created block storage object storage1 using /dev/vg-targetd/lv01.

/> iscsi/ create iqn.2020-07.local.neclab:dev-storage-iscsi

Created target iqn.2020-07.local.neclab:dev-storage-iscsi.

Created TPG 1.

Global pref auto_add_default_portal=true

Created default portal listening on all IPs (0.0.0.0), port 3260.

/> /iscsi/iqn.2020-07.local.neclab:dev-storage-iscsi/tpg1/luns/ create /backstores/block/storage1

Created LUN 0.

/> /iscsi/iqn.2020-07.local.neclab:dev-storage-iscsi/tpg1/acls create iqn.2020-07.local.neclab:dev-worker1

Created Node ACL for iqn.2020-07.local.neclab:dev-worker1

Created mapped LUN 0.

/> /iscsi/iqn.2020-07.local.neclab:dev-storage-iscsi/tpg1/acls create iqn.2020-07.local.neclab:dev-worker2

Created Node ACL for iqn.2020-07.local.neclab:dev-worker2

Created mapped LUN 0.

/> /iscsi/iqn.2020-07.local.neclab:dev-storage-iscsi/tpg1/acls create iqn.2020-07.local.neclab:dev-worker3

Created Node ACL for iqn.2020-07.local.neclab:dev-worker3

Created mapped LUN 0.

/> /iscsi/iqn.2020-07.local.neclab:dev-storage-iscsi/tpg1/ set parameter AuthMethod=None

Parameter AuthMethod is now 'None'.

/> /iscsi/iqn.2020-07.local.neclab:dev-storage-iscsi/tpg1/ set attribute authentication=0

Parameter authentication is now '0'.

/> ls

o- / ......................................................................................................................... [...]

o- backstores .............................................................................................................. [...]

| o- block .................................................................................................. [Storage Objects: 1]

| | o- storage1 ............................................................. [/dev/vg-targetd/lv01 (1.0GiB) write-thru activated]

| | o- alua ................................................................................................... [ALUA Groups: 1]

| | o- default_tg_pt_gp ....................................................................... [ALUA state: Active/optimized]

| o- fileio ................................................................................................. [Storage Objects: 0]

| o- pscsi .................................................................................................. [Storage Objects: 0]

| o- ramdisk ................................................................................................ [Storage Objects: 0]

o- iscsi ............................................................................................................ [Targets: 1]

| o- iqn.2020-07.local.neclab:dev-storage-iscsi ........................................................................ [TPGs: 1]

| o- tpg1 ............................................................................................... [no-gen-acls, no-auth]

| o- acls .......................................................................................................... [ACLs: 3]

| | o- iqn.2020-07.local.neclab:dev-worker1 ................................................................. [Mapped LUNs: 1]

| | | o- mapped_lun0 .............................................................................. [lun0 block/storage1 (rw)]

| | o- iqn.2020-07.local.neclab:dev-worker2 ................................................................. [Mapped LUNs: 1]

| | | o- mapped_lun0 .............................................................................. [lun0 block/storage1 (rw)]

| | o- iqn.2020-07.local.neclab:dev-worker3 ................................................................. [Mapped LUNs: 1]

| | o- mapped_lun0 .............................................................................. [lun0 block/storage1 (rw)]

| o- luns .......................................................................................................... [LUNs: 1]

| | o- lun0 ....................................................... [block/storage1 (/dev/vg-targetd/lv01) (default_tg_pt_gp)]

| o- portals .................................................................................................... [Portals: 1]

| o- 0.0.0.0:3260 ..................................................................................................... [OK]

o- loopback ......................................................................................................... [Targets: 0]

/>- Добавляем второй сетевой интерфейс для трафика хранилища на каждую воркер ноду

Устанавливаем iscsi инициатор

apt install -y open-iscsi

Редактируем /etc/iscsi/initiatorname.iscsi

```console

InitiatorName=iqn.2020-07.local.neclab:dev-workerNгде N - порядковый номер ноды

Перезапускаем iscsid и open-iscsi

systemctl restart iscsid open-iscsi

systemctl enable iscsid open-iscsiПроверяем подключение к iscsi хранилищу

iscsiadm -m discovery -t sendtargets -p 192.2.1.21

192.2.1.21:3260,1 iqn.2020-07.local.neclab:dev-storage-iscsi

iscsiadm -m node --login

Logging in to [iface: default, target: iqn.2020-07.local.neclab:dev-storage-iscsi, portal: 192.2.1.21,3260] (multiple)

Login to [iface: default, target: iqn.2020-07.local.neclab:dev-storage-iscsi, portal: 192.2.1.21,3260] successful.

iscsiadm -m node --logout

Logging out of session [sid: 9, target: iqn.2020-07.local.neclab:dev-storage-iscsi, portal: 192.2.1.21,3260]

Logout of [sid: 9, target: iqn.2020-07.local.neclab:dev-storage-iscsi, portal: 192.2.1.21,3260] successful.Применяем манифесты создания pv, pvc и pod

kubectl apply -f nginx-pv.yaml -f nginx-pvc.yaml -f nginx.yaml

persistentvolume/iscsi-pv created

persistentvolumeclaim/myclaim created

pod/iscsi-pv-pod1 createdkubectl get pvc

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

myclaim Bound iscsi-pv 1Gi RWO 2s

iscsi kubectl get pv

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

iscsi-pv 1Gi RWO Retain Bound default/myclaim 2m30s

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

iscsi-pv-pod1 1/1 Running 0 21s 192.168.184.72 dev-worker2 <none> <none>Записываем данные в наш volume

kubectl exec -it iscsi-pv-pod1 /bin/sh

/ # ls -la /var/lib/busybox/

total 24

drwxr-xr-x 3 root root 4096 Jul 26 12:33 .

drwxr-xr-x 3 root root 4096 Jul 26 12:33 ..

drwx------ 2 root root 16384 Jul 26 12:33 lost+found

/ # echo Hello! > /var/lib/busybox/text.txt

/ # ls -la /var/lib/busybox/

total 28

drwxr-xr-x 3 root root 4096 Jul 26 12:34 .

drwxr-xr-x 3 root root 4096 Jul 26 12:33 ..

drwx------ 2 root root 16384 Jul 26 12:33 lost+found

-rw-r--r-- 1 root root 7 Jul 26 12:34 text.txtИдем на хранилище и создаем snapshot

lvcreate -L 500MB -s -n sn01 /dev/vg-targetd/lv01

Rounding up size to full physical extent 12.00 MiB

Logical volume "sn01" created.В volume пода удаляем данные

kubectl exec -it iscsi-pv-pod1 /bin/sh

/ # ls -la /var/lib/busybox/

total 28

drwxr-xr-x 3 root root 4096 Jul 26 12:34 .

drwxr-xr-x 3 root root 4096 Jul 26 12:33 ..

drwx------ 2 root root 16384 Jul 26 12:33 lost+found

-rw-r--r-- 1 root root 7 Jul 26 12:34 text.txt

/ # rm /var/lib/busybox/text.txt

/ # ls -la /var/lib/busybox/

total 24

drwxr-xr-x 3 root root 4096 Jul 26 12:36 .

drwxr-xr-x 3 root root 4096 Jul 26 12:33 ..

drwx------ 2 root root 16384 Jul 26 12:33 lost+foundУдаляем наши pv, pvc, pod

kubectl delete pod iscsi-pv-pod1

pod "iscsi-pv-pod1" deleted

kubectl delete pvc myclaim

persistentvolumeclaim "myclaim" deleted

iscsi kubectl delete pv iscsi-pv

persistentvolume "iscsi-pv" deleted

kubectl get pv

No resources found in default namespace.

iscsi kubectl get pvc

No resources found in default namespace.На хранилище останавливаем сервис target (в противном случаем snapshot не смержить)

systemctl stop target

lvconvert --merge /dev/vg-targetd/sn01

Merging of volume vg-targetd/sn01 started.

vg-targetd/lv01: Merged: 100.00%Снова стартуем сервис

systemctl start targetСнова применяем манифесты

kubectl apply -f nginx-pv.yaml -f nginx-pvc.yaml -f nginx.yaml

persistentvolume/iscsi-pv created

persistentvolumeclaim/myclaim created

pod/iscsi-pv-pod1 created

kubectl get pv,pvc,pod

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

persistentvolume/iscsi-pv 1Gi RWO Retain Bound default/myclaim 98s

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

persistentvolumeclaim/myclaim Bound iscsi-pv 1Gi RWO 98s

NAME READY STATUS RESTARTS AGE

pod/iscsi-pv-pod1 1/1 Running 0 97sПроверяем, что данные из snapshot успешно восстановились

kubectl exec -it iscsi-pv-pod1 /bin/sh

/ # ls -la /var/lib/busybox/

lost+found/ text.txt

/ # ls -la /var/lib/busybox/text.txt

-rw-r--r-- 1 root root 7 Jul 26 13:03 /var/lib/busybox/text.txt

/ # cat /var/lib/busybox/text.txt

Hello!Полезные ссылки:

https://github.com/kubernetes-incubator/external-storage/tree/master/iscsi/targetd

https://ansilh.com/17-persistent_volumes/02-iscsi-provisioner/

- volume group берем из предыдущего раздела описания

- удаляем старые lv

Настраиваем targetd

/etc/target/targetd.yaml

user: admin

password: password

pool_name: vg-targetd

ssl: false

target_name: iqn.2020-07.local.neclab:dev-storage-iscsiПерезапускаем сервис

systemctl start targetd

systemctl enable targetd

systemctl status targetd

● targetd.service - targetd storage array API daemon

Loaded: loaded (/usr/lib/systemd/system/targetd.service; enabled; vendor preset: disabled)

Active: active (running) since Sun 2020-07-26 16:44:21 MSK; 22h ago

Main PID: 4924 (targetd)

CGroup: /system.slice/targetd.service

└─4924 targetd

Jul 26 16:44:21 dev-storage-iscsi systemd[1]: Started targetd storage array API daemon.

Jul 26 16:44:27 dev-storage-iscsi targetd[4924]: INFO:root:started server (TLS no)Создаем ns для провижинера

kubectl create ns iscsi-provisioner

namespace/iscsi-provisioner createdСоздаем секрет для подключения к targetd

kubectl create secret generic targetd-account --from-literal=username=admin --from-literal=password=password -n iscsi-provisionerПрименяем манифесты провижинера

kubectl apply -f iscsi-provisioner-d.yaml -n iscsi-provisioner

clusterrole.rbac.authorization.k8s.io/iscsi-provisioner-runner created

clusterrolebinding.rbac.authorization.k8s.io/run-iscsi-provisioner created

serviceaccount/iscsi-provisioner created

deployment.apps/iscsi-provisioner created

kubectl get pods -n iscsi-provisioner

NAME READY STATUS RESTARTS AGE

iscsi-provisioner-6b58bd885-wdqtw 1/1 Running 0 34s

kubectl apply -f iscsi-provisioner-class.yaml -n iscsi-provisioner

storageclass.storage.k8s.io/iscsi-targetd-vg-targetd createdПрименяем манифесты нашего приложения

kubectl apply -f nginx-pvc.yaml

persistentvolumeclaim/myclaim created

kubectl apply -f nginx.yaml

pod/iscsi-pv-pod1 createdПроверяем, что pv и pvc в статусе bound

kubectl get pv

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb 100Mi RWO Delete Bound default/myclaim iscsi-targetd-vg-targetd 25s

kubectl get pvc

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

myclaim Bound pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb 100Mi RWO iscsi-targetd-vg-targetd 62s

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

iscsi-pv-pod1 1/1 Running 0 40s 192.168.41.206 dev-worker1 <none> <none>Идем на vm iscsi хранилища и проверяем там

lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb vg-targetd -wi-ao---- 100.00m

targetcli

targetcli shell version 2.1.fb49

Copyright 2011-2013 by Datera, Inc and others.

For help on commands, type 'help'.

/> ls

o- / ......................................................................................................................... [...]

o- backstores .............................................................................................................. [...]

| o- block .................................................................................................. [Storage Objects: 1]

| | o- vg-targetd:pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb [/dev/vg-targetd/pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb (100.0MiB) write-thru activated]

| | o- alua ................................................................................................... [ALUA Groups: 1]

| | o- default_tg_pt_gp ....................................................................... [ALUA state: Active/optimized]

| o- fileio ................................................................................................. [Storage Objects: 0]

| o- pscsi .................................................................................................. [Storage Objects: 0]

| o- ramdisk ................................................................................................ [Storage Objects: 0]

o- iscsi ............................................................................................................ [Targets: 1]

| o- iqn.2020-07.local.neclab:dev-storage-iscsi ........................................................................ [TPGs: 1]

| o- tpg1 ............................................................................................... [no-gen-acls, no-auth]

| o- acls .......................................................................................................... [ACLs: 3]

| | o- iqn.2020-07.local.neclab:dev-worker1 ................................................................. [Mapped LUNs: 1]

| | | o- mapped_lun0 ................................... [lun0 block/vg-targetd:pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb (rw)]

| | o- iqn.2020-07.local.neclab:dev-worker2 ................................................................. [Mapped LUNs: 1]

| | | o- mapped_lun0 ................................... [lun0 block/vg-targetd:pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb (rw)]

| | o- iqn.2020-07.local.neclab:dev-worker3 ................................................................. [Mapped LUNs: 1]

| | o- mapped_lun0 ................................... [lun0 block/vg-targetd:pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb (rw)]

| o- luns .......................................................................................................... [LUNs: 1]

| | o- lun0 [block/vg-targetd:pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb (/dev/vg-targetd/pvc-24701fd6-70b3-40b3-9cf4-e2e1f5936cfb) (default_tg_pt_gp)]

| o- portals .................................................................................................... [Portals: 1]

| o- 0.0.0.0:3260 ..................................................................................................... [OK]

o- loopback ......................................................................................................... [Targets: 0]

/>В качестве хранилища кода и CI-системы в домашнем задании мы будем использовать SaaS GitLab. Зарегистрируемся там и создадим GitLab публичный проект microservicesdemo.

Переместим в проект microservices-demo код из GitHub репозитория:

git clone https://github.com/GoogleCloudPlatform/microservices-demo

cd microservices-demo

git remote add gitlab git@gitlab.com:kovtalex/microservices-demo.git

git remote remove originПредварительно необходимо добавить публичный ssh ключ в профиль GitLab, либо использовать https

- Перед началом выполнения домашнего задания необходимо подготовить Helm чарты для каждого микросервиса

- Можно воспользоваться наработками из предыдущих домашних заданий, либо скопировать готовые чарты из демонстрационного репозитория (директория deploy/charts)

- Во всех манифестах, описывающих deployment, обязательно должны быть параметризованы название образа и его тег. Рекомендуется придерживаться следующего формата:

Результат поместим в директорию deploy/charts. Должен получиться следующий вывод:

tree -L 1 deploy/charts

deploy/charts

├── adservice

├── cartservice

├── checkoutservice

├── currencyservice

├── emailservice

├── frontend

├── loadgenerator

├── paymentservice

├── productcatalogservice

├── recommendationservice

└── shippingservice- Развернем managed Kubernetes кластер в GCP размером 4 ноды типа n1-standard-2

- Установим istio как GKE аддон

gcloud container clusters get-credentials cluster-1 --zone europe-west1-b --project angular-pursuit-275120

Fetching cluster endpoint and auth data.

kubeconfig entry generated for cluster-1.gcloud container clusters list

NAME LOCATION MASTER_VERSION MASTER_IP MACHINE_TYPE NODE_VERSION NUM_NODES STATUS

cluster-1 europe-west1-b 1.16.9-gke.6 35.189.206.79 n1-standard-2 1.16.9-gke.6 4 RUNNINGgcloud beta container clusters update cluster-1 \

--update-addons=Istio=ENABLED --istio-config=auth=MTLS_PERMISSIVE --region=europe-west1-b

Updating cluster-1...done.

Updated [https://container.googleapis.com/v1beta1/projects/angular-pursuit-275120/zones/europe-west1-b/clusters/cluster-1].

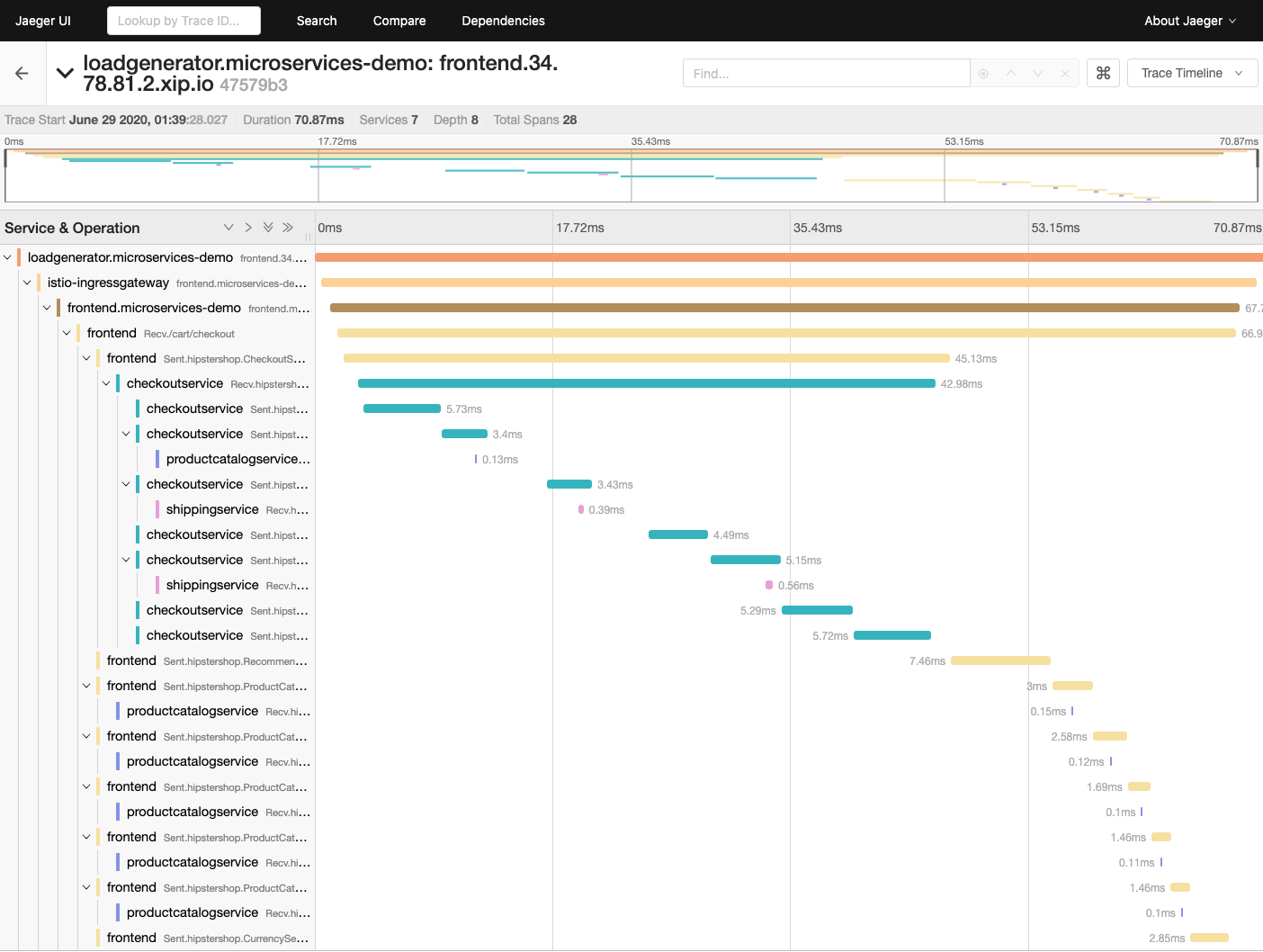

To inspect the contents of your cluster, go to: https://console.cloud.google.com/kubernetes/workload_/gcloud/europe-west1-b/cluster-1?project=angular-pursuit-275120kubectl get service -n istio-system

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

istio-citadel ClusterIP 10.0.3.16 <none> 8060/TCP,15014/TCP 60s

istio-galley ClusterIP 10.0.13.196 <none> 443/TCP,15014/TCP,9901/TCP 60s

istio-ingressgateway LoadBalancer 10.0.5.79 34.78.81.2 15020:31158/TCP,80:30366/TCP,443:30126/TCP,31400:30279/TCP,15029:31001/TCP,15030:31300/TCP,15031:31993/TCP,15032:31534/TCP,15443:30087/TCP 59s

istio-pilot ClusterIP 10.0.9.184 <none> 15010/TCP,15011/TCP,8080/TCP,15014/TCP 59s

istio-policy ClusterIP 10.0.13.162 <none> 9091/TCP,15004/TCP,15014/TCP 59s

istio-sidecar-injector ClusterIP 10.0.6.145 <none> 443/TCP,15014/TCP 59s

istio-telemetry ClusterIP 10.0.14.197 <none> 9091/TCP,15004/TCP,15014/TCP,42422/TCP 59s

promsd ClusterIP 10.0.2.124 <none> 9090/TCP

kubectl get pods -n istio-system

NAME READY STATUS RESTARTS AGE

istio-citadel-bc69f964d-p9m8p 1/1 Running 0 5m32s

istio-galley-57d74676f6-nk4vr 1/1 Running 0 5m32s

istio-ingressgateway-6855988795-6cv2m 0/1 Running 0 5m32s

istio-pilot-b6866b4d9-c4c9g 2/2 Running 1 5m31s

istio-policy-698f74bc98-xjsn7 2/2 Running 3 5m31s

istio-security-post-install-1.4.6-gke.0-w95m9 0/1 Completed 0 5m29s

istio-sidecar-injector-d5485f495-qxth5 1/1 Running 0 5m30s

istio-telemetry-58769bf595-t5sw6 2/2 Running 2 5m30s

promsd-696bcc5b96-tm44r 2/2 Running 1 5m29s- Автоматизировано создание Kubernetes кластера

- Кластер разворачиваться после запуска pipeline в GitLab для окружения dev и prod

Cсылка: https://gitlab.com/kovtalex-repo/microservices-demo/base-layer

- Соберем Docker образы для всех микросервиса и поместим данные образы в Docker Hub

- При тегировании образов используем подход semver, например, первому собранному образу логично выставить тег v0.0.1

После выполнения данного шага в Docker Hub должно находиться как минимум по одному образу для каждого микросервиса

Напишем Makefile и исполним:

make

make releaseПодготовлен простой pipeline, который состоит из стадии сборки Docker образа для каждого из микросервисов и Push данного образа в Docker Hub.

В качестве тега образа используется tag коммита, инициирующего сборку (переменная CI_COMMIT_TAG в GitLab CI)

Предварительно требуется прописать следующие переменные окружения в Gitlab:

- CI_REGISTRY_USER - Docker ID

- CI_TOKEN - Docker token

https://gitlab.com/kovtalex/microservices-demo

- Добавим официальный репозиторий Flux

helm repo add fluxcd https://charts.fluxcd.io

"fluxcd" has been added to your repositories- Произведем установку Flux в кластер, в namespace flux

helm upgrade --install flux fluxcd/flux -f flux.values.yaml --namespace flux --create-namespace

Release "flux" does not exist. Installing it now.

NAME: flux

LAST DEPLOYED: Fri Jun 26 02:55:36 2020

NAMESPACE: flux

STATUS: deployed

REVISION: 1

TEST SUITE: None

NOTES:

Get the Git deploy key by either (a) running

kubectl -n flux logs deployment/flux | grep identity.pub | cut -d '"' -f2

or by (b) installing fluxctl through

https://docs.fluxcd.io/en/latest/references/fluxctl#installing-fluxctl

and running:

fluxctl identity --k8s-fwd-ns flux- Установим Helm operator:

flux.values.yaml

git:

url: git@gitlab.com:kovtalex/microservices-demo.git

path: deploy

ciSkip: true

pollInterval: 1m

registry:

automationInterval: 1mhelm upgrade --install helm-operator fluxcd/helm-operator -f helm-operator.values.yaml --namespace flux

Release "helm-operator" does not exist. Installing it now.

NAME: helm-operator

LAST DEPLOYED: Fri Jun 26 02:57:24 2020

NAMESPACE: flux

STATUS: deployed

REVISION: 1

TEST SUITE: None

NOTES:

Flux Helm Operator docs https://docs.fluxcd.io

Example:

AUTH_VALUES=$(cat <<-END

usePassword: true

password: "redis_pass"

usePasswordFile: true

END

)

kubectl create secret generic redis-auth --from-literal=values.yaml="$AUTH_VALUES"

cat <<EOF | kubectl apply -f -

apiVersion: helm.fluxcd.io/v1

kind: HelmRelease

metadata:

name: redis

namespace: default

spec:

releaseName: redis

chart:

repository: https://kubernetes-charts.storage.googleapis.com

name: redis

version: 10.5.7

valuesFrom:

- secretKeyRef:

name: redis-auth

values:

master:

persistence:

enabled: false

volumePermissions:

enabled: true

metrics:

enabled: true

cluster:

enabled: false

EOF

watch kubectl get hrИспользуем values из следующего файла

- Установим fluxctl на локальную машину для управления нашим CD инструментом. Руководство по установке достуно по ссылке

brew install fluxctl

export FLUX_FORWARD_NAMESPACE=flux- Наконец, добавим в свой профиль GitLab публичный ssh-ключ, при помощи которого flux получит доступ к нашему git-репозиторию

Получить значение ключа можно следующей командой: fluxctl identity --k8s-fwd-ns flux

Пришло время проверить корректность работы Flux. Как мы уже знаем, Flux умеет автоматически синхронизировать состояние кластера и репозитория. Это касается не только сущностей HelmRelease, которыми мы будем оперировать для развертывания приложения, но и обыкновенных манифестов.

Поместим манифест, описывающий namespace microservices-demo в директорию deploy/namespaces и сделаем push в GitLab:

apiVersion: v1

kind: Namespace

metadata:

name: microservices-demoЕсли все предыдущие шаги проделаны верно - в кластере через некоторое время будет создан namespace microservices-demo

kubectl get ns

NAME STATUS AGE

default Active 133m

flux Active 16m

istio-system Active 120m

kube-node-lease Active 134m

kube-public Active 134m

kube-system Active 134m

microservices-demo Active 14sТакже в логах pod с flux должна появиться строка, описывающая действия данного инструмента

kubectl logs flux-85bfb4df69-wdwnz -n flux | grep "kubectl apply -f"

ts=2020-06-26T00:11:46.205972915Z caller=sync.go:605 method=Sync cmd="kubectl apply -f -" took=640.185151ms err=null output="namespace/microservices-demo created"Мы подобрались к сущностям, которыми управляет helm-operator - HelmRelease.

Для описания сущностей такого вида создадим отдельную директорию deploy/releases и поместим туда файл frontend.yaml с описанием конфигурации релиза.

---

apiVersion: helm.fluxcd.io/v1

kind: HelmRelease

metadata:

name: frontend

namespace: microservices-demo

annotations:

fluxcd.io/ignore: "false"

fluxcd.io/automated: "true"

flux.weave.works/tag.chart-image: semver:~v0.0

spec:

releaseName: frontend

helmVersion: v3

chart:

git: git@gitlab.com:kovtalex/microservices-demo.git

ref: master

path: deploy/charts/frontend

values:

image:

repository: kovtalex/frontend

tag: v0.0.1Не забудем сделать push в GitLab после добавления манифеста

Опишем некоторые части манифеста HelmRelease:

- fluxcd.io/automated: "true" # 1 - Аннотация разрешает автоматическое обновление релиза в Kubernetes кластере в случае изменения версии Docker образа в Registry

- flux.weave.works/tag.chart-image: semver:~v0.0 - Указываем Flux следить за обновлениями конкретных Docker образов в Registry. Новыми считаются только образы, имеющие версию выше текущей и отвечающие маске семантического версионирования ~0.0 (например, 0.0.1, 0.0.72, но не 1.0.0)

- chart: - Helm chart, используемый для развертывания релиза. В нашем случае указываем git-репозиторий, и директорию с чартом внутри него

- values: - Переопределяем переменные Helm chart. В дальнейшем Flux может сам переписывать эти значения и делать commit в git-репозиторий (например, изменять тег Docker образа при его обновлении в Registry)

Более подробное описание доступно по ссылке

Убедимся что HelmRelease для микросервиса frontend появился в кластере:

kubectl get helmrelease -n microservices-demo

NAME RELEASE PHASE STATUS MESSAGE AGE

frontend frontend Succeeded deployed Release was successful for Helm release 'frontend' in 'microservices-demo'. 9hПо статусу мы можем понять, что релиз применился успешно, и frontend запущен. Дополнительно проверим это:

helm list -n microservices-demo

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION

frontend microservices-demo 1 2020-06-26 10:21:59.949005778 +0000 UTC deployed frontend-0.21.0 1.16.0Командой fluxctl --k8s-fwd-ns flux sync можно инициировать синхронизацию вручную

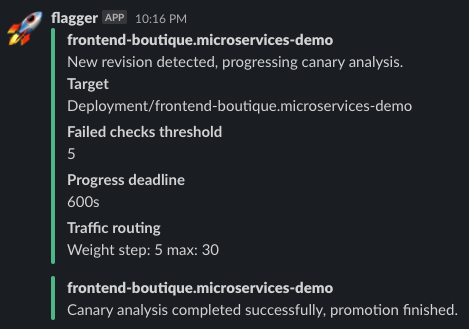

- Внесем изменения в исходный код микросервиса frontend (не имеет значения, какие) и пересоберем образ, при этом инкрементировав версию тега (до v0.0.2)

- Дождемся автоматического обновления релиза в Kubernetes кластере (для просмотра ревизий релиза можно использовать команду helm history frontend -n microservices-demo)

- Проверим, изменилось ли что-либо в git-репозитории (в частности, в файле deploy/releases/frontend.yaml)

make -n APP_TAG=v0.0.2 build_frontend release_frontend

export USER_NAME=kovtalex && cd microservices-demo/src/frontend && docker build -t kovtalex/frontend:v0.0.2 .

docker push kovtalex/frontend:v0.0.2

make APP_TAG=v0.0.2 build_frontend release_frontendhelm history frontend -n microservices-demo

REVISION UPDATED STATUS CHART APP VERSION DESCRIPTION

1 Fri Jun 26 10:21:59 2020 superseded frontend-0.21.0 1.16.0 Install complete

2 Fri Jun 26 10:38:00 2020 deployed frontend-0.21.0 1.16.0 Upgrade completeТег изменился на: v0.0.2:

---

apiVersion: helm.fluxcd.io/v1

kind: HelmRelease

metadata:

name: frontend

namespace: microservices-demo

annotations:

fluxcd.io/ignore: "false"

fluxcd.io/automated: "true"

flux.weave.works/tag.chart-image: semver:~v0.0

spec:

releaseName: frontend

helmVersion: v3

chart:

git: git@gitlab.com:kovtalex/microservices-demo.git

ref: master

path: deploy/charts/frontend

values:

image:

repository: kovtalex/frontend

tag: v0.0.2- Попробуем внести изменения в Helm chart frontend и поменять имя deployment на frontend-boutique

- Сделаем push измененного Helm chart в GitLab и понаблюдаем за процессом

- Найдем в логах helm-operator строки, указывающие на механизм проверки изменений в Helm chart и определения необходимости обновить релиз. Приложим данные строки к описанию PR.

kubectl logs helm-operator-745586d945-9xfvw -n flux

ts=2020-06-26T10:43:36.731329725Z caller=helm.go:69 component=helm version=v3 info="preparing upgrade for frontend" targetNamespace=microservices-demo release=frontend

ts=2020-06-26T10:43:36.735540145Z caller=helm.go:69 component=helm version=v3 info="resetting values to the chart's original version" targetNamespace=microservices-demo release=frontend

ts=2020-06-26T10:43:37.212661611Z caller=helm.go:69 component=helm version=v3 info="performing update for frontend" targetNamespace=microservices-demo release=frontend

ts=2020-06-26T10:43:37.222554135Z caller=helm.go:69 component=helm version=v3 info="dry run for frontend" targetNamespace=microservices-demo release=frontend

ts=2020-06-26T10:43:37.234971971Z caller=release.go:273 component=release release=frontend targetNamespace=microservices-demo resource=microservices-demo:helmrelease/frontend helmVersion=v3 info="no changes" phase=dry-run-compare

ts=2020-06-26T10:44:28.24689266Z caller=release.go:75 component=release release=frontend targetNamespace=microservices-demo resource=microservices-demo:helmrelease/frontend helmVersion=v3 info="starting sync run"