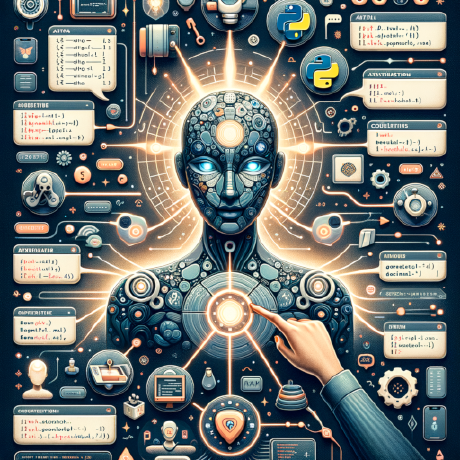

Auto-GPT est une application open-source expérimentale mettant en valeur les capacités du modèle de langage GPT-4. Ce programme, piloté par GPT-4, relie les "pensées" LLM pour atteindre de manière autonome l'objectif que vous avez défini. En tant que l'un des premiers exemples de GPT-4 fonctionnant en totale autonomie, Auto-GPT repousse les limites de ce qui est possible avec l'IA.

Development of this free, open-source project is made possible by all the contributors and sponsors. If you'd like to sponsor this project and have your avatar or company logo appear below click here.

- Auto-GPT : une expérience autonome GPT-4

- Démonstration (30/03/2023) :

- 💖 Aidez à financer le développement d'Auto-GPT

- Table des matières

- 🚀 Fonctionnalités

- 📋 Exigences

- 💾 Installation

- 🔧 Utilisation

- 🗣️ Mode vocal

- 🔍 Configuration des clés API Google

- 💀 Mode continu

⚠️ - Mode GPT3.5 UNIQUEMENT

- 🖼 Génération d'images

⚠️ Limitations- 🛡 Avertissement

- 🐦 Connectez-vous avec nous sur Twitter

🌐 Accès à Internet pour les recherches et la collecte d'informations 💾 Gestion de la mémoire à court et long terme 🧠 Instances GPT-4 pour la génération de texte 🔗 Accès aux sites Web et plateformes populaires 🗃️ Stockage de fichiers et résumé avec GPT-3.5 📋 Exigences Python 3.8 ou ultérieur Clé API OpenAI Clé API PINECONE Optionnel :

Clé ElevenLabs (si vous voulez que l'IA parle)

Pour installer Auto-GPT, suivez ces étapes :

Assurez-vous d'avoir toutes les exigences ci-dessus, sinon, installez/obtenez-les. Les commandes suivantes doivent être exécutées dans une fenêtre CMD, Bash ou Powershell. Pour ce faire, allez dans un dossier de votre ordinateur, cliquez sur le chemin du dossier en haut et tapez CMD, puis appuyez sur Entrée.

- Clonez le dépôt : Pour cette étape, vous avez besoin de Git installé, mais vous pouvez simplement télécharger le fichier zip à la place en cliquant sur le bouton en haut de cette page ☝️

git clone https://github.com/mikiane/AutoGPT-FR

- Accédez au répertoire du projet : (Tapez ceci dans votre fenêtre CMD, votre objectif est de naviguer dans la fenêtre CMD vers le dépôt que vous venez de télécharger)

cd 'Auto-GPT-FR'

- Installez les dépendances requises : (Là encore, tapez ceci dans votre fenêtre CMD)

pip install -r requirements.txt

- Renommez .env.template en .env et remplissez votre OPENAI_API_KEY. Si vous prévoyez d'utiliser le mode Speech, remplissez également votre ELEVEN_LABS_API_KEY. Obtenez votre clé API OpenAI depuis : https://platform.openai.com/account/api-keys. Obtenez votre clé API ElevenLabs depuis : https://elevenlabs.io. Vous pouvez consulter votre xi-api-key en utilisant l'onglet "Profil" sur le site. Si vous souhaitez utiliser GPT sur une instance Azure, définissez USE_AZURE sur True et ensuite : Renommez azure.yaml.template en azure.yaml et fournissez le azure_api_base, azure_api_version et tous les identifiants de déploiement pour les modèles pertinents dans la section azure_model_map : fast_llm_model_deployment_id - votre identifiant de déploiement gpt-3.5-turbo ou gpt-4 smart_llm_model_deployment_id - votre identifiant de déploiement gpt-4 embedding_model_deployment_id - votre identifiant de déploiement text-embedding-ada-002 v2 Veuillez spécifier toutes ces valeurs en tant que chaînes de caractères entre guillemets doubles Les détails se trouvent ici : https://pypi.org/project/openai/ dans la section Microsoft Azure Endpoints et ici : https://learn.microsoft.com/en-us/azure/cognitive-services/openai/tutorials/embeddings?tabs=command-line pour le modèle d'embedding.

- Exécutez le script Python

main.pydans votre terminal : (Tapez ceci dans votre fenêtre CMD)

python scripts/main.py

- Après chaque action d'AUTO-GPT, tapez "NEXT COMMAND" pour l'autoriser à continuer.

- Pour quitter le programme, tapez "exit" et appuyez sur Entrée.

Vous trouverez les journaux d'activité et d'erreur dans le dossier ./logs

Pour produire des journaux de débogage :

python scripts/main.py --debug

Utilisez cette option pour utiliser le TTS pour l'Auto-GPT.

python scripts/main.py --speak

Cette section est optionnelle, utilisez l'API officielle de Google si vous avez des problèmes avec l'erreur 429 lors d'une recherche Google.

Pour utiliser la commande google_official_search, vous devez configurer vos clés API Google dans vos variables d'environnement.

- Allez dans la [Google Cloud Console] (https://console.cloud.google.com/).

- Si vous n'avez pas encore de compte, créez-en un et connectez-vous.

- Créez un nouveau projet en cliquant sur le menu déroulant "Select a Project" en haut de la page et en cliquant sur "New Project". Donnez-lui un nom et cliquez sur "Créer".

- Allez sur le [tableau de bord APIs & Services] (https://console.cloud.google.com/apis/dashboard) et cliquez sur "Enable APIs and Services" (Activer les APIs et les services). Recherchez "Custom Search API" et cliquez dessus, puis cliquez sur "Enable".

- Allez sur la page Credentials et cliquez sur "Create Credentials". Choisissez "API Key".

- Copiez la clé API et définissez-la comme une variable d'environnement nommée

GOOGLE_API_KEYsur votre machine. Voir la configuration des variables d'environnement ci-dessous. - Allez sur la page [Moteur de recherche personnalisé] (https://cse.google.com/cse/all) et cliquez sur "Ajouter".

- Configurez votre moteur de recherche en suivant les instructions. Vous pouvez choisir d'effectuer une recherche sur l'ensemble du web ou sur des sites spécifiques.

- Une fois que vous avez créé votre moteur de recherche, cliquez sur "Panneau de configuration", puis sur "Bases". Copiez l'"ID du moteur de recherche" et définissez-le comme une variable d'environnement nommée

CUSTOM_SEARCH_ENGINE_IDsur votre machine. Voir la configuration des variables d'environnement ci-dessous.

N'oubliez pas que votre quota quotidien gratuit de recherches personnalisées est limité à 100 recherches. Pour augmenter cette limite, vous devez assigner un compte de facturation au projet afin de bénéficier d'un maximum de 10K recherches quotidiennes.

Pour les utilisateurs de Windows :

setx GOOGLE_API_KEY "YOUR_GOOGLE_API_KEY"

setx CUSTOM_SEARCH_ENGINE_ID "YOUR_CUSTOM_SEARCH_ENGINE_ID"

Pour les utilisateurs macOS & Linux :

export GOOGLE_API_KEY="YOUR_GOOGLE_API_KEY"

export CUSTOM_SEARCH_ENGINE_ID="YOUR_CUSTOM_SEARCH_ENGINE_ID"

Installer docker desktop.

Exécutez :

docker run -d --name redis-stack-server -p 6379:6379 redis/redis-stack-server:latest

Voir https://hub.docker.com/r/redis/redis-stack-server pour la définition d'un mot de passe et d'autres configurations.

Définissez les variables d'environnement suivantes :

MEMORY_BACKEND=redis

REDIS_HOST=localhost

REDIS_PORT=6379

REDIS_PASSWORD=

Notez que ceci n'est pas destiné à être exécuté face à l'internet et n'est pas sécurisé, n'exposez pas redis à l'internet sans mot de passe ou même vraiment sans mot de passe.

Vous pouvez optionnellement définir

WIPE_REDIS_ON_START=False

Pour conserver la mémoire stockée dans Redis.

Vous pouvez spécifier l'indice de mémoire pour Redis en procédant comme suit :

MEMORY_INDEX=whatever

Pinecone permet de stocker de grandes quantités de mémoire vectorielle, ce qui permet de charger uniquement les mémoires pertinentes pour l'agent à un moment donné.

- Allez sur pinecone et créez un compte si vous n'en avez pas déjà un.

- Choisissez le plan

Starterpour éviter d'être facturé. - Trouvez votre clé API et votre région sous le projet par défaut dans la barre latérale gauche.

Il suffit de les définir dans le fichier .env.

Vous pouvez également les définir à partir de la ligne de commande (avancé) :

Pour les utilisateurs de Windows :

setx PINECONE_API_KEY "VOTRE_PINECONE_API_KEY"

setx PINECONE_ENV "Votre région de pommes de pin" # quelque chose comme : us-east4-gcp

Pour les utilisateurs de macOS et de Linux :

export PINECONE_API_KEY="YOUR_PINECONE_API_KEY"

export PINECONE_ENV="Votre région de pommes de pin" # quelque chose comme : us-east4-gcp

Par défaut, Auto-GPT va utiliser LocalCache au lieu de redis ou Pinecone.

Pour passer à l'un ou l'autre, changez la variable env MEMORY_BACKEND à la valeur que vous voulez :

local (par défaut) utilise un fichier de cache JSON local

pinecone utilise le compte Pinecone.io que vous avez configuré dans vos paramètres ENV

redis utilisera le cache redis que vous avez configuré

- Voir l'utilisation de la mémoire en utilisant le drapeau

--debug:)

Exécuter l'IA sans l'autorisation de l'utilisateur, 100% automatisé. Le mode continu n'est pas recommandé. Il est potentiellement dangereux et peut faire tourner votre IA à l'infini ou effectuer des actions que vous n'autoriseriez pas habituellement. Utilisez-le à vos risques et périls.

- Lancez le script Python

main.pydans votre terminal :

python scripts/main.py --continuous

- Pour quitter le programme, appuyez sur Ctrl + C

Si vous n'avez pas accès à l'api GPT4, ce mode vous permettra d'utiliser Auto-GPT !

python scripts/main.py --gpt3only

Il est recommandé d'utiliser une machine virtuelle pour les tâches qui nécessitent des mesures de sécurité élevées afin d'éviter tout dommage potentiel au système et aux données de l'ordinateur principal.

By default, Auto-GPT uses DALL-e for image generation. To use Stable Diffusion, a HuggingFace API Token is required.

Once you have a token, set these variables in your .env:

IMAGE_PROVIDER=sd

HUGGINGFACE_API_TOKEN="YOUR_HUGGINGFACE_API_TOKEN"

Cette expérience vise à démontrer le potentiel de GPT-4, mais elle comporte certaines limites :

- Il ne s'agit pas d'une application ou d'un produit fini, mais d'une expérience.

- Il se peut que les résultats ne soient pas satisfaisants dans des scénarios commerciaux complexes et réels. En fait, si c'est le cas, veuillez partager vos résultats !

- Assez coûteux à gérer, alors définissez et surveillez les limites de votre clé API avec OpenAI !

Avis de non-responsabilité Ce projet, Auto-GPT, est une application expérimentale et est fourni "tel quel" sans aucune garantie, expresse ou implicite. En utilisant ce logiciel, vous acceptez d'assumer tous les risques associés à son utilisation, y compris, mais sans s'y limiter, la perte de données, la défaillance du système ou tout autre problème pouvant survenir.

Les développeurs et les contributeurs de ce projet n'acceptent aucune responsabilité pour les pertes, dommages ou autres conséquences pouvant résulter de l'utilisation de ce logiciel. Vous êtes seul responsable de toutes les décisions et actions prises sur la base des informations fournies par Auto-GPT.

**Veuillez noter que l'utilisation du modèle de langage GPT-4 peut être coûteuse en raison de l'utilisation de jetons **En utilisant ce projet, vous reconnaissez que vous êtes responsable du contrôle et de la gestion de votre propre utilisation de jetons et des coûts associés. Il est fortement recommandé de vérifier régulièrement votre utilisation de l'API OpenAI et de mettre en place toutes les limites ou alertes nécessaires pour éviter des frais inattendus.

En tant qu'expérience autonome, Auto-GPT peut générer du contenu ou prendre des mesures qui ne sont pas conformes aux pratiques commerciales du monde réel ou aux exigences légales. Il est de votre responsabilité de vous assurer que toutes les actions ou décisions prises sur la base des résultats de ce logiciel sont conformes à toutes les lois, réglementations et normes éthiques applicables. Les développeurs et les contributeurs de ce projet ne peuvent être tenus responsables des conséquences de l'utilisation de ce logiciel.

En utilisant Auto-GPT, vous acceptez d'indemniser, de défendre et de dégager de toute responsabilité les développeurs, les contributeurs et toutes les parties affiliées contre toute réclamation, tout dommage, toute perte, toute responsabilité, tout coût et toute dépense (y compris les honoraires raisonnables d'avocat) résultant de votre utilisation de ce logiciel ou de votre violation de ces conditions.

Restez au courant des dernières nouvelles, mises à jour et réflexions sur Auto-GPT en suivant nos comptes Twitter. Engagez-vous avec le développeur et le propre compte de l'IA pour des discussions intéressantes, des mises à jour de projets, et plus encore.

- Développeur** : Suivez [@siggravitas] (https://twitter.com/siggravitas) pour obtenir des informations sur le processus de développement, des mises à jour sur le projet et des sujets connexes de la part du créateur de l'Entrepreneur-GPT.

- Entrepreneur-GPT: Join the conversation with the AI itself by following @En_GPT. Share your experiences, discuss the AI's outputs, and engage with the growing community of users.

We look forward to connecting with you and hearing your thoughts, ideas, and experiences with Auto-GPT. Join us on Twitter and let's explore the future of AI together!

To run tests, run the following command:

python -m unittest discover tests

Pour exécuter les tests et voir la couverture, exécutez la commande suivante : ``python -m unittest tests ``` :

coverage run -m unittest discover tests

Ce projet utilise flake8 pour le linting. Pour lancer le linter, exécutez la commande suivante :

flake8 scripts/ tests/

# Ou, si vous voulez lancer flake8 avec la même configuration que l'IC :

flake8 scripts/ tests/ --select E303,W293,W291,W292,E305